Apples nye LLM: MM1 kan redusere behovet for flere spørsmål for å få ønsket resultat

2 min. lese

Publisert på

Les vår avsløringsside for å finne ut hvordan du kan hjelpe MSPoweruser opprettholde redaksjonen Les mer

Viktige merknader

- Apples MM1 er en ny AI-modell som trener på tekst- og bildedata, som potensielt driver Siri 2.0.

- MM1 bruker en multimodal tilnærming for å oppnå bedre ytelse og redusere behovet for flere spørsmål.

- MM1s unike arkitektur og MoE-modell lar den kjøre på enheter som iPhones.

Apple har vært relativt stille når det gjelder arbeidet med store språkmodeller (LLM), men en ny forskningsartikkel antyder at de tar igjen raskt. MM1 er en ny metode for å trene AI-modeller som kombinerer tekst- og bildedata, noe som kan øke hastigheten på treningen og redusere behovet for flere spørsmål for å få ønsket resultat. Dette kommer dager etter Apple kjøpte DarwinAI.

Hva er MM1?

MM1 er en familie av AI-modeller, med den største som når 30 milliarder parametere (mindre enn noen konkurrenter, men fortsatt kraftig). Parametere refererer til de numeriske verdiene som modellen bruker for å lære og representere verden. Et høyere antall parametere indikerer generelt en mer kompleks modell som kan håndtere et bredere spekter av oppgaver og produsere mer nyanserte utdata.

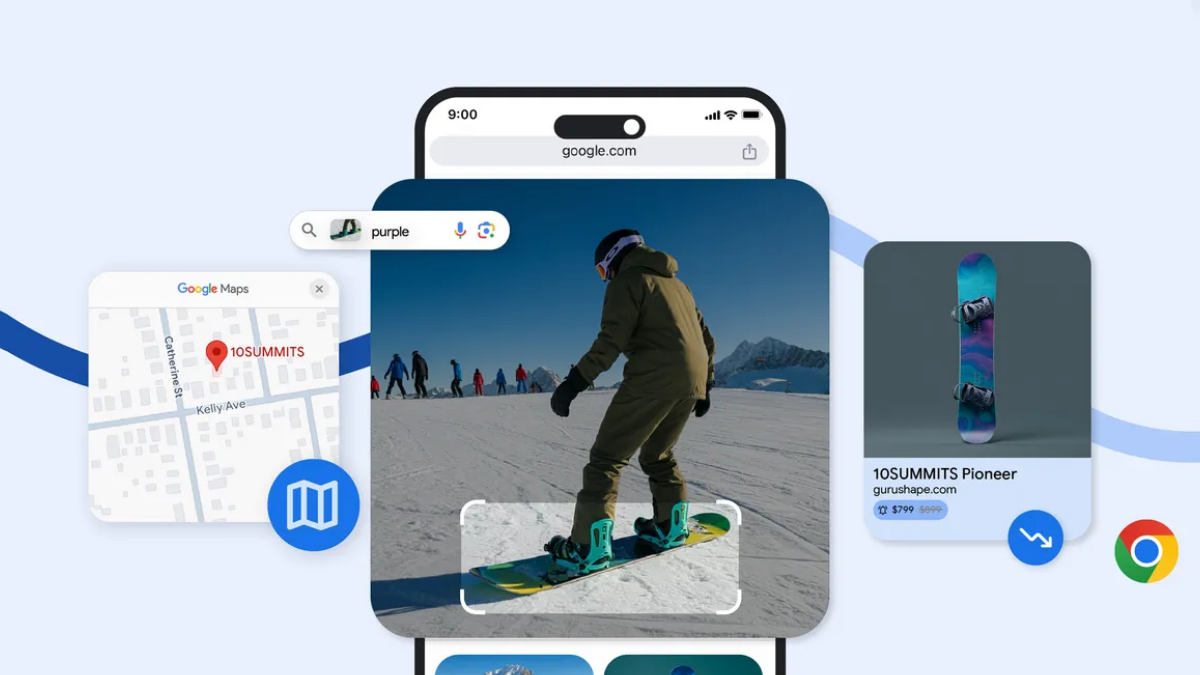

Den fokuserer på multimodal læring, noe som betyr at den kan behandle og forstå både tekst og bilder. Dette kan være et stort sprang fremover for Siri, slik at den bedre kan forstå forespørslene dine og svare med mer relevant informasjon. Forrige måned, Apple introduserte også en AI-bildemanipulator.

Forskerne bak MM1 argumenterer for at det å kombinere ulike typer treningsdata fører til bedre ytelse. MM1 bruker en blanding av bildetekster, kun tekstdata og visuelle spørsmålssvar for å trene modellen. Dette lar MM1 utføre oppgaver som bildeteksting, visuell svar på spørsmål og naturlig språkforståelse.

MM1 bruker en unik arkitektur med kodere med høyere bildeoppløsning og en annen tilnærming til forhåndstrening og merking av data. Den bruker også en blanding av eksperter (MoE)-modell for å skalere opp samtidig som behandlingskravene holdes lave, noe som betyr at den potensielt kan kjøre på enheter som iPhone og bærbare datamaskiner.

Forskningsartikkelen nevner ikke Siri eksplisitt, men fokuset på effektivitet, minimale spørsmål og multimodale muligheter antyder Apples retning for Siris fremtid. Tidligere, a leaker foreslo en smartere Siri med GenAI-abonnementstilbud.

Med Apple bringer andre LLM-er som Gemini til iPhone, ser det ut til at Apple tar en flersidig tilnærming til AI-fremskritt.

Mer her..

Brukerforum

0 meldinger