Het Phi-2 2.7B-model van Microsoft presteert beter dan het onlangs aangekondigde Google Gemini Nano-2 3.2B-model

2 minuut. lezen

Uitgegeven op

Lees onze openbaarmakingspagina om erachter te komen hoe u MSPoweruser kunt helpen het redactieteam te ondersteunen Lees meer

De afgelopen maanden heeft Microsoft Research een reeks kleine taalmodellen (SLM's) uitgebracht, genaamd "Phi". De Phi-1 werd als eerste uitgebracht met 1.3 miljard parameters en was gespecialiseerd in standaard Python-codering. In september publiceerde Microsoft Research uitgebracht Phi-1.5-model met 1.3 miljard parameters, maar het werd getraind met een nieuwe gegevensbron die verschillende synthetische NLP-teksten bevatte. Ondanks zijn kleine formaat leverde de phi-1.5 bijna state-of-the-art prestaties in vergelijking met andere modellen van vergelijkbare grootte.

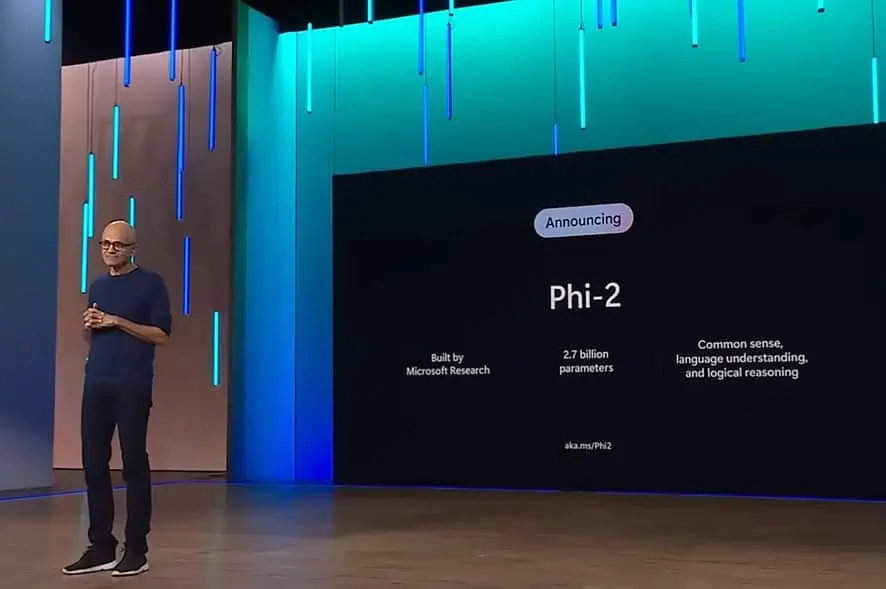

Vandaag heeft Microsoft de release aangekondigd van het Phi-2-model met 2.7 miljard parameters. Microsoft Research beweert dat deze nieuwe SLM state-of-the-art prestaties levert onder basistaalmodellen met minder dan 13 miljard parameters. Op sommige complexe benchmarks komt Phi-2 overeen met of overtreft modellen tot 25x groter.

Vorige week, Google aangekondigd Gemini-suite met taalmodellen. De Gemini Nano is het meest efficiënte model van Google, gebouwd voor taken op het apparaat, en kan rechtstreeks op mobiel silicium draaien. Het Gemini Nano-achtige kleine taalmodel maakt functies mogelijk zoals tekstsamenvatting, contextuele slimme antwoorden en geavanceerd proeflezen en grammaticacorrectie.

Volgens Microsoft komt het nieuwe Phi-2-model overeen met of overtreft het de nieuwe Google Gemini Nano-2, ondanks dat het kleiner van formaat is. Hieronder vindt u de benchmarkvergelijking tussen de Google Gemini Nano-2- en Phi-2-modellen.

| Model | Maat | BBH | BoolQ | MBPP | MMLU |

|---|---|---|---|---|---|

| Tweeling Nano 2 | 3.2B | 42.4 | 79.3 | 27.2 | 55.8 |

| Phi-2 | 2.7B | 59.3 | 83.3 | 59.1 | 56.7 |

Phi-2 presteert niet alleen beter dan Gemini Nano-2, maar overtreft ook de prestaties van Mistral- en Llama-2-modellen bij 7B- en 13B-parameters op verschillende benchmarks. Hieronder vindt u de details.

| Model | Maat | BBH | Gezond verstand Redenering | Taal Begrip | Math | codering |

|---|---|---|---|---|---|---|

| Lama-2 | 7B | 40.0 | 62.2 | 56.7 | 16.5 | 21.0 |

| 13B | 47.8 | 65.0 | 61.9 | 34.2 | 25.4 | |

| 70B | 66.5 | 69.2 | 67.6 | 64.1 | 38.3 | |

| mistral | 7B | 57.2 | 66.4 | 63.7 | 46.4 | 39.4 |

| Phi-2 | 2.7B | 59.2 | 68.8 | 62.0 | 61.1 | 53.7 |

Terwijl de vorige twee phi-modellen beschikbaar werden gesteld op Hugging Face, Phi-2 is beschikbaar gemaakt in de Azure-modelcatalogus. U kunt meer leren over Phi-2 hier.