Microsoft legt uit waarom LLM's hallucineren en antwoorden verzinnen

2 minuut. lezen

Bijgewerkt op

Lees onze openbaarmakingspagina om erachter te komen hoe u MSPoweruser kunt helpen het redactieteam te ondersteunen Lees meer

Een recente Twitter-uitwisseling tussen een gebruiker en een Microsoft-manager heeft hernieuwde aandacht gevestigd op de beperkingen van grote taalmodellen (LLM's) zoals Bing en het potentieel voor informatielacunes wanneer uitsluitend op hun interne kennis wordt vertrouwd.

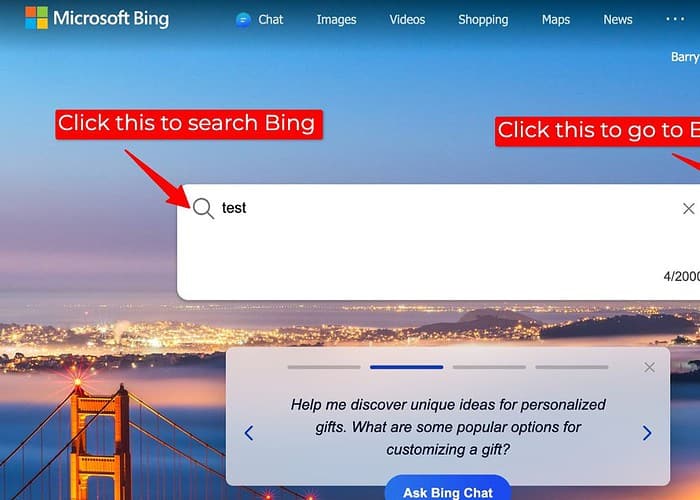

De discussie kwam voort uit een gebruiker die onnauwkeurige zoekresultaten rapporteerde op Bing toen de zoekplug-in, die toegang heeft tot externe webgegevens, was uitgeschakeld. In reactie hierop erkende Mikhail Parakhin, CEO van Advertising & Web Services bij Microsoft, de mogelijkheid dat LLM’s in dergelijke situaties ‘dingen verzinnen’.

Hij legde uit dat LLM's, wanneer zij verstoken zijn van de enorme hoeveelheid informatie die via internet beschikbaar is, soms hun toevlucht kunnen nemen tot hun interne kennisbank, een verzameling tekst en code die voor training wordt gebruikt, om reacties te genereren. Deze interne generatie is echter mogelijk niet altijd accuraat of in overeenstemming met de feitelijke realiteit, wat kan leiden tot mogelijke discrepanties in de zoekresultaten vergeleken met de zoekresultaten die worden verkregen met de zoekplug-in ingeschakeld.

Voor mij roept dit belangrijke vragen op over transparantie en nauwkeurigheid bij door LLM aangedreven zoekopdrachten, vooral wanneer externe gegevensbronnen niet beschikbaar zijn. Wanneer LLM's antwoorden genereren zonder toegang te krijgen tot externe gegevens, moeten gebruikers een duidelijke indicatie krijgen van de bron van de informatie en eventuele beperkingen.

Hoewel het geven van antwoorden waardevol is, moeten LLM's voorrang geven aan betrouwbare informatie boven het opvullen van kennislacunes met mogelijk onnauwkeurige interne generaties. Het verkennen van alternatieve benaderingen, zoals het aangeven van onzekerheid, het voorstellen van verder onderzoek, of eenvoudigweg stellen dat er geen antwoord beschikbaar is, kan het vertrouwen vergroten en de verspreiding van verkeerde informatie voorkomen.

Het is dan ook geen wonder waarom mensen geven de voorkeur aan ChatGPT boven Bing Chat/Copilot.

En om deze redenen geef ik er persoonlijk de voorkeur aan om Bard te gebruiken, omdat Google een functionaliteit heeft geboden waarbij Bard gebruikers laat weten of de informatie ergens anders vandaan komt of niet, waardoor het voor gebruikers gemakkelijker wordt om de informatie te vertrouwen.

Gebruikersforum

0 berichten