Microsoft kondigt Phi-3-vision aan, een nieuwe multimodale SLM voor AI-scenario's op apparaten

1 minuut. lezen

Bijgewerkt op

Lees onze openbaarmakingspagina om erachter te komen hoe u MSPoweruser kunt helpen het redactieteam te ondersteunen Lees meer

Belangrijkste opmerkingen

- Phi-3-vision is een 4.2B-parametermodel dat algemene visuele redeneringstaken en diagram-/grafiek-/tabel-redenering ondersteunt

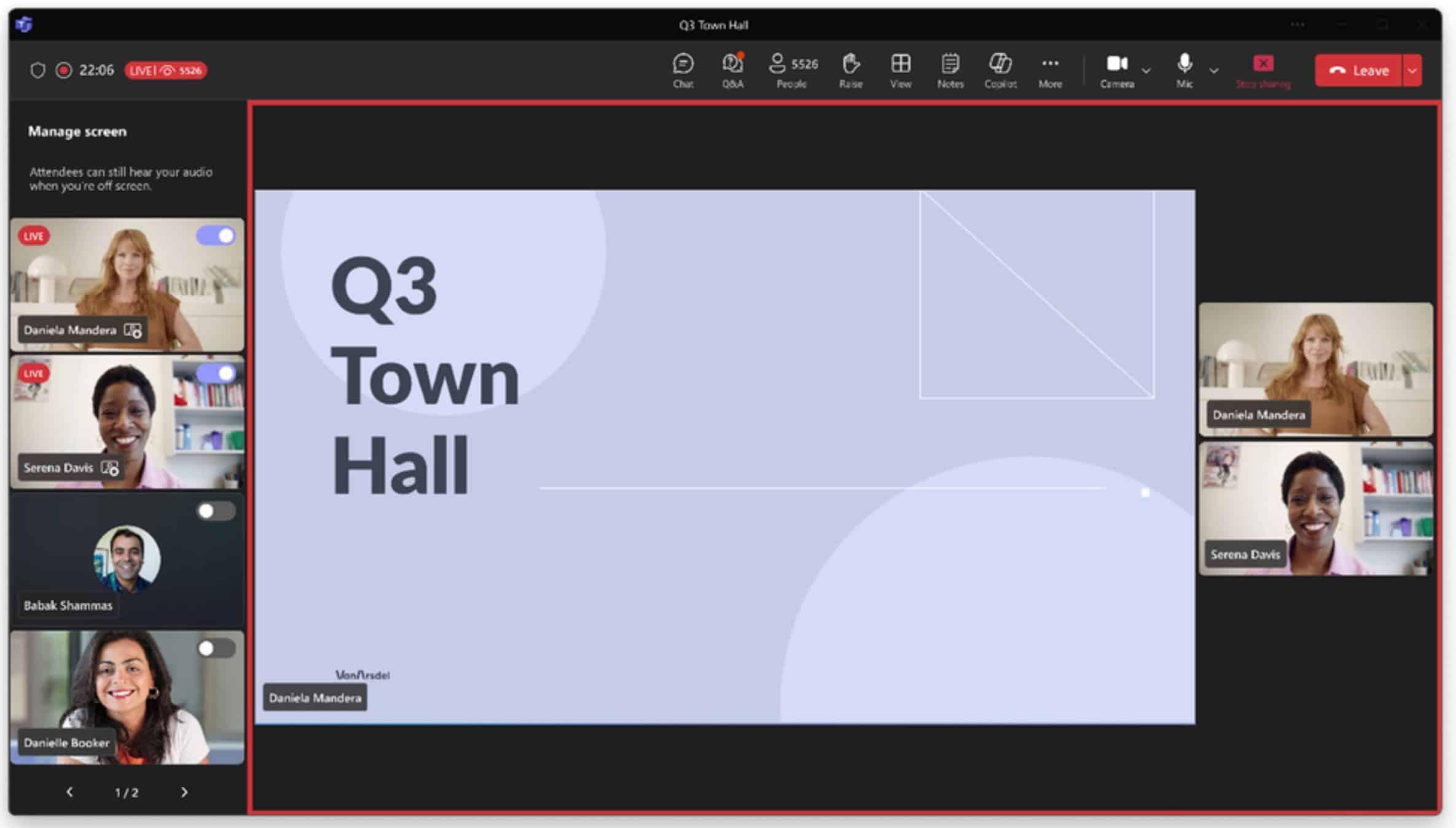

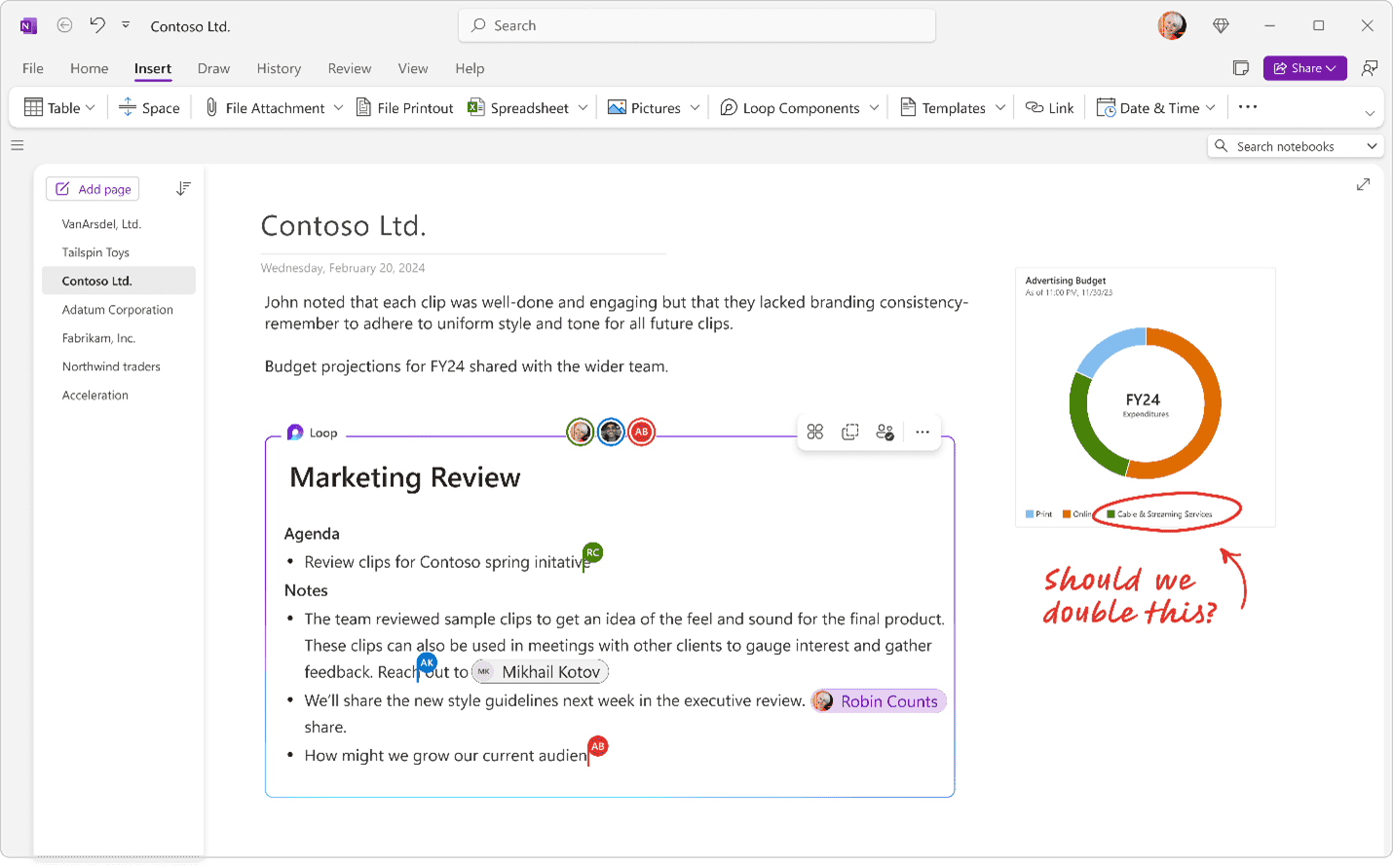

Microsoft vandaag op Build 2024 uitgebreid zijn Phi-3-familie van AI-kleintaalmodellen met de nieuwe Phi-3-visie. Phi-3-vision is een 4.2B-parametermodel dat algemene visuele redeneringstaken en diagram-/grafiek-/tabel-redenering ondersteunt. Het model kan zowel afbeeldingen als tekst als invoer gebruiken en tekstreacties uitvoeren.

Microsoft heeft vandaag ook de algemene beschikbaarheid aangekondigd van Phi-3-mini in het Models-as-a Service (MaaS)-aanbod van Azure AI. Phi-3-modellen winnen aan momentum omdat ze kosteneffectief zijn en geoptimaliseerd voor on-device, edge, offline inferentie en latency-gebonden AI-scenario's.

Naast het nieuws over Phi-3-modellen heeft Microsoft nieuwe functies voor API's aangekondigd om multimodale ervaringen mogelijk te maken. Azure AI Speech beschikt nu over spraakanalyse en universele vertaling. Azure AI Search wordt nu geleverd met aanzienlijk meer opslag en tot 12x grotere vectorindexgrootte, zonder extra kosten, om grote RAG-workloads op schaal mogelijk te maken.