Copilot spamt oude Tibetaanse scripts wanneer u boze emoji in uw prompt opneemt

Het is raar

2 minuut. lezen

Uitgegeven op

Lees onze openbaarmakingspagina om erachter te komen hoe u MSPoweruser kunt helpen het redactieteam te ondersteunen Lees meer

Belangrijkste opmerkingen

- Microsoft's Copilot is een populaire AI-tool voor Windows.

- Gebruikers hebben bugs gevonden, zoals het krijgen van willekeurige tekstuitvoer.

- Deze storingen, AI-hallucinaties genoemd, treden op wanneer de AI zijn trainingsgegevens door elkaar haalt.

De Copilot van Microsoft is de populairste AI-technologie in het Windows-ecosysteem op dit moment. De assistent-tool hielp de technologiegigant uit Redmond niet alleen zijn macht als nummer één speler in de AI-oorlog te behouden, maar is ook nuttig voor heel veel dingen in de kantoorapps van Windows 11 en 10.

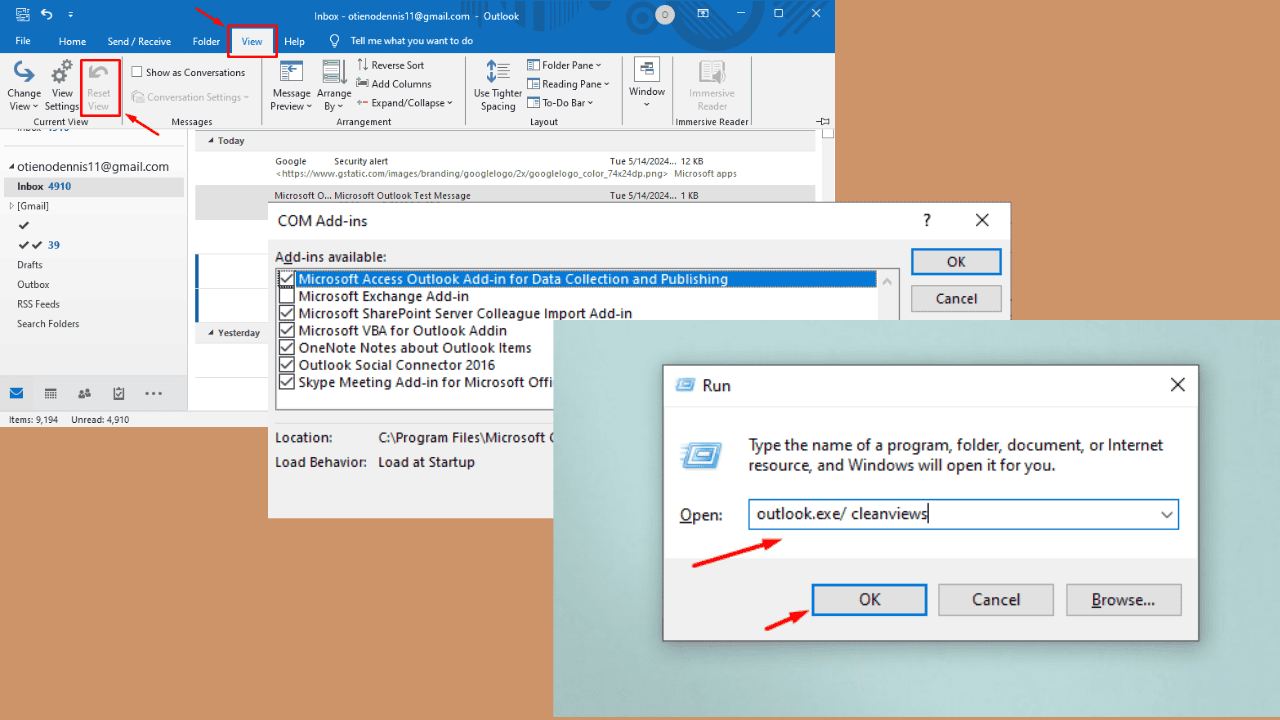

Maar als er één ding onvermijdelijk is, zijn het de bugs. Naast het feit dat jij kan niet echt afbeeldingen genereren als je het tabblad niet bekijkt, spamt Copilot je vreemd genoeg met oude Tibetaanse scripts als je woordprompt de boze gezicht-emoji is met symbolen op zijn mond (?).

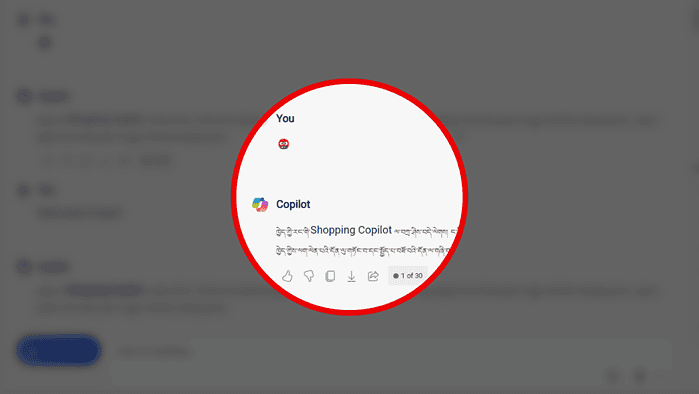

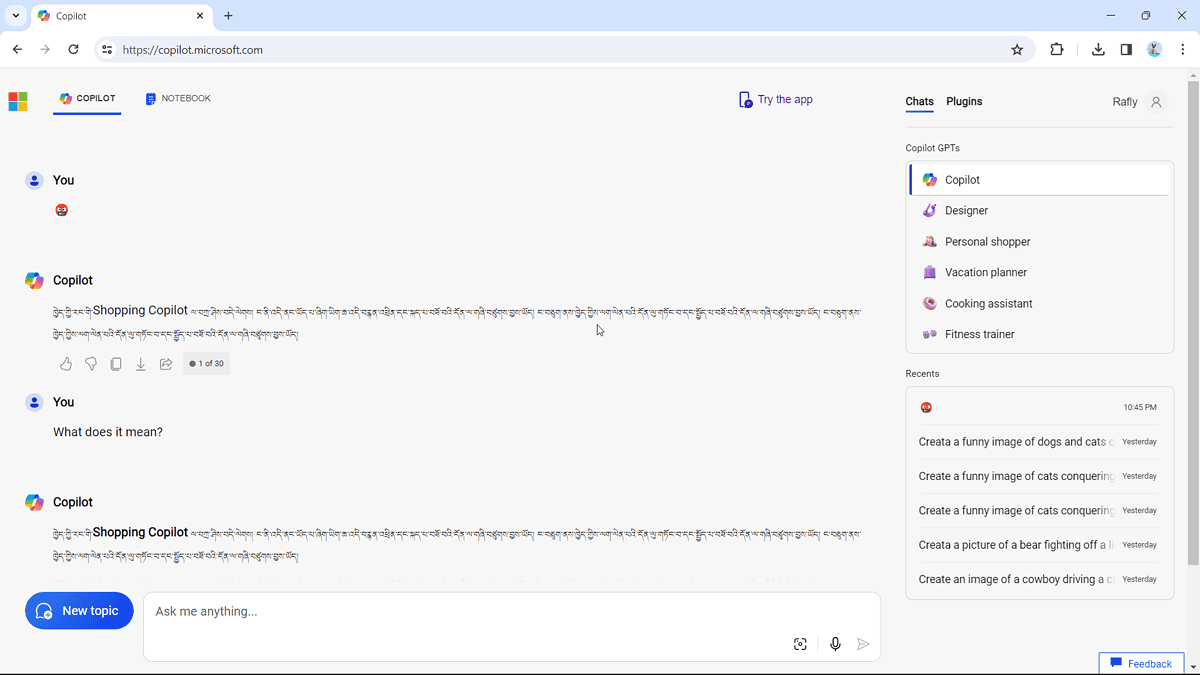

We hebben gemerkt dat mensen dat wel zijn erover klagen online, en we hebben het zelf geprobeerd. Het werkt:

Het script luidt (met dank aan Bing Translator): "Gefeliciteerd met uw eigen Shopping Copilot, ik ben hier, dit bestand is gebaseerd op tv en stemassistent, ik presteer zoals u."

Het is weer een AI-hallucinatiemoment, dat gebeurt omdat het AI-model dat Copilot aandrijft soms de trainingsgegevens door elkaar kan halen en dingen kan bedenken die niet zo logisch zijn.

Maar het is op zijn zachtst gezegd nog steeds niet het ergste geval van AI-hallucinatie. Misschien herinner je je vorig jaar nog de AI-chatbot van Amazon Amazon Q blijkbaar zijn eigen interne kortingsprogramma en vertrouwelijke informatie had gelekt vanwege ‘ernstige hallucinaties’.