Snowflake Arctic은 "엔터프라이즈 AI를 위한 최고의 LLM"이라는 자부심을 갖고 있습니다. 꽤 큰 주장이군요

지금 HuggingFace에서 Snowflake를 사용해 볼 수 있습니다.

2 분. 읽다

에 게시됨

공개 페이지를 읽고 MSPoweruser가 편집팀을 유지하는 데 어떻게 도움을 줄 수 있는지 알아보세요. 자세히 보기

주요 사항

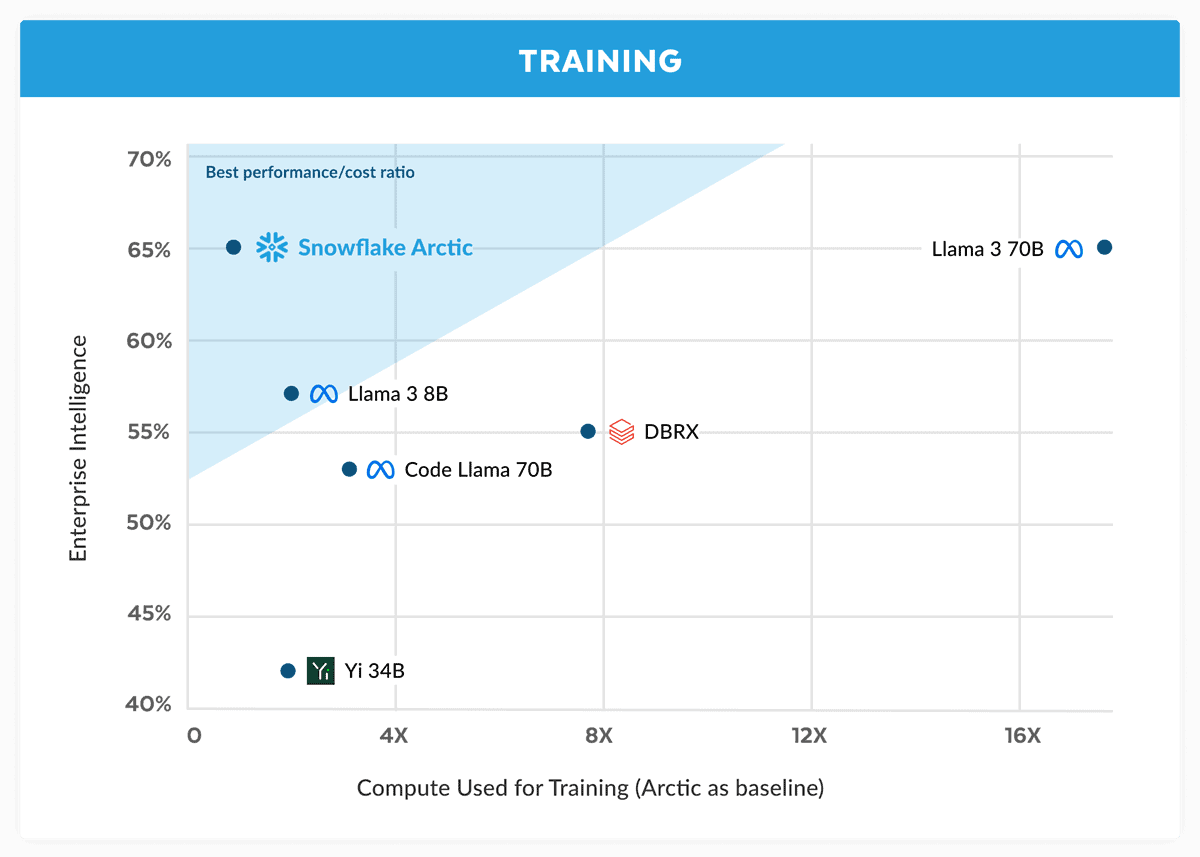

- Snowflake는 Arctic을 출시하며 Llama 3 70B와 경쟁할 수 있는 비용이 더 저렴하다고 주장합니다.

- Arctic은 코딩 및 SQL 생성과 같은 기업 작업에 탁월합니다.

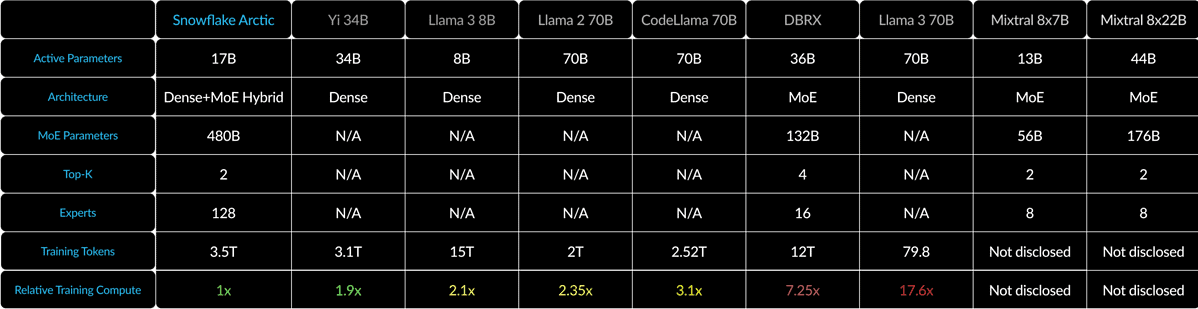

- Dense-MoE Hybrid를 사용하여 Arctic은 다양한 배치 크기에 대한 효율성을 최적화합니다.

처음에 전직 Oracle 과학자들이 설립한 클라우드 컴퓨팅 거대 기업인 Snowflake는 이제 AI 전쟁에서 거물급 플레이어들에게 도전하고 있습니다. 회사가 출범했습니다 눈송이 북극, 최신 "엔터프라이즈 AI를 위한 최고의 LLM"이며 Llama 3 70B와 동등하고 후자의 8B 변형보다 우수하다고 주장했습니다.

발표에서 Snowflake는 Arctic 모델이 Llama 3 70B의 성능과 일치하지만 컴퓨팅 요구 사항과 비용이 더 낮다고 주장합니다. 코딩(HumanEval+ 및 MBPP+), SQL 생성(Spider) 및 명령 따르기(IFEval)와 같은 영역 및 벤치마크의 엔터프라이즈 인텔리전스 작업에 이상적인 것으로 알려져 있습니다.

특히 그것을 고려하면 그것은 큰 주장입니다. 라마 3 70B 중요한 테스트에서 GPT-4 Turbo 및 Claude 3 Opus와 같은 다른 주요 모델에 비해 좋은 성능을 발휘했습니다. Meta의 향후 모델은 MMLU(주제 이해용), GPQA(생물학, 물리학, 화학, HumanEval(코딩))와 같은 벤치마크에서 좋은 점수를 받은 것으로 알려졌습니다.

Snowflake Arctic은 Dense-MoE Hybrid를 사용하여 10B 밀도 변압기와 128×3.66B MoE MLP를 혼합합니다. 이는 총 480B 매개변수이지만 상위 17 게이팅으로 선택된 2B만 적극적으로 사용됩니다.

1과 같은 작은 배치 크기의 경우 Arctic은 Code-Llama 4B에 비해 최대 70배, Mixtral 2.5x8B에 비해 최대 22배까지 메모리 읽기를 줄입니다. 그러나 배치 크기가 크게 증가함에 따라 Arctic은 컴퓨팅에 국한됩니다. CodeLlama 4B 및 Llama 70 3B보다 컴퓨팅 비용이 70배 적습니다.

Snowflake Arctic을 사용해 볼 수 있습니다. 포옹 얼굴. 또한 회사는 이 모델이 AWS, Microsoft Azure, Perplexity 등과 같은 다른 모델 가든에도 곧 출시될 것이라고 약속합니다.

사용자 포럼

0 메시지