NVIDIA와 Google이 협력하여 NVIDIA GPU에서 새로운 Google Gemma를 최적화합니다.

2 분. 읽다

에 게시됨

공개 페이지를 읽고 MSPoweruser가 편집팀을 유지하는 데 어떻게 도움을 줄 수 있는지 알아보세요. 자세히 보기

주요 사항

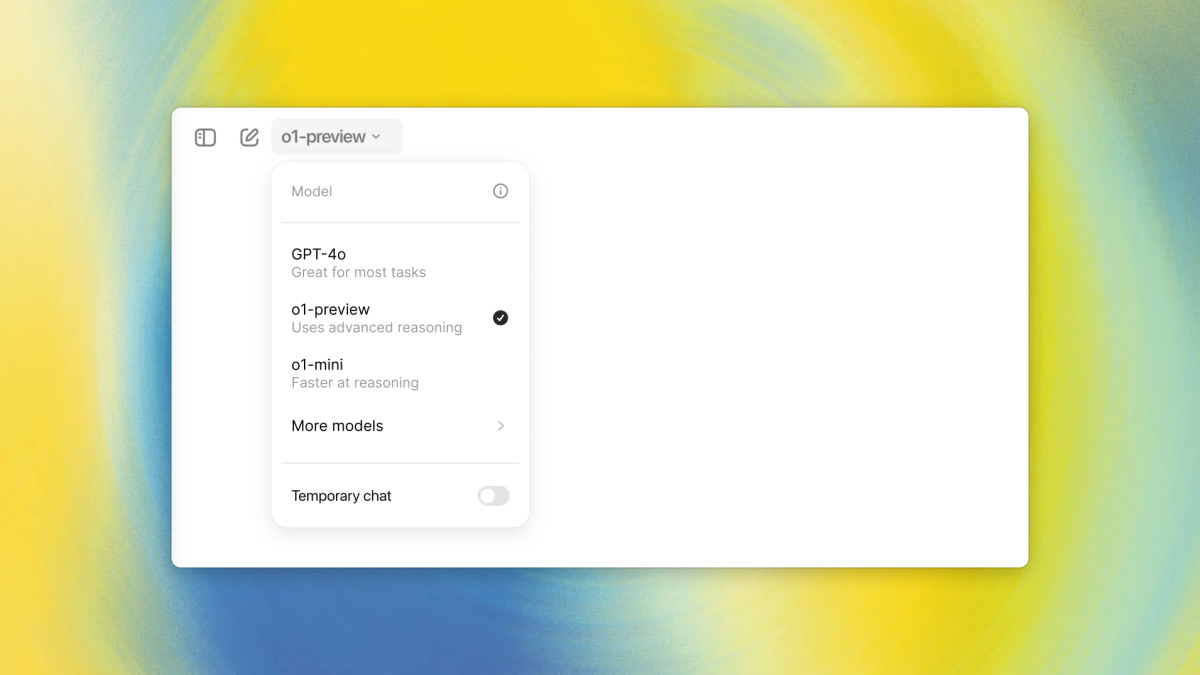

- Microsoft는 NVIDIA를 버리고 Google은 새로운 AI 모델을 최적화하기 위해 NVIDIA를 수용합니다.

- NVIDIA의 TensorRT-LLM은 로컬 PC를 포함한 다양한 플랫폼에서 Google Gemma의 속도를 높입니다.

- 개발자는 특정 요구 사항에 맞게 Gemma를 미세 조정하고 배포하기 위한 도구에 액세스할 수 있습니다.

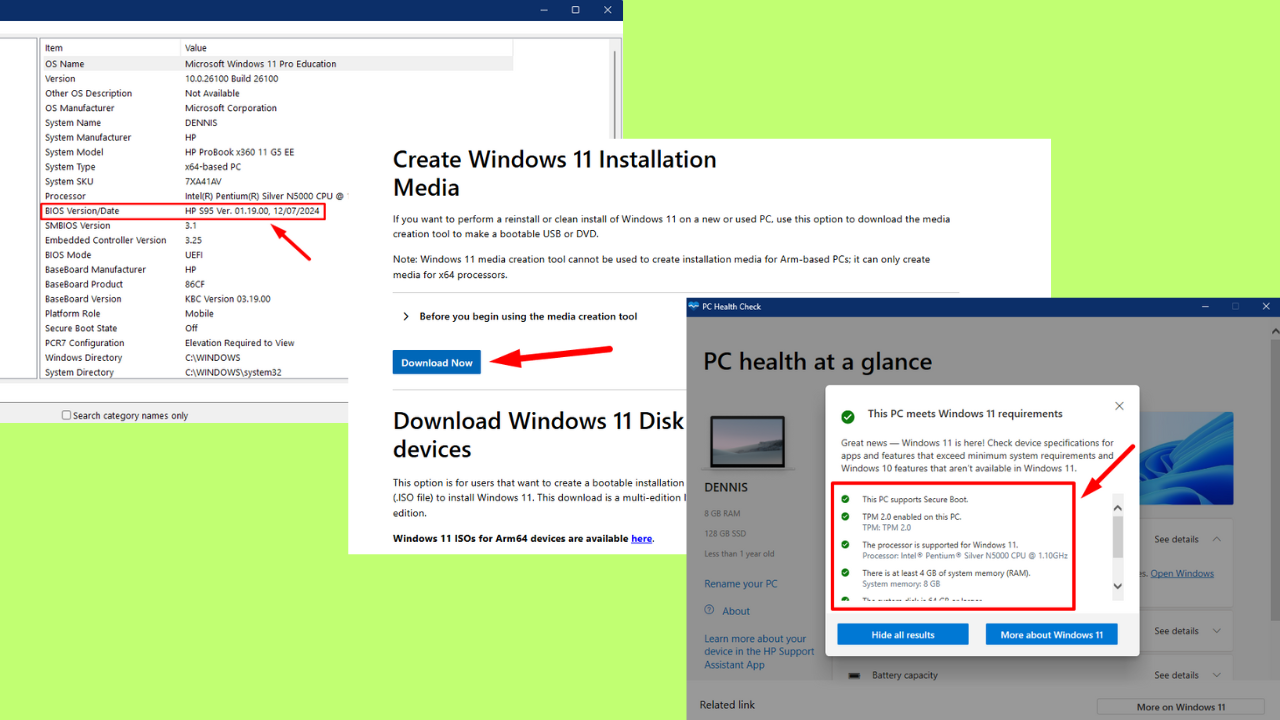

Microsoft는 최근 NVIDIA GPU에서 맞춤형 칩을 선호하기로 결정했다고 발표했지만, Google은 NVIDIA와 협력하여 NVIDIA GPU에서 새로운 경량 언어 모델인 Gemma를 최적화하는 정반대의 접근 방식을 취했습니다.

아체 하는 경량 언어 모델 구글에 의해 개발. 막대한 계산 리소스가 필요한 기존의 대형 언어 모델(LLM)과 달리 Gemma는 인상적인 기능을 제공하면서도 더 작은 크기(2억 및 7억 개의 매개변수 버전)를 자랑합니다.

이번 협력의 목표는 Gemma의 접근성과 성능을 크게 향상시켜 다양한 플랫폼에서 더 빠르고 광범위하게 사용할 수 있도록 하는 것입니다.

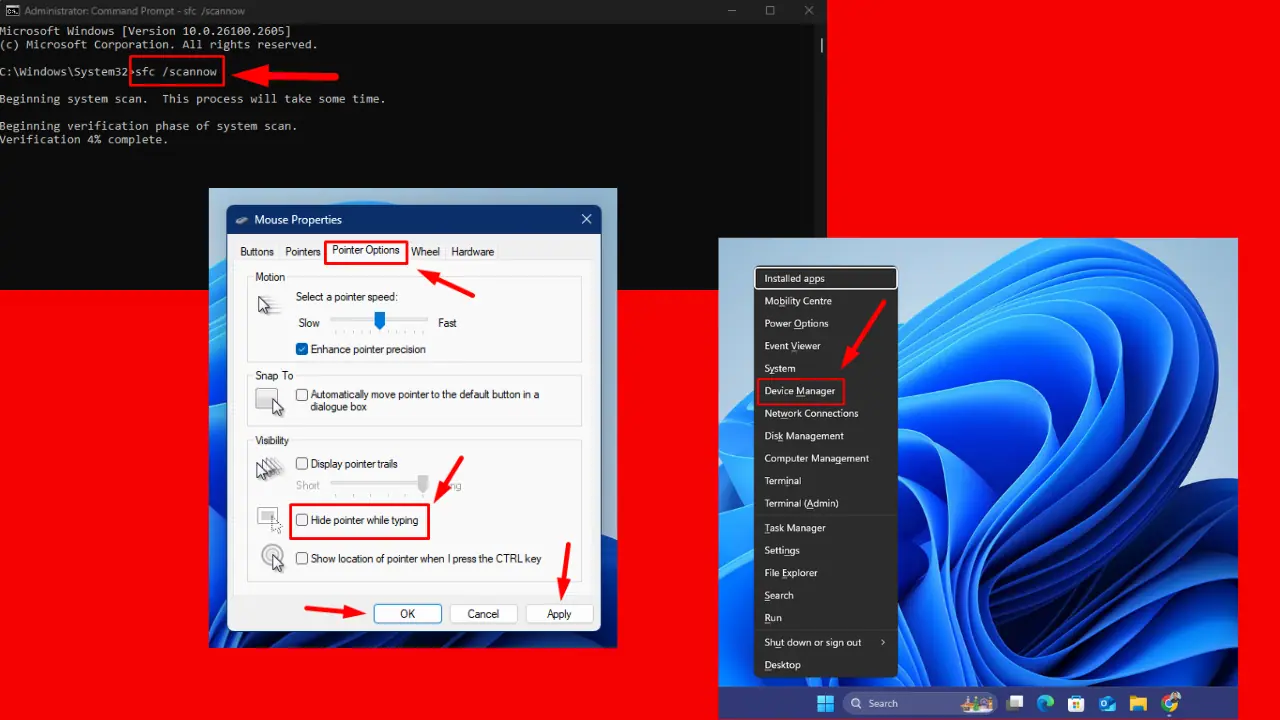

이 오픈 소스 라이브러리는 LLM 추론을 최적화하여 데이터 센터, 클라우드 환경, 심지어 NVIDIA RTX GPU가 장착된 개인용 컴퓨터의 NVIDIA GPU에서 더 빠른 성능을 지원합니다. 이번 협업은 전 세계적으로 100억 개가 넘는 NVIDIA RTX GPU와 H100 및 곧 출시될 H200 GPU를 갖춘 클라우드 플랫폼을 대상으로 합니다.

NeMo 프레임워크 및 TensorRT-LLM을 포함한 NVIDIA의 AI 엔터프라이즈 제품군은 개발자가 특정 사용 사례에 맞게 Gemma를 미세 조정하고 배포할 수 있도록 지원합니다.

사용자는 NVIDIA AI Playground를 통해 Gemma와 직접 상호 작용할 수 있으며 곧 Chat with RTX 데모를 통해 자신의 데이터로 챗봇을 개인화할 수 있습니다.

와 마이크로소프트는 엔비디아와 거리를 두고 있다, NVIDIA GPU에서 기술을 최적화하려는 Google의 움직임은 잠재적으로 파트너십을 강화할 가능성이 있음을 시사합니다. 이는 AI 및 언어 모델링의 발전으로 이어져 개발자와 사용자 모두에게 이익이 될 수 있습니다.

또한 RTX GPU를 통한 로컬 처리에 중점을 두어 사용자는 데이터 및 개인 정보 보호에 대한 더 큰 제어권을 확보하고 클라우드 기반 LLM 서비스와 관련된 문제를 잠재적으로 해결할 수 있습니다.

더 보기 LINK.

사용자 포럼

0 메시지