100억 개의 대규모 매개변수 모델을 훈련할 수 있는 새로운 딥 러닝 라이브러리인 Microsoft DeepSpeed를 만나보세요.

2 분. 읽다

에 업데이트 됨

공개 페이지를 읽고 MSPoweruser가 편집팀을 유지하는 데 어떻게 도움을 줄 수 있는지 알아보세요. 자세히 보기

마이크로소프트 리서치(Microsoft Research)는 오늘 100억 개의 거대한 매개변수 모델을 훈련할 수 있는 새로운 딥 러닝 최적화 라이브러리인 DeepSpeed를 발표했습니다. AI에서는 정확도를 높이려면 더 큰 자연어 모델이 필요합니다. 그러나 더 큰 자연어 모델을 훈련하는 것은 시간이 많이 걸리고 관련 비용이 매우 높습니다. Microsoft는 새로운 DeepSpeed 딥 러닝 라이브러리가 속도, 비용, 규모 및 사용성을 개선한다고 주장합니다.

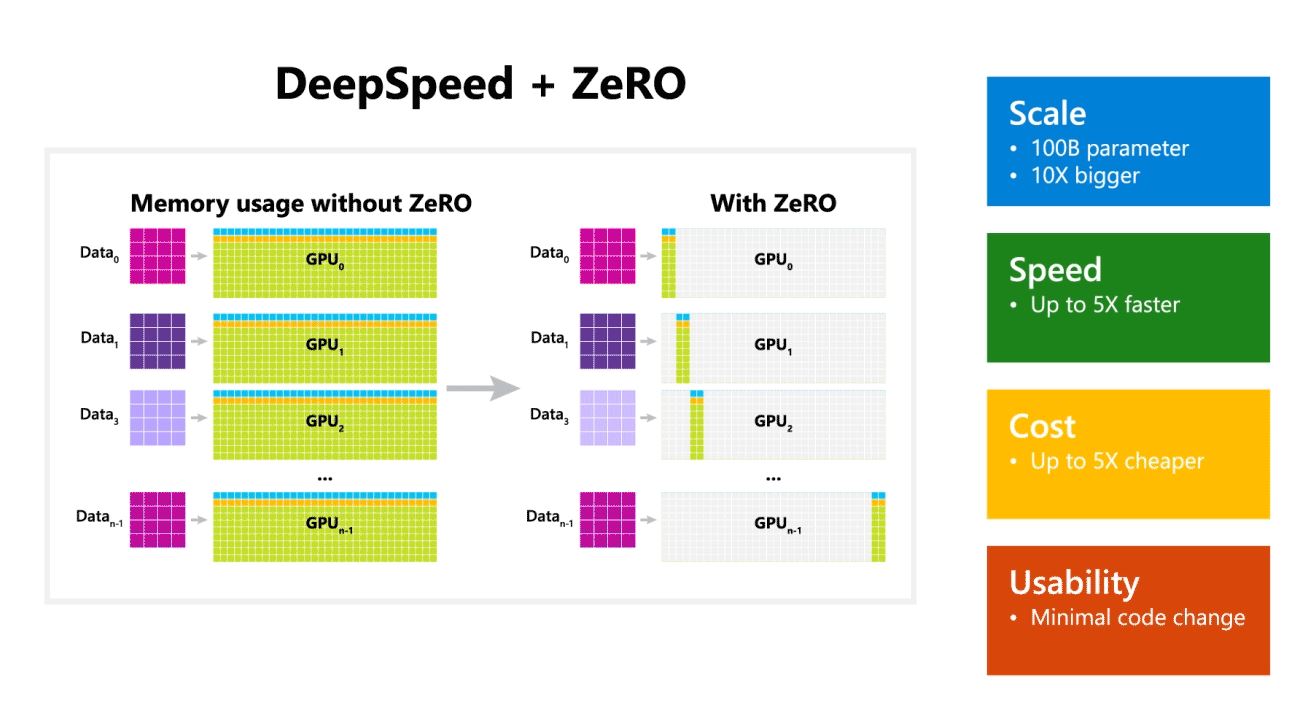

Microsoft는 또한 DeepSpeed가 최대 100억 개의 매개변수 모델로 언어 모델을 가능하게 하며 여기에는 모델 및 데이터 병렬 처리에 필요한 리소스를 줄이는 동시에 훈련할 수 있는 매개변수의 수를 늘리는 병렬화된 최적화 도구인 ZeRO(Zero Redundancy Optimizer)가 포함되어 있다고 언급했습니다. . Microsoft 연구원은 DeepSpeed 및 ZeRO를 사용하여 17억 개의 매개 변수가 있는 가장 큰 언어 모델인 새로운 Turing Natural Language Generation(Turing-NLG)을 개발했습니다.

DeepSpeed의 하이라이트:

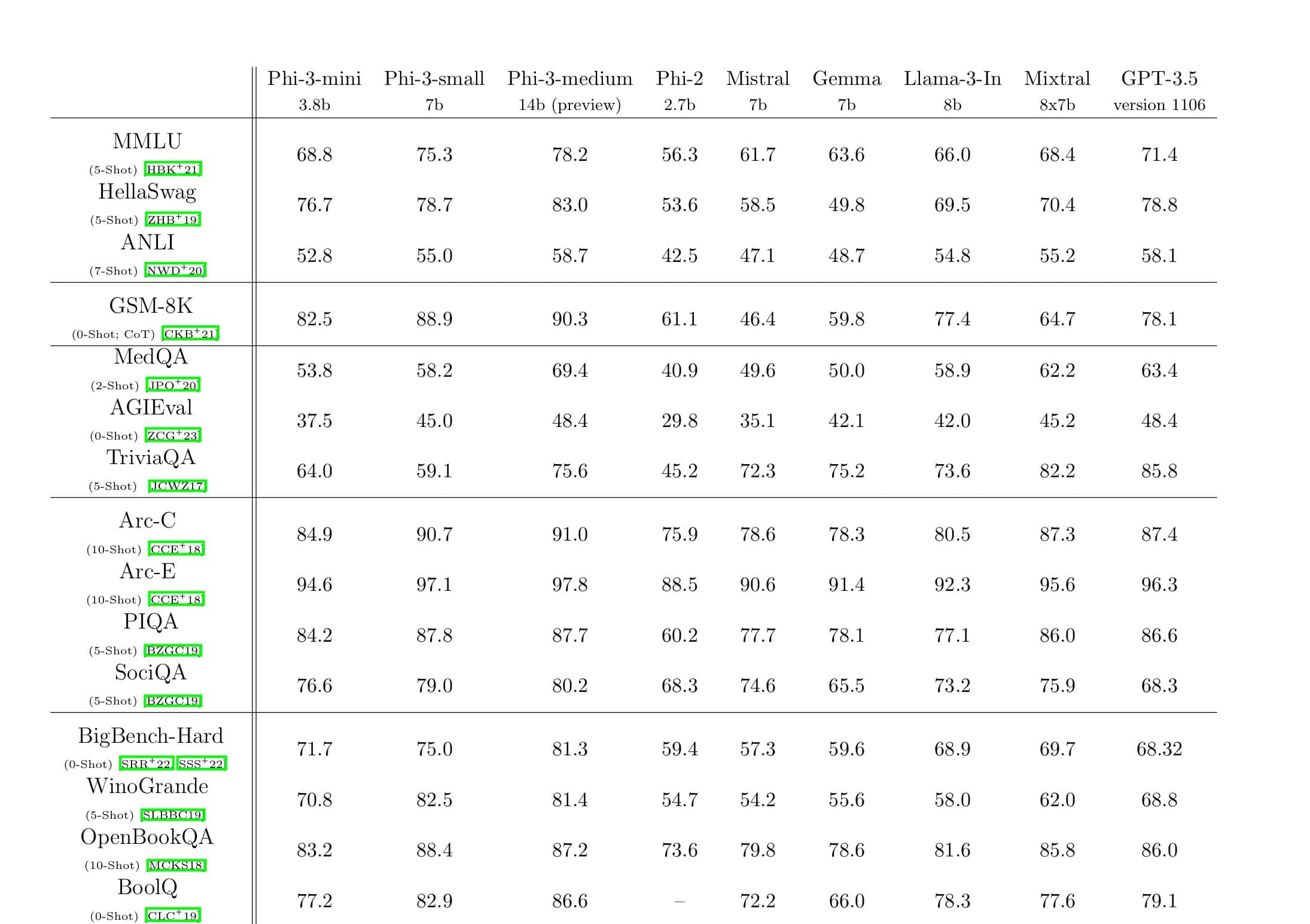

- 규모: OpenAI GPT-2, NVIDIA Megatron-LM, Google T5와 같은 최첨단 대형 모델의 크기는 각각 1.5억, 8.3억, 11억 매개변수입니다. DeepSpeed의 ZeRO 100단계는 10배 더 큰 최대 XNUMX억 개의 매개변수까지 모델을 실행할 수 있는 시스템 지원을 제공합니다.

- 속도: 다양한 하드웨어에서 최신 기술보다 최대 3.75배 높은 처리량을 관찰했습니다. 저대역폭 상호 연결(NVIDIA NVLink 또는 Infiniband 없음)이 있는 NVIDIA GPU 클러스터에서 2억 개의 매개변수가 있는 표준 GPT-1.5 모델에 대해 Megatron-LM만 사용할 때보다 2배 향상된 처리량을 달성합니다. 고대역폭 상호 연결이 있는 NVIDIA DGX-20 클러스터에서 80억~XNUMX억 개의 매개변수 모델의 경우 XNUMX~XNUMX배 더 빠릅니다.

- 비용: 향상된 처리량은 교육 비용을 크게 절감하는 것으로 해석될 수 있습니다. 예를 들어, 20억 개의 매개변수가 있는 모델을 훈련하려면 DeepSpeed는 XNUMX배 적은 리소스를 필요로 합니다.

- 편의성: PyTorch 모델에서 DeepSpeed 및 ZeRO를 사용하려면 몇 줄의 코드 변경만 필요합니다. 현재 모델 병렬 처리 라이브러리와 비교할 때 DeepSpeed는 코드 재설계 또는 모델 리팩토링이 필요하지 않습니다.

Microsoft는 DeepSpeed와 ZeRO를 모두 오픈 소싱하고 있습니다. 확인할 수 있습니다. 여기 GitHub에.

출처: Microsoft