Snowflake Arctic מתגאה כ"LLM הטוב ביותר עבור AI ארגוני". זו טענה די גדולה

אתה יכול לנסות את Snowflake ב- HuggingFace עכשיו

2 דקות לקרוא

פורסם ב

קרא את דף הגילויים שלנו כדי לגלות כיצד תוכל לעזור ל-MSPoweruser לקיים את צוות העריכה קראו עוד

הערות עיקריות

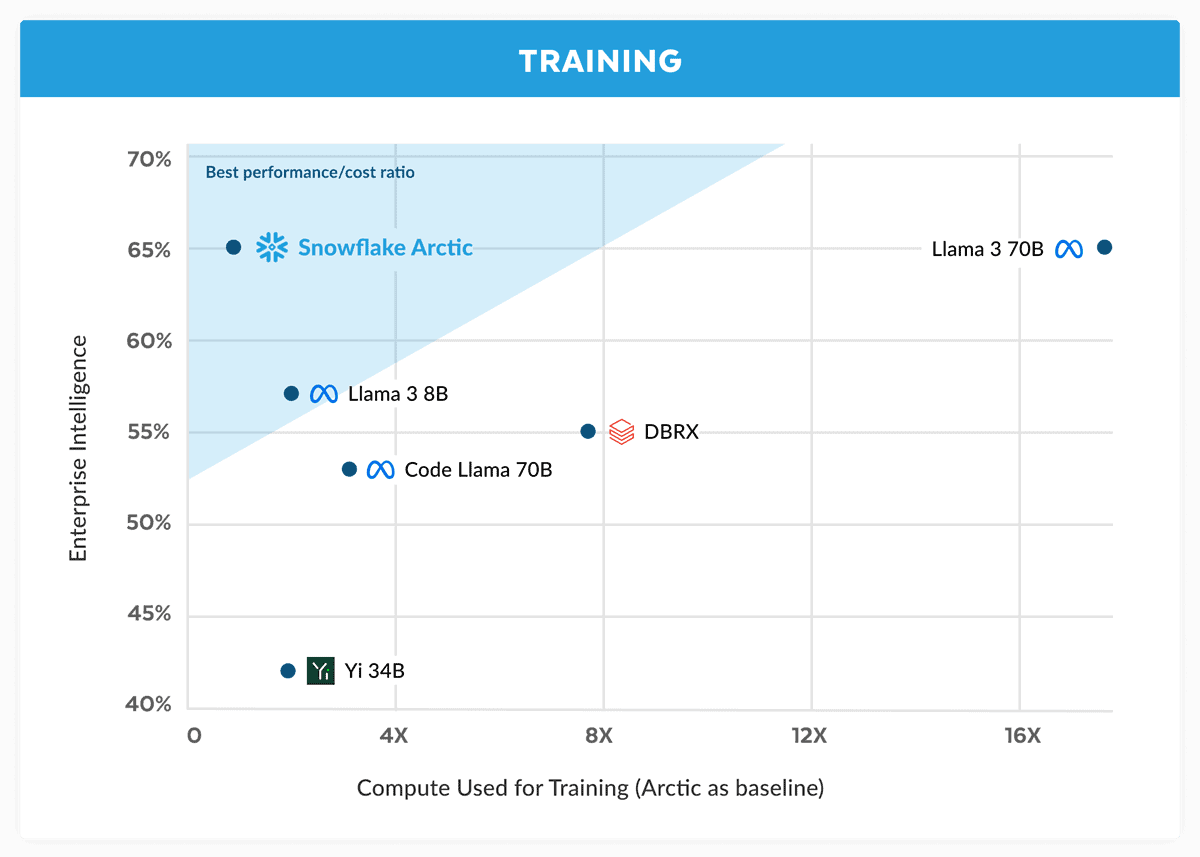

- Snowflake מציגה את Arctic, בטענה שהיא מתחרה ב-Llama 3 70B בעלויות נמוכות יותר.

- Arctic מצטיינת במשימות ארגוניות כמו קידוד ויצירת SQL.

- שימוש ב-Dense-MoE Hybrid, Arctic מייעל את היעילות עבור גדלי אצווה שונים.

Snowflake, ענקית מחשוב ענן שהוקמה בתחילה על ידי מדעני אורקל לשעבר, מאתגרת כעת שחקנים גדולים במלחמת הבינה המלאכותית. החברה השיקה פתית שלג ארקטי, "ה-LLM הטוב ביותר עבור בינה מלאכותית ארגונית", וטען שהוא טוב יותר מאשר בדומה ל-Llama 3 70B וטוב יותר מגרסה 8B של האחרון.

בהודעתה, Snowflake טוענת כי הדגם הארקטי תואם את הביצועים של Llama 3 70B אך עם דרישות מחשוב ועלויות נמוכות יותר. הוא נחשב כאידיאלי למשימות מודיעין ארגוניות בתחומים ובנצ'מרקים כגון קידוד (HumanEval+ ו-MBPP+), יצירת SQL (Spider) ומעקב אחר הוראות (IFEval).

זו טענה גדולה, במיוחד בהתחשב בכך לאמה 3 70B הציג ביצועים טובים מול דגמים גדולים אחרים כמו GPT-4 Turbo וקלוד 3 Opus במבחנים חשובים. על פי הדיווחים, המודל הקרוב של Meta מקבל ציונים טובים במדדים כמו MMLU (להבנת נושאים), GPQA (ביולוגיה, פיזיקה וכימיה, ו-HumanEval (קידוד).

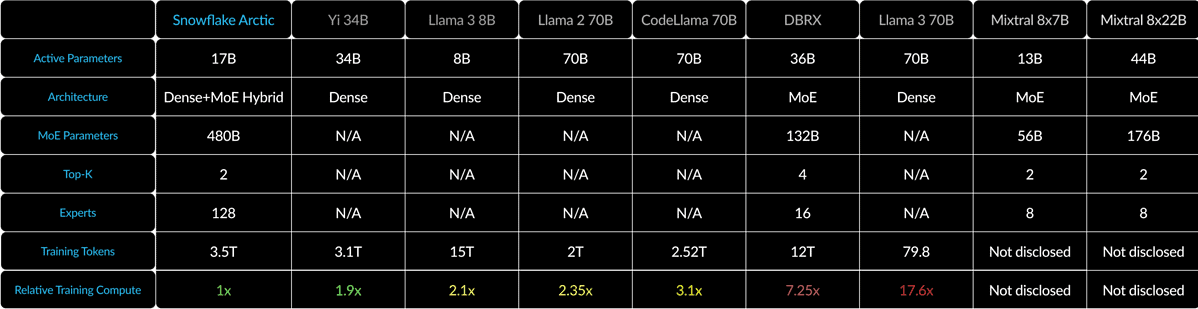

Snowflake Arctic מערבב שנאי צפוף 10B עם 128×3.66B MoE MLP באמצעות היבריד צפוף-MoE. זה מסתכם ב-480B פרמטרים, אבל רק 17B נמצאים בשימוש פעיל, שנבחרו עם שערים מובילים 2.

עבור גדלי אצווה קטנים כמו 1, Arctic מפחיתה את קריאות הזיכרון עד פי 4 בהשוואה ל-Code-Llama 70B ועד פי 2.5 פחות מ-Mixtral 8x22B. אבל, כאשר גדלי אצווה גדלים באופן משמעותי, Arctic הופך להיות קשור למחשוב. הוא מצריך פי 4 פחות מחשוב מאשר CodeLlama 70B ו-Llama 3 70B.

אתה יכול לנסות את Snowflake Arctic חיבוק פנים. החברה גם מבטיחה שהדגם יגיע בקרוב לגני דגמים נוספים כמו AWS, Microsoft Azure, Perplexity ועוד.

פורום משתמשים

0 הודעות