מיקרוסופט מסבירה מדוע אנשי לימודי תואר שני הוזים וממציאים תשובות

2 דקות לקרוא

עודכן בתאריך

קרא את דף הגילויים שלנו כדי לגלות כיצד תוכל לעזור ל-MSPoweruser לקיים את צוות העריכה קראו עוד

חילופי טוויטר שנערכו לאחרונה בין משתמש ובכיר במיקרוסופט הביאו תשומת לב מחודשת למגבלות של מודלים של שפה גדולה (LLMs) כמו Bing ולפוטנציאל לפערי מידע כאשר הם מסתמכים אך ורק על הידע הפנימי שלהם.

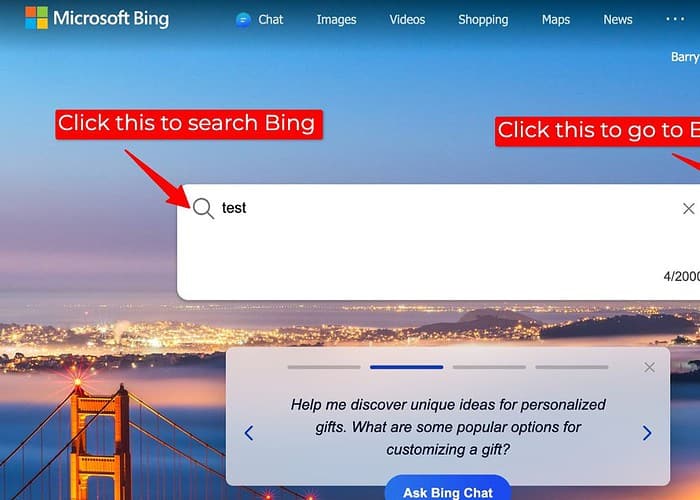

הדיון נבע ממשתמש שדיווח על תוצאות חיפוש לא מדויקות ב-Bing כאשר תוסף החיפוש שלו, הניגש לנתוני אינטרנט חיצוניים, הושבת. בתגובה, מיכאיל פארכין, מנכ"ל שירותי פרסום ואינטרנט במיקרוסופט, הודה באפשרות ש-LLMs "ממציאים דברים" במצבים כאלה.

הוא הסביר שכאשר נמנעים מהם המידע העצום הזמין דרך האינטרנט, אנשי LLM יכולים לפעמים להיעזר בבסיס הידע הפנימי שלהם, אוסף של טקסט וקוד המשמשים להדרכה, כדי ליצור תגובות. עם זאת, ייתכן שהדור הפנימי הזה לא תמיד יהיה מדויק או מותאם למציאות העובדתית, מה שמוביל לאי-התאמות פוטנציאליות בתוצאות החיפוש בהשוואה לאלו שהושגו כאשר תוסף החיפוש מופעל.

בעיני, זה מעלה שאלות חשובות לגבי שקיפות ודיוק בחיפושים המופעלים על ידי LLM, במיוחד כאשר מקורות נתונים חיצוניים אינם זמינים. כאשר LLMs מייצרים תגובות מבלי לגשת לנתונים חיצוניים, יש לתת למשתמשים אינדיקציה ברורה לגבי מקור המידע וכל מגבלה אפשרית.

אמנם מתן תשובות הוא בעל ערך, אבל על מנהלי לימודים ללימודי חינוך לתעדוף מידע אמין על פני מילוי פערי ידע עם דורות פנימיים שעלולים להיות לא מדויקים. בחינת גישות אלטרנטיביות, כגון ציון אי ודאות, הצעת מחקר נוסף, או פשוט קביעה שתשובה אינה זמינה, עשויה לשפר את האמון ולמנוע הפצת מידע מוטעה.

לפיכך, אין זה פלא מדוע אנשים מעדיפים ChatGPT על פני Bing Chat/Copilot.

ומסיבות אלו, אני אישית מעדיף להשתמש ב-Bard מכיוון שגוגל סיפקה פונקציונליות שבה בארד מאפשרת למשתמשים לדעת אם המידע מופנה ממקום אחר או לא, מה שמקל על המשתמשים לסמוך על המידע.

פורום משתמשים

0 הודעות