La Free Software Foundation pensa che GitHub Copilot dovrebbe essere illegale

3 minuto. leggere

Aggiornato su

Leggi la nostra pagina informativa per scoprire come puoi aiutare MSPoweruser a sostenere il team editoriale Per saperne di più

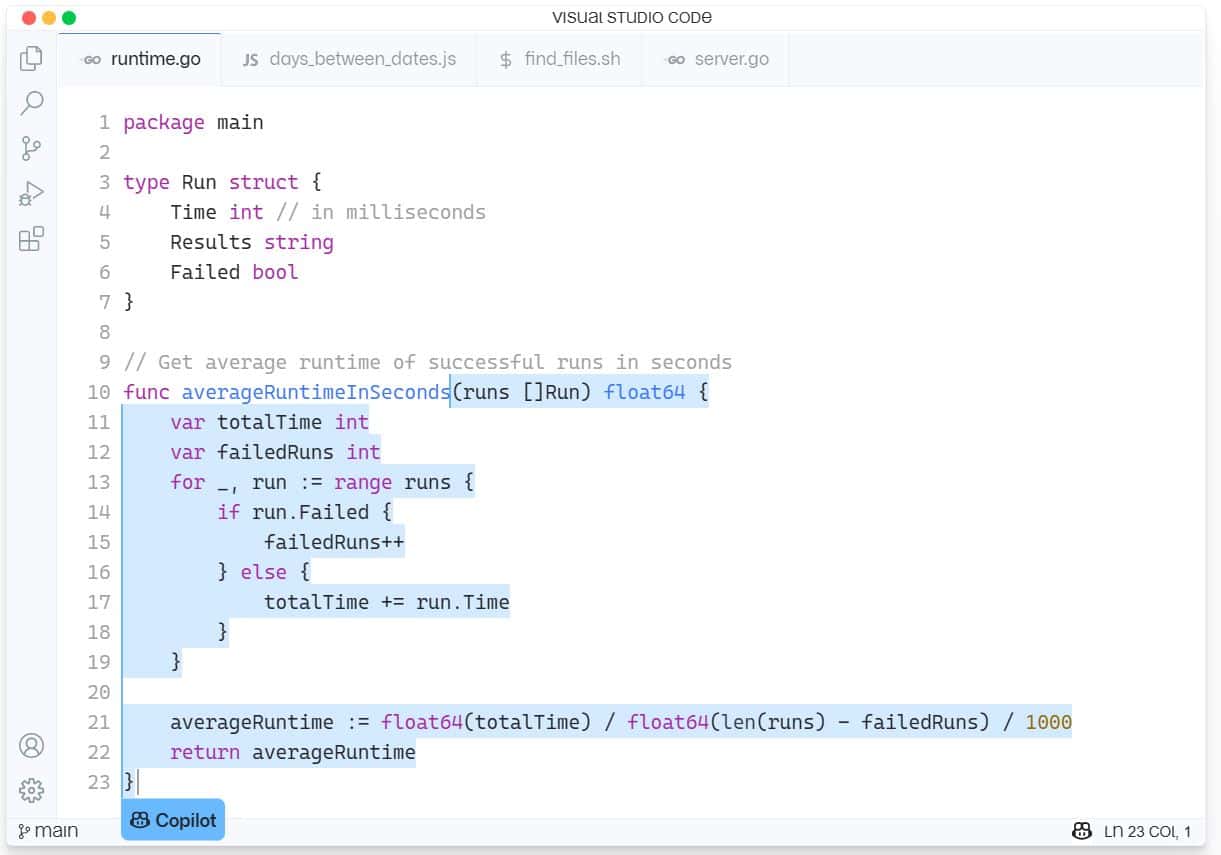

GitHub Copilot è un nuovo servizio di assistenza AI per lo sviluppo software integrato in Visual Studio Code di Microsoft. GitHub Copilot supporta una varietà di linguaggi e framework e semplifica la vita degli sviluppatori offrendo suggerimenti per intere righe o intere funzioni direttamente all'interno dell'IDE. GitHub Copilot è basato su OpenAI Codex ed è stato addestrato su miliardi di righe di codice open source.

L'ultimo problema ha fatto sì che la Free Software Foundation (FSF) avesse un'enorme ape nel cofano, definendo lo strumento "inaccettabile e ingiusto, dal nostro punto di vista".

Il sostenitore del software open source si lamenta del fatto che Copilot richiede l'esecuzione di software closed source come Visual Studio IDE di Microsoft o Visual Studio Code editor e che costituisce un "servizio come sostituto del software", il che significa che è un modo per acquisire potere sui computer di altre persone.

La FSF ha ritenuto che ci fossero numerosi problemi con Copilot che dovevano ancora essere testati in tribunale.

“Gli sviluppatori vogliono sapere se l'addestramento di una rete neurale sul loro software può essere considerato un uso corretto. Altri che potrebbero voler utilizzare Copilot si chiedono se i frammenti di codice e altri elementi copiati dai repository ospitati da GitHub potrebbero comportare una violazione del copyright. E anche se tutto potrebbe essere legalmente copacetico, gli attivisti si chiedono se non ci sia qualcosa di fondamentalmente ingiusto in una società di software proprietario che costruisce un servizio dal proprio lavoro", ha scritto la FSF.

Per rispondere a queste domande, la FSF ha richiesto white paper che esaminino i seguenti problemi:

- La formazione di Copilot sui repository pubblici viola i diritti d'autore? Giusto uso?

- Qual è la probabilità che l'output di Copilot generi reclami perseguibili di violazione di opere con licenza GPL?

- Gli sviluppatori che utilizzano Copilot possono rispettare le licenze di software libero come la GPL?

- In che modo gli sviluppatori possono garantire che il codice di cui detengono il copyright sia protetto dalle violazioni generate da Copilot?

- Se Copilot genera codice che dà luogo a una violazione di un'opera con licenza di software libero, come può essere scoperta questa violazione dal titolare del copyright?

- Un modello AI/ML addestrato è protetto da copyright? Chi detiene i diritti d'autore?

- Organizzazioni come la FSF dovrebbero sostenere un cambiamento nella legge sul copyright pertinente a queste domande?

La FSF pagherà $ 500 per i white paper pubblicati e potrebbe rilasciare più fondi se sono giustificate ulteriori ricerche.

Coloro che vogliono fare un contributo possono inviarlo a [email protected] entro il 21 agosto. Leggi di più sul processo su FSF.org qui.

Microsoft ha risposto alla sfida in arrivo dicendo: "Questo è un nuovo spazio e siamo ansiosi di avviare una discussione con gli sviluppatori su questi argomenti e guidare il settore nella definizione di standard appropriati per la formazione di modelli di intelligenza artificiale".

Dato che Copilot a volte ruba intere funzioni da altre app Open Source, i nostri lettori sono d'accordo con FSF o FSF è ipocrita semplicemente perché è un'IA piuttosto che un codice umano che ripropone? Facci sapere la tua opinione nei commenti qui sotto.

Forum degli utenti

0 messaggi