Snowflake Arctic è orgoglioso di essere il "miglior LLM per l'intelligenza artificiale aziendale". Questa è un'affermazione piuttosto grande

Puoi provare Snowflake su HuggingFace adesso

2 minuto. leggere

Edizione del

Leggi la nostra pagina informativa per scoprire come puoi aiutare MSPoweruser a sostenere il team editoriale Per saperne di più

Note chiave

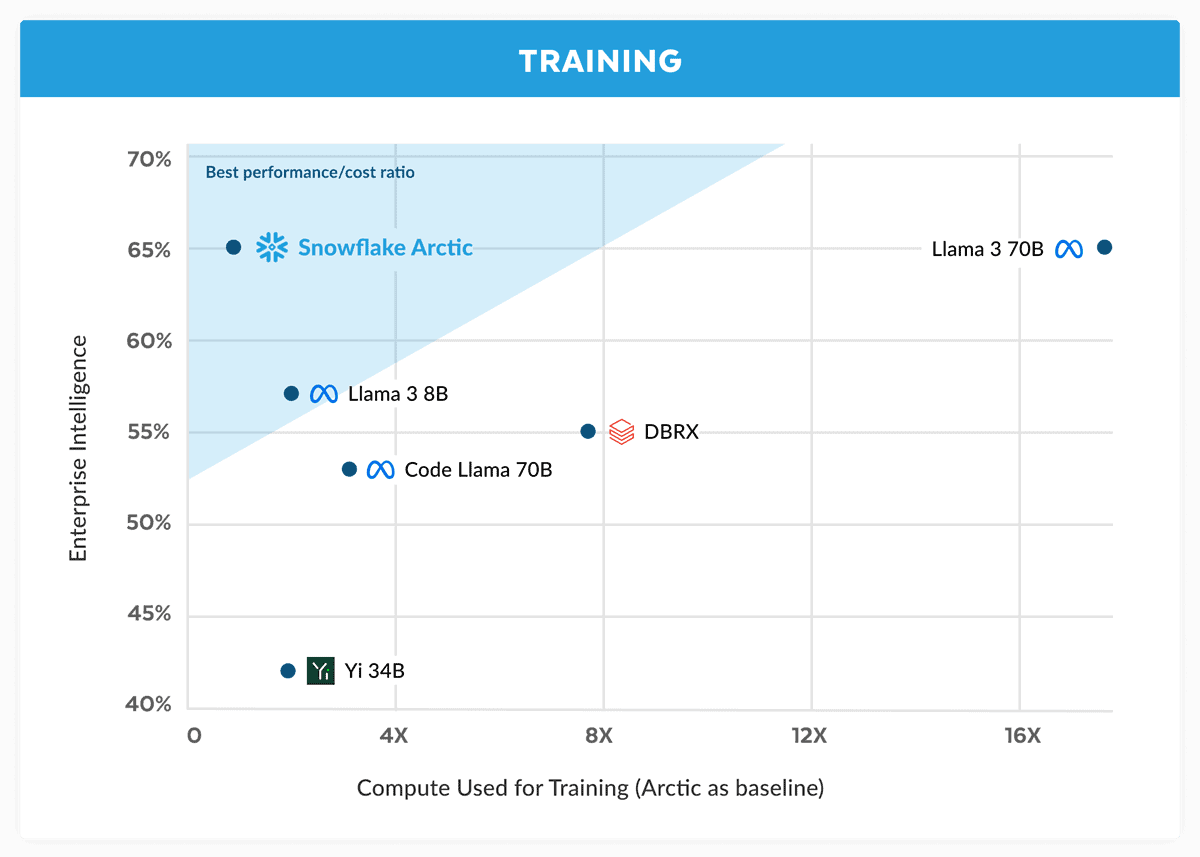

- Snowflake introduce Arctic, sostenendo che rivaleggia con Llama 3 70B con costi inferiori.

- Arctic eccelle in attività aziendali come la codifica e la generazione di SQL.

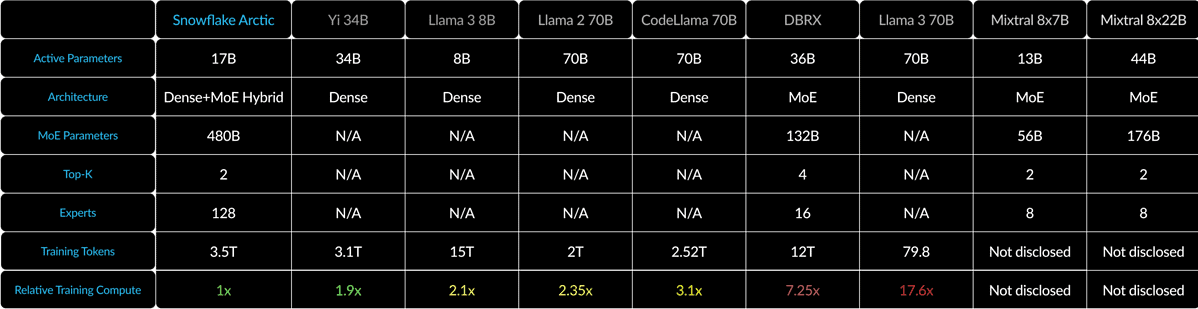

- Utilizzando un ibrido Dense-MoE, Arctic ottimizza l'efficienza per lotti di varie dimensioni.

Snowflake, un colosso del cloud computing formato inizialmente da ex scienziati Oracle, sta ora sfidando i grandi attori nella guerra dell’intelligenza artificiale. L'azienda è stata lanciata Fiocco di neve artico, il suo ultimo "miglior LLM per l'intelligenza artificiale aziendale" e ha affermato che è migliore che alla pari con Llama 3 70B e migliore della variante 8B di quest'ultimo.

Nel suo annuncio, Snowflake afferma che il modello Arctic corrisponde alle prestazioni del Llama 3 70B ma con requisiti e costi di calcolo inferiori. È pubblicizzato come ideale per attività di intelligence aziendale in aree e benchmark come la codifica (HumanEval+ e MBPP+), la generazione SQL (Spider) e il seguito delle istruzioni (IFEval).

Questa è una grande affermazione, soprattutto considerando questo Lama 3 70B si è comportato bene contro altri modelli importanti come GPT-4 Turbo e Claude 3 Opus in test importanti. Secondo quanto riferito, il prossimo modello di Meta ottiene buoni risultati in benchmark come MMLU (per comprendere le materie), GPQA (biologia, fisica e chimica e HumanEval (codifica).

Snowflake Arctic combina un trasformatore denso da 10B con un MLP MoE da 128×3.66B utilizzando un ibrido Dense-MoE. In totale sono 480B parametri, ma solo 17B vengono utilizzati attivamente, scelti con il gating top-2.

Per lotti di piccole dimensioni come 1, Arctic riduce le letture di memoria fino a 4 volte rispetto a Code-Llama 70B e fino a 2.5 volte in meno rispetto a Mixtral 8x22B. Ma, man mano che le dimensioni dei batch aumentano in modo significativo, l’Artico diventa vincolato al calcolo. Richiede un calcolo 4 volte inferiore rispetto a CodeLlama 70B e Llama 3 70B.

Puoi provare Snowflake Arctic su abbracciare il viso. L'azienda promette inoltre che il modello arriverà presto su altri giardini modello come AWS, Microsoft Azure, Perplexity e altri.

Forum degli utenti

0 messaggi