Microsoft presenta la famiglia di modelli Phi-3 che superano gli altri modelli della sua classe

2 minuto. leggere

Edizione del

Leggi la nostra pagina informativa per scoprire come puoi aiutare MSPoweruser a sostenere il team editoriale Per saperne di più

Nel dicembre 2023, Microsoft ha rilasciato Phi-2 modello con 2.7 miliardi di parametri che ha fornito prestazioni all'avanguardia tra i modelli del linguaggio di base con meno di 13 miliardi di parametri. Negli ultimi quattro mesi, molti altri modelli rilasciati hanno sovraperformato Phi-2. Recentemente, Meta ha rilasciato la famiglia di modelli Llama-3 che ha sovraperformato tutti i modelli open source rilasciati in precedenza.

Ieri sera, Microsoft Research ha annunciato la famiglia di modelli Phi-3 tramite un rapporto tecnico. Ci sono tre modelli nella famiglia Phi-3:

- phi-3-mini (3.8B)

- phi-3-piccolo (7B)

- phi-3-medio (14B)

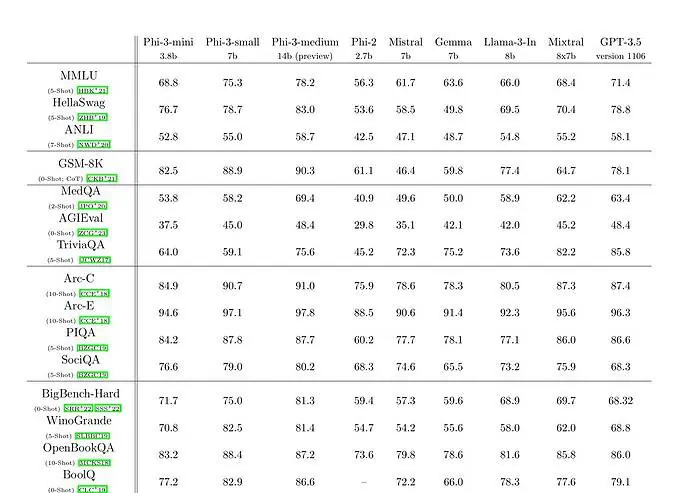

Il phi-3-mini con un modello linguistico da 3.8 miliardi di parametri viene addestrato su 3.3 trilioni di token. Secondo i benchmark, phi-3-mini batte Mixtral 8x7B e GPT-3.5. Microsoft afferma che questo modello è abbastanza piccolo da poter essere utilizzato su un telefono. Microsoft ha utilizzato una versione ingrandita del set di dati utilizzato per phi-2, composta da dati web fortemente filtrati e dati sintetici. Secondo i risultati dei benchmark di Microsoft nel Technical Paper, phi-3-small e phi-3-medium raggiungono un impressionante punteggio MMLU di 75.3 e 78.2 rispettivamente.

In termini di capacità LLM, sebbene il modello Phi-3-mini raggiunga un livello simile di comprensione del linguaggio e capacità di ragionamento di quelli di modelli molto più grandi, è ancora fondamentalmente limitato dalle sue dimensioni per determinati compiti. Il modello semplicemente non ha la capacità di immagazzinare una vasta conoscenza fattuale, cosa che può essere vista, ad esempio, con basse prestazioni su TriviaQA. Tuttavia, riteniamo che questa debolezza possa essere risolta potenziandola con un motore di ricerca.