Microsoft spiega perché i LLM hanno allucinazioni e inventano risposte

2 minuto. leggere

Aggiornato su

Leggi la nostra pagina informativa per scoprire come puoi aiutare MSPoweruser a sostenere il team editoriale Per saperne di più

Un recente scambio su Twitter tra un utente e un dirigente Microsoft ha portato rinnovata attenzione sui limiti dei grandi modelli linguistici (LLM) come Bing e sul potenziale di lacune informative quando si fa affidamento esclusivamente sulla propria conoscenza interna.

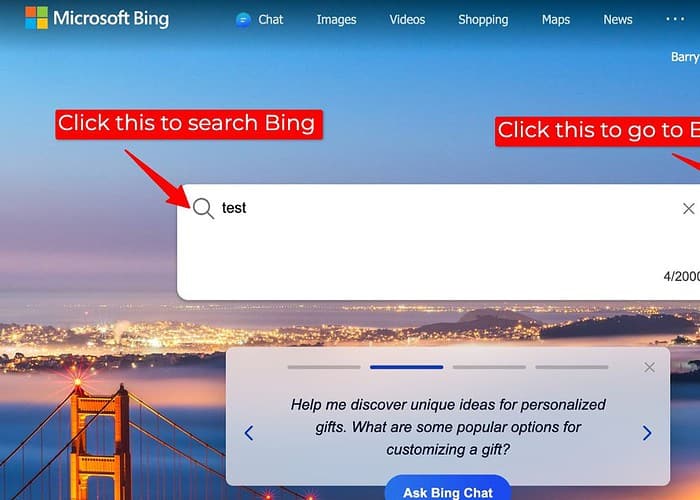

La discussione è nata da un utente che ha segnalato risultati di ricerca imprecisi su Bing quando il suo plug-in di ricerca, che accede a dati Web esterni, era disabilitato. In risposta, Mikhail Parakhin, CEO di Advertising & Web Services presso Microsoft, ha riconosciuto la possibilità che i LLM “inventino le cose” in tali situazioni.

Ha spiegato che, quando privati delle vaste informazioni disponibili attraverso il web, gli LLM possono talvolta ricorrere alla loro base di conoscenza interna, una raccolta di testo e codice utilizzata per la formazione, per generare risposte. Tuttavia, questa generazione interna potrebbe non essere sempre accurata o allineata con la realtà fattuale, portando a potenziali discrepanze nei risultati di ricerca rispetto a quelli ottenuti con il plug-in di ricerca abilitato.

Per me, ciò solleva importanti domande sulla trasparenza e l'accuratezza nelle ricerche basate su LLM, soprattutto quando le fonti di dati esterne non sono disponibili. Quando gli LLM generano risposte senza accedere a dati esterni, agli utenti dovrebbe essere fornita una chiara indicazione della fonte delle informazioni e di eventuali limitazioni.

Sebbene fornire risposte sia prezioso, gli LLM devono dare priorità a informazioni affidabili piuttosto che colmare le lacune di conoscenza con generazioni interne potenzialmente imprecise. Esplorare approcci alternativi, come indicare l’incertezza, suggerire ulteriori ricerche o semplicemente affermare che una risposta non è disponibile, potrebbe aumentare la fiducia e prevenire la diffusione della disinformazione.

Quindi, non c’è da meravigliarsi del perché le persone preferiscono ChatGPT rispetto a Bing Chat/Copilot.

E per questi motivi, personalmente preferisco utilizzare Bard perché Google ha fornito una funzionalità in cui Bard consente agli utenti di sapere se le informazioni fanno riferimento da qualche altra parte o meno, rendendo più facile per gli utenti fidarsi delle informazioni.

Forum degli utenti

0 messaggi