Model Phi-2 2.7B dari Microsoft mengungguli model Google Gemini Nano-2 3.2B yang baru-baru ini diumumkan

2 menit Baca

Ditampilkan di

Baca halaman pengungkapan kami untuk mengetahui bagaimana Anda dapat membantu MSPoweruser mempertahankan tim editorial Baca lebih lanjut

Selama beberapa bulan terakhir, Microsoft Research telah merilis serangkaian model bahasa kecil (SLM) yang disebut “Phi”. Phi-1 dirilis pertama kali dengan 1.3 miliar parameter dan dikhususkan untuk pengkodean dasar Python. Pada bulan September, Penelitian Microsoft dirilis Model Phi-1.5 dengan 1.3 miliar parameter, tetapi dilatih dengan sumber data baru yang mencakup berbagai teks sintetis NLP. Meskipun ukurannya kecil, phi-1.5 memberikan kinerja yang hampir tercanggih jika dibandingkan dengan model berukuran serupa lainnya.

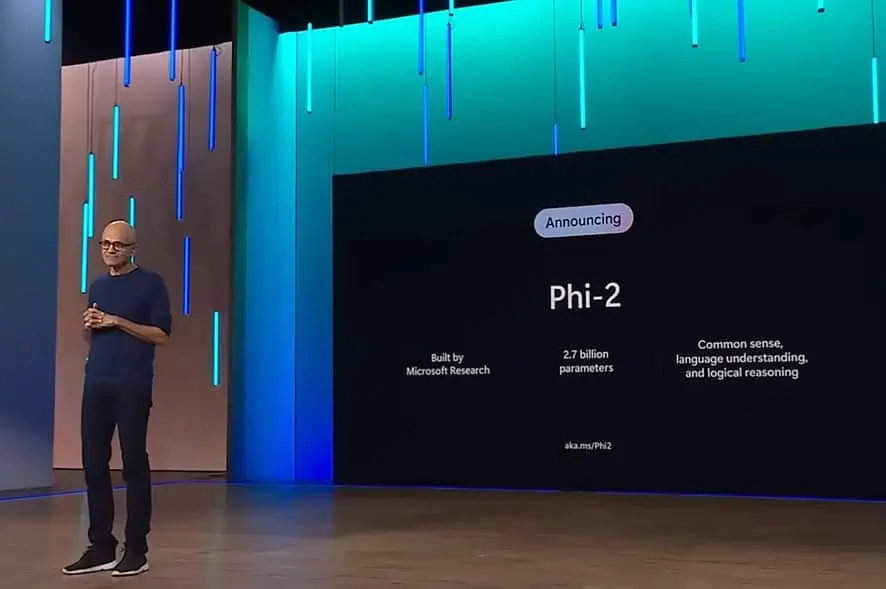

Hari ini, Microsoft mengumumkan peluncuran model Phi-2 dengan 2.7 miliar parameter. Microsoft Research mengklaim bahwa SLM baru ini memberikan kinerja canggih di antara model bahasa dasar dengan kurang dari 13 miliar parameter. Pada beberapa tolok ukur yang kompleks, Phi-2 cocok atau mengungguli model hingga 25x lebih besar.

Minggu lalu, Google mengumumkan Rangkaian model bahasa Gemini. Gemini Nano adalah model paling efisien dari Google yang dibuat untuk tugas di perangkat dan dapat dijalankan langsung di silikon seluler. Model bahasa kecil seperti Gemini Nano memungkinkan fitur seperti peringkasan teks, balasan cerdas kontekstual, dan koreksi tata bahasa dan pengoreksian tingkat lanjut.

Menurut Microsoft, model Phi-2 baru cocok atau mengungguli Google Gemini Nano-2 baru, meskipun ukurannya lebih kecil. Anda dapat menemukan perbandingan benchmark antara model Google Gemini Nano-2 dan Phi-2 di bawah.

| Model | Ukuran | BBH | BoolQ | MBPP | MMLU |

|---|---|---|---|---|---|

| Gemini Nano 2 | 3.2B | 42.4 | 79.3 | 27.2 | 55.8 |

| Fi-2 | 2.7B | 59.3 | 83.3 | 59.1 | 56.7 |

Selain mengungguli Gemini Nano-2, Phi-2 juga mengungguli performa model Mistral dan Llama-2 pada parameter 7B dan 13B di berbagai benchmark. Temukan detailnya di bawah ini.

| Model | Ukuran | BBH | Kewajaran Pemikiran | Bahasa Memahami | Matematika | Pengkodean |

|---|---|---|---|---|---|---|

| Lama-2 | 7B | 40.0 | 62.2 | 56.7 | 16.5 | 21.0 |

| 13B | 47.8 | 65.0 | 61.9 | 34.2 | 25.4 | |

| 70B | 66.5 | 69.2 | 67.6 | 64.1 | 38.3 | |

| mistral | 7B | 57.2 | 66.4 | 63.7 | 46.4 | 39.4 |

| Fi-2 | 2.7B | 59.2 | 68.8 | 62.0 | 61.1 | 53.7 |

Meskipun dua model phi sebelumnya tersedia di Hugging Face, Phi-2 telah tersedia di katalog model Azure. Anda dapat mempelajari lebih lanjut tentang Phi-2 di sini.