Az NVIDIA és a Google partnere az új Google Gemmának az NVIDIA GPU-kon való optimalizálásában

2 perc olvas

Publikálva

Olvassa el közzétételi oldalunkat, hogy megtudja, hogyan segítheti az MSPowerusert a szerkesztői csapat fenntartásában Tovább

Főbb megjegyzések

- A Microsoft lemond az NVIDIA-ról, és a Google felkarolja őket az új AI-modell optimalizálása érdekében.

- Az NVIDIA TensorRT-LLM felgyorsítja a Google Gemmáját különböző platformokon, beleértve a helyi PC-ket is.

- A fejlesztők hozzáférhetnek a Gemma finomhangolásához és speciális igényekhez történő telepítéséhez szükséges eszközökhöz.

Míg a Microsoft a közelmúltban bejelentette döntését, hogy eltér az NVIDIA GPU-któl az egyedi chipek javára, a Google ezzel ellentétes megközelítést alkalmaz, és együttműködik az NVIDIA-val, hogy optimalizálja új, könnyű nyelvi modelljét, a Gemmát az NVIDIA GPU-kon.

Levélrügy egy olyan könnyű nyelvi modell amelyet a Google fejlesztett ki. A hagyományos nagy nyelvi modellekkel (LLM) ellentétben, amelyek hatalmas számítási erőforrásokat igényelnek, a Gemma kisebb mérettel (2 milliárd és 7 milliárd paraméteres verzió) büszkélkedhet, miközben lenyűgöző képességeket kínál.

Az együttműködés célja a Gemma elérhetőségének és teljesítményének jelentős javítása, gyorsabbá és szélesebb körben elérhetővé téve a különböző platformokon.

Ez a nyílt forráskódú könyvtár optimalizálja az LLM-következtetést, és gyorsabb teljesítményt tesz lehetővé az NVIDIA GPU-kon adatközpontokban, felhőkörnyezetekben és még az NVIDIA RTX GPU-val felszerelt személyi számítógépeken is. Az együttműködés több mint 100 millió NVIDIA RTX GPU-t céloz meg világszerte, valamint a H100-as és a közelgő H200-as GPU-kat tartalmazó felhőplatformokat.

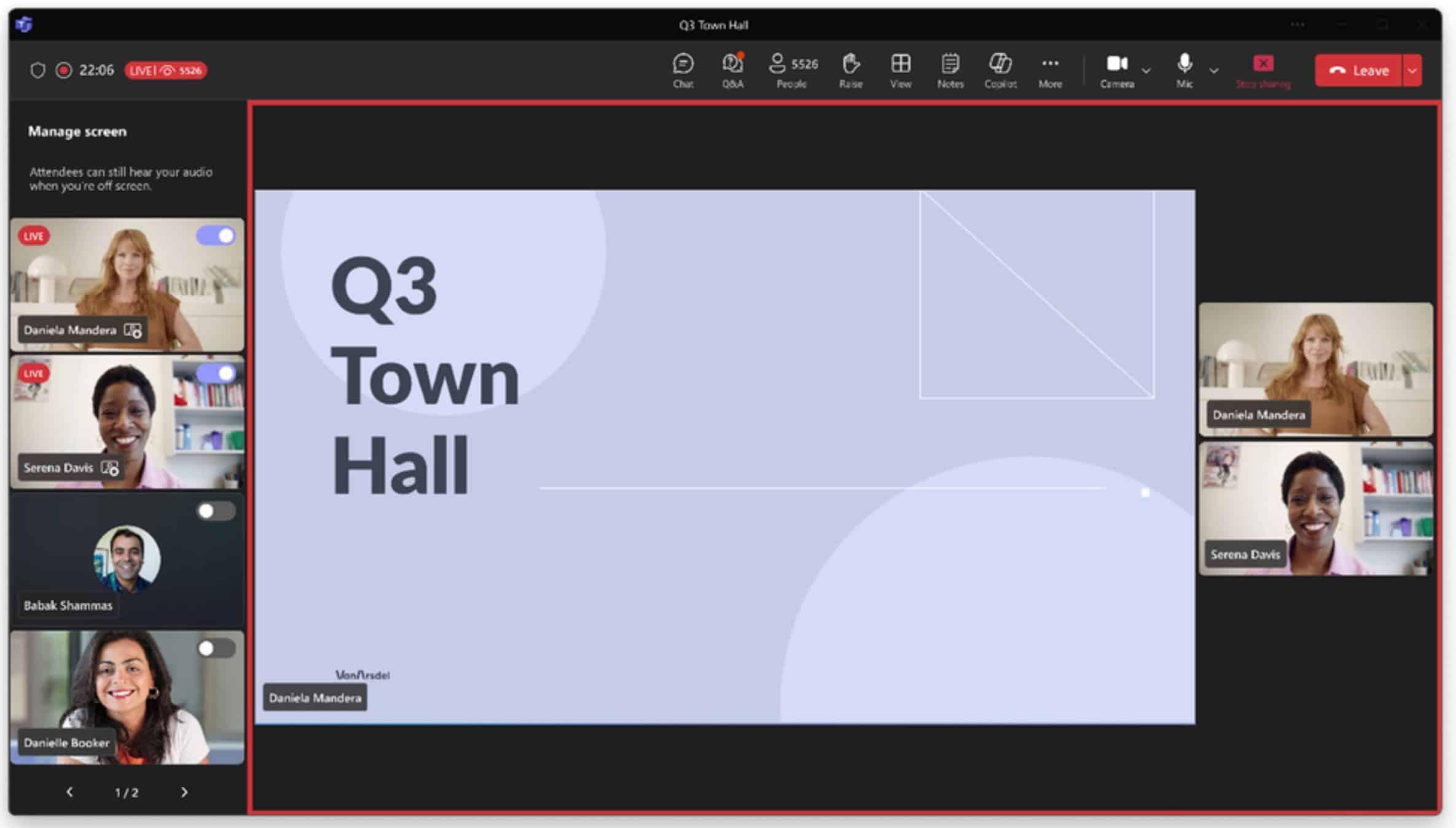

Az NVIDIA AI Enterprise csomagja, beleértve a NeMo keretrendszert és a TensorRT-LLM-et, lehetővé teszi a fejlesztők számára a Gemma finomhangolását és üzembe helyezését bizonyos használati esetekre.

A felhasználók közvetlenül kapcsolatba léphetnek a Gemmával az NVIDIA AI Playground és hamarosan a Chat with RTX demó segítségével, lehetővé téve számukra, hogy adataikkal személyre szabják a chatbotokat.

A A Microsoft elhatárolódik az NVIDIA-tól, a Google lépése, hogy optimalizálja technológiáját az NVIDIA GPU-kon, azt sugallja, hogy potenciálisan megerősítik a partnerséget. Ez további AI és nyelvi modellezési fejlesztésekhez vezethet, amelyek a fejlesztők és a felhasználók számára egyaránt előnyösek.

Ezenkívül az RTX GPU-kon keresztüli helyi feldolgozásra való összpontosítás lehetővé teszi a felhasználók számára, hogy jobban kontrollálják adataikat és magánéletüket, ami potenciálisan kezeli a felhőalapú LLM-szolgáltatásokkal kapcsolatos problémákat.

Több itt.