Qu'est-ce que GPT-3 et comment cela affectera-t-il votre travail actuel

3 minute. lis

Mis à jour le

Lisez notre page de divulgation pour savoir comment vous pouvez aider MSPoweruser à soutenir l'équipe éditoriale Plus d'informations

GPT est l'abréviation de Generative Pre-training Transformer (GPT), un modèle de langage écrit par Alec Radford et publié en 2018 par OpenAI, le laboratoire de recherche en intelligence artificielle d'Elon Musks. Il utilise un modèle génératif de langage (où deux réseaux de neurones se perfectionnent par compétition) et est capable d'acquérir une connaissance du monde et de traiter les dépendances à long terme en pré-formant sur divers ensembles de documents écrits avec de longues portions de texte contigus.

GPT-2 (Generative Pretrained Transformer 2) a été annoncé en février 2019 et est un modèle de langage de transformateur non supervisé formé sur 8 millions de documents pour un total de 40 Go de texte à partir d'articles partagés via des soumissions Reddit. Elon Musk était notoirement réticent à le publier car il craignait qu'il ne soit utilisé pour spammer les réseaux sociaux avec de fausses nouvelles.

En mai 2020, OpenAI a annoncé GPT-3 (Generative Pretrained Transformer 3), un modèle qui contient deux ordres de grandeur de paramètres en plus que GPT-2 (175 milliards contre 1.5 milliard de paramètres) et qui offre une amélioration spectaculaire par rapport à GPT-2.

Étant donné n'importe quelle invite de texte, le GPT-3 renverra une complétion de texte, essayant de faire correspondre le modèle que vous lui avez donné. Vous pouvez le "programmer" en lui montrant quelques exemples de ce que vous aimeriez qu'il fasse, et il fournira un article ou une histoire complète, comme le texte ci-dessous, entièrement écrit par GPT-3.

GPT-3 atteint de solides performances sur de nombreux ensembles de données NLP, y compris les tâches de traduction, de réponse aux questions et de cloze, ainsi que plusieurs tâches qui nécessitent un raisonnement à la volée ou une adaptation de domaine, telles que le décryptage des mots, l'utilisation d'un nouveau mot dans un phrase ou effectuer une arithmétique à 3 chiffres. GPT-3 peut générer des échantillons d'articles de presse que les évaluateurs humains ont du mal à distinguer des articles écrits par des humains.

La dernière application a toujours inquiété OpenAI. GPT-3 est actuellement disponible en version bêta ouverte, avec une version bêta privée payante qui devrait être disponible à terme. OpenAI a déclaré qu'il mettrait fin à l'accès à l'API pour des cas d'utilisation manifestement nuisibles, tels que le harcèlement, le spam, la radicalisation ou l'astroturfing.

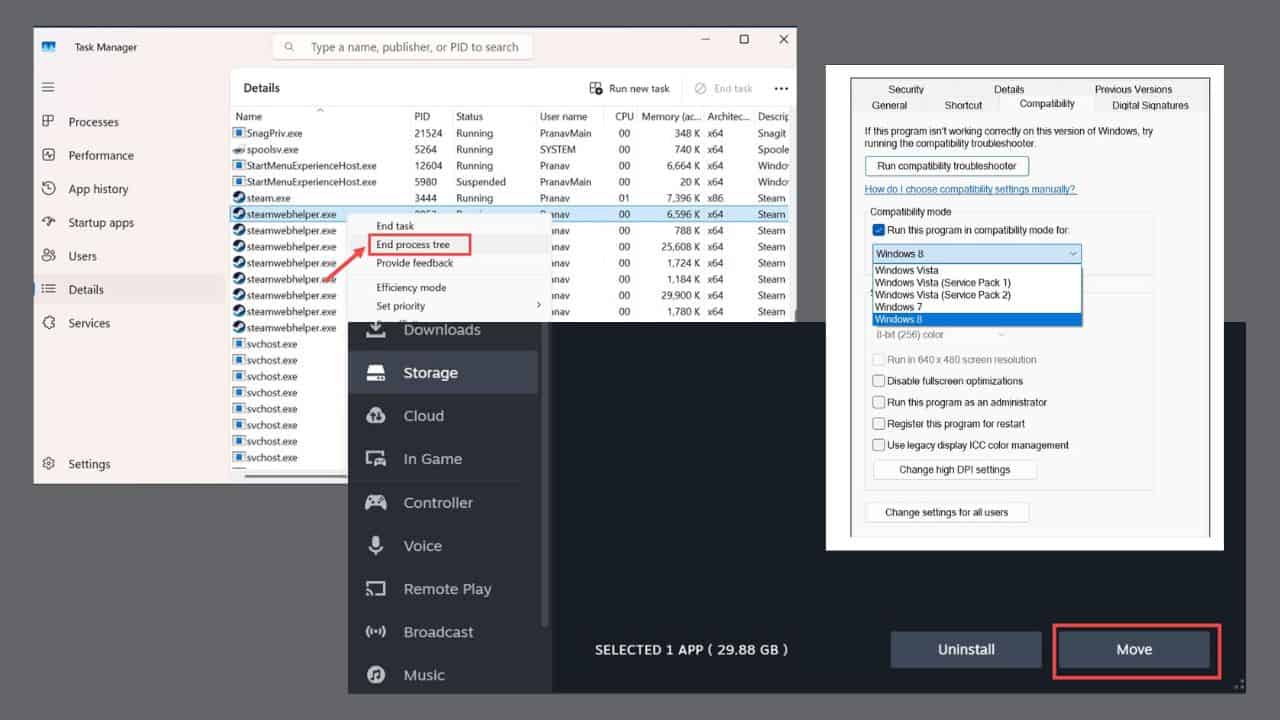

Alors que la population la plus évidemment menacée est celle qui produit des travaux écrits, comme les scénaristes, les développeurs d'IA ont déjà trouvé des applications surprenantes, comme l'utilisation de GPT-3 pour écrire du code.

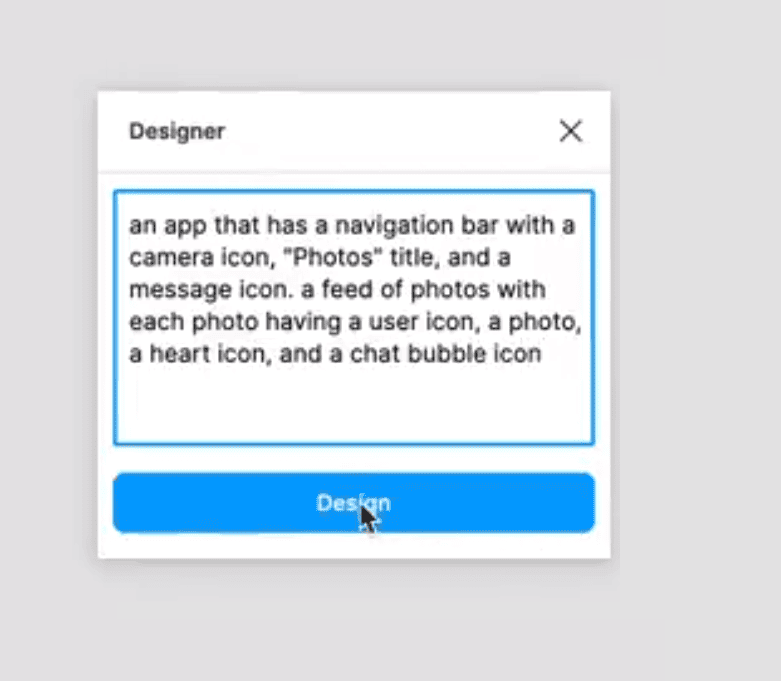

Sharif Shameem, par exemple, a écrit un générateur de mise en page où vous décrivez en texte brut ce que vous voulez, et le modèle génère le code approprié.

C'est époustouflant.

Avec GPT-3, j'ai construit un générateur de mise en page dans lequel vous décrivez simplement la mise en page que vous voulez, et il génère le code JSX pour vous.

QUELLE pic.twitter.com/w8JkrZO4lk

- Sharif Shameem (@sharifshameem) 13 juillet 2020

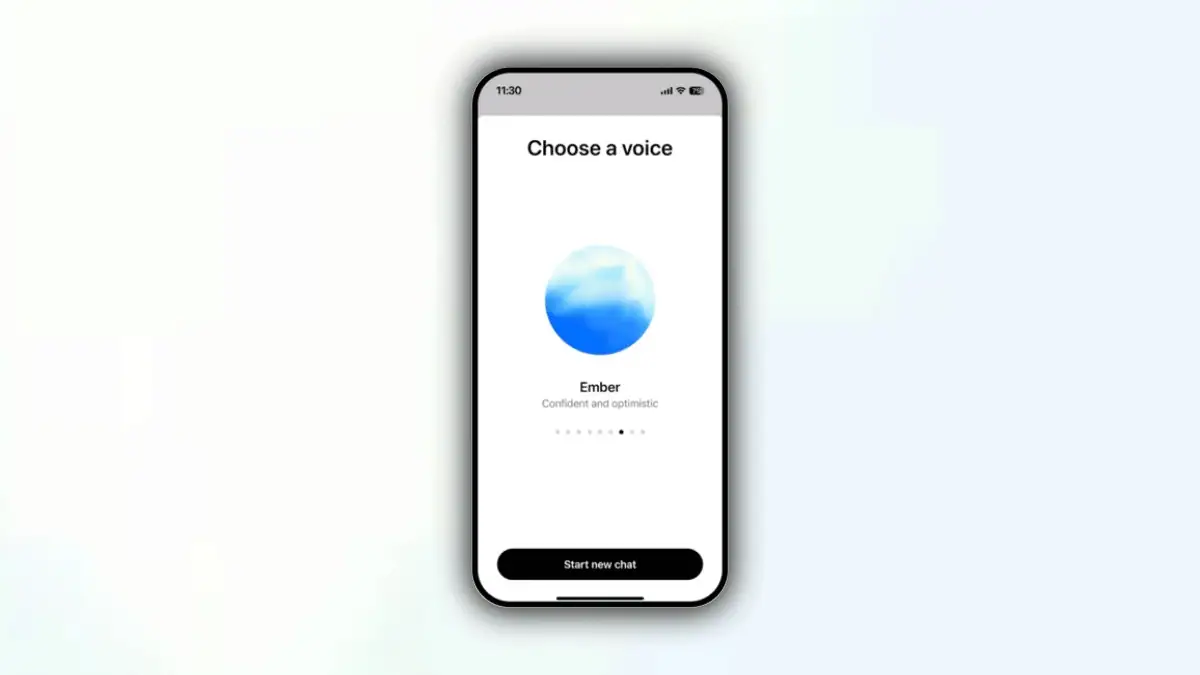

Jordan Singer a également créé un plugin Figma qui permet de créer des applications en utilisant des descriptions en texte brut.

Cela change tout. ?

Avec GPT-3, j'ai construit un plugin Figma pour concevoir pour vous.

Je l'appelle "Designer" pic.twitter.com/OzW1sKNLEC

– chanteuse jordanienne (@jsngr) 18 juillet 2020

Il peut même être utilisé pour diagnostiquer l'asthme et prescrire des médicaments.

So @OpenAI m'ont donné un accès anticipé à un outil qui permet aux développeurs d'utiliser ce qui est essentiellement le générateur de texte le plus puissant de tous les temps. Je pensais le tester en posant une question médicale. Le texte en gras est le texte généré par l'IA. Incroyable… (1/2) pic.twitter.com/4bGfpI09CL

– Qasim Munye (@qasimmunye) 2 juillet 2020

D'autres applications sont comme un moteur de recherche ou une sorte d'oracle, et peuvent même être utilisées pour expliquer et développer des concepts difficiles.

J'ai créé un moteur de recherche entièrement fonctionnel au-dessus de GPT3.

Pour toute requête arbitraire, il renvoie la réponse exacte ET l'URL correspondante.

Regardez toute la vidéo. C'est BIEN SOUFFLANT.

cc: @gdb @npew @gwern pic.twitter.com/9ismj62w6l

–Paras Chopra (@paraschopra) 19 juillet 2020

Bien qu'il semble que cette approche puisse conduire directement à une IA générale capable de comprendre, de raisonner et de converser comme un humain, OpenAI avertit qu'ils ont peut-être rencontré des problèmes fondamentaux de mise à l'échelle, GPT-3 nécessitant plusieurs milliers de pétaflop/s-jours de calcul. , contre des dizaines de pétaflop/s-jours pour le GPT-2 complet. Il semble que même si nous sommes plus proches, la percée qui rendra tous nos emplois obsolètes est encore loin.

En savoir plus sur GPT-3 sur GitHub ici.

Forum des utilisateurs

Messages 0