Microsoft explique pourquoi les LLM hallucinent et inventent des réponses

2 minute. lis

Mis à jour le

Lisez notre page de divulgation pour savoir comment vous pouvez aider MSPoweruser à soutenir l'équipe éditoriale En savoir plus.

Un récent échange sur Twitter entre un utilisateur et un dirigeant de Microsoft a attiré une attention renouvelée sur les limites des grands modèles de langage (LLM) comme Bing et le potentiel de lacunes d'information lorsqu'on s'appuie uniquement sur leurs connaissances internes.

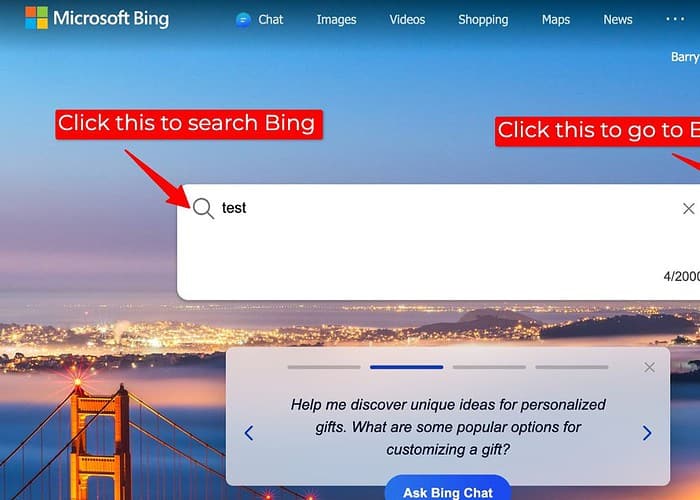

La discussion découle d'un utilisateur signalant des résultats de recherche inexacts sur Bing lorsque son plugin de recherche, qui accède aux données Web externes, a été désactivé. En réponse, Mikhail Parakhin, PDG de Advertising & Web Services chez Microsoft, a reconnu la possibilité pour les LLM « d'inventer des choses » dans de telles situations.

Il a expliqué que lorsqu'ils sont privés des vastes informations disponibles sur le Web, les LLM peuvent parfois recourir à leur base de connaissances interne, un ensemble de textes et de codes utilisés pour la formation, pour générer des réponses. Cependant, cette génération interne peut ne pas toujours être exacte ou alignée sur la réalité factuelle, ce qui entraîne des écarts potentiels dans les résultats de recherche par rapport à ceux obtenus avec le plugin de recherche activé.

Pour moi, cela soulève des questions importantes sur la transparence et l'exactitude des recherches basées sur LLM, en particulier lorsque les sources de données externes ne sont pas disponibles. Lorsque les LLM génèrent des réponses sans accéder à des données externes, les utilisateurs doivent recevoir une indication claire de la source de l’information et de toute limitation potentielle.

Bien que fournir des réponses soit précieux, les LLM doivent donner la priorité aux informations fiables plutôt que de combler les lacunes dans les connaissances avec des générations internes potentiellement inexactes. Explorer des approches alternatives, comme indiquer une incertitude, suggérer des recherches plus approfondies ou simplement déclarer qu'une réponse n'est pas disponible, pourrait renforcer la confiance et empêcher la propagation de fausses informations.

Il n’est donc pas étonnant que les gens préfèrent ChatGPT à Bing Chat/Copilot.

Et pour ces raisons, je préfère personnellement utiliser Bard car Google a fourni une fonctionnalité grâce à laquelle Bard permet aux utilisateurs de savoir si les informations sont référencées ailleurs ou non, ce qui permet aux utilisateurs de faire plus facilement confiance aux informations.

Forum des utilisateurs

Messages 0