Microsoft DeBERTa surpasse les humains chétifs dans le test de compréhension de lecture SuperGlue

2 minute. lis

Publié le

Lisez notre page de divulgation pour savoir comment vous pouvez aider MSPoweruser à soutenir l'équipe éditoriale En savoir plus

Il y a eu récemment des progrès massifs dans la formation de réseaux avec des millions de paramètres. Microsoft a récemment mis à jour le modèle DeBERTa (Decoding-enhanced BERT with untangled attention) en formant une version plus grande composée de 48 couches Transformer avec 1.5 milliard de paramètres. L'augmentation significative des performances permet au modèle DeBERTa unique de surpasser pour la première fois les performances humaines sur le traitement et la compréhension du langage SuperGLUE en termes de score macro-moyen (89.9 contre 89.8), surpassant la ligne de base humaine par une marge décente (90.3 contre 89.8) . Le benchmark SuperGLUE consiste en un large éventail de tâches de compréhension du langage naturel, y compris la réponse aux questions, l'inférence en langage naturel. Le modèle se situe également au sommet du classement de référence GLUE avec un score macro-moyen de 90.8.

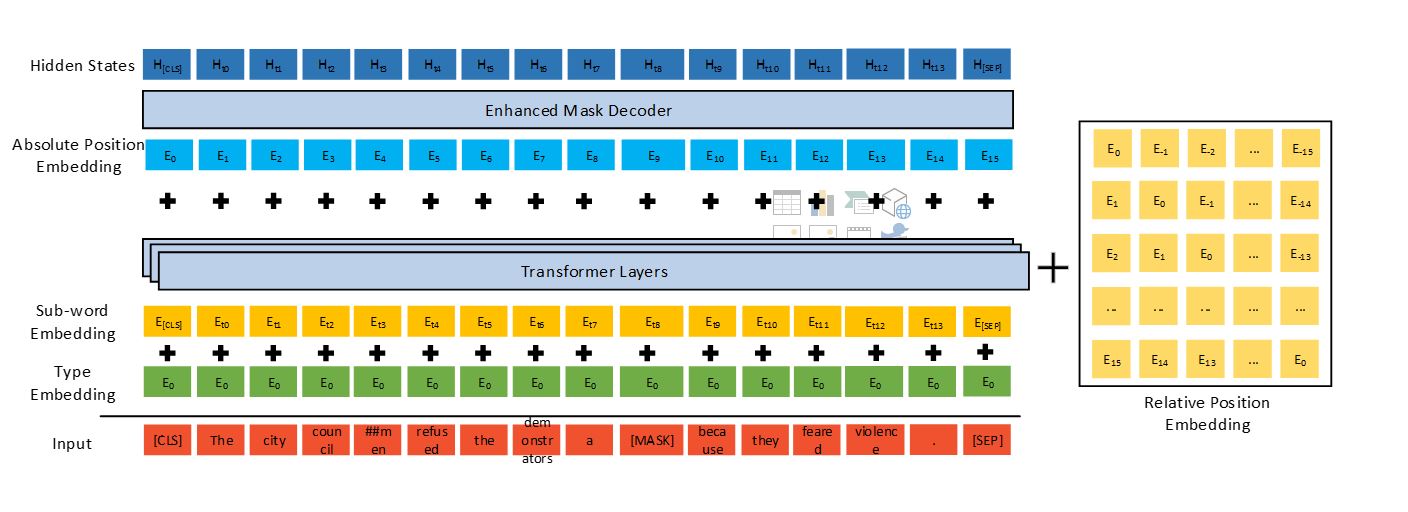

DeBERTa améliore les PLM de pointe précédents (par exemple, BERT, RoBERTa, UniLM) en utilisant trois nouvelles techniques : un mécanisme d'attention désenchevêtré, un décodeur de masque amélioré et une méthode de formation contradictoire virtuelle pour un réglage fin.

Comparé au modèle T5 de Google, qui se compose de 11 milliards de paramètres, le DeBERTa à 1.5 milliard de paramètres est beaucoup plus économe en énergie à former et à entretenir, et il est plus facile à compresser et à déployer sur des applications de différents paramètres.

DeBERTa surpassant les performances humaines sur SuperGLUE marque une étape importante vers l'IA générale. Malgré ses résultats prometteurs sur SuperGLUE, le modèle n'atteint en aucun cas l'intelligence humaine de NLU. Les humains sont extrêmement doués pour tirer parti des connaissances acquises lors de différentes tâches pour résoudre une nouvelle tâche sans ou avec peu de démonstration spécifique à la tâche.

Microsoft intégrera la technologie dans la prochaine version du modèle de représentation du langage naturel Microsoft Turing, utilisé dans des endroits tels que Bing, Office, Dynamics et Azure Cognitive Services, alimentant un large éventail de scénarios impliquant des interactions homme-machine et homme-homme via langage naturel (tel que chatbot, recommandation, réponse aux questions, recherche, assistance personnelle, automatisation du support client, génération de contenu, etc.). En outre, Microsoft publiera le modèle DeBERTa à 1.5 milliard de paramètres et le code source au public.

Lisez tous les détails chez Microsoft ici.