La Free Software Foundation cree que GitHub Copilot debería ser ilegal

3 minuto. leer

Actualizado en

Lea nuestra página de divulgación para descubrir cómo puede ayudar a MSPoweruser a sostener el equipo editorial. Leer más

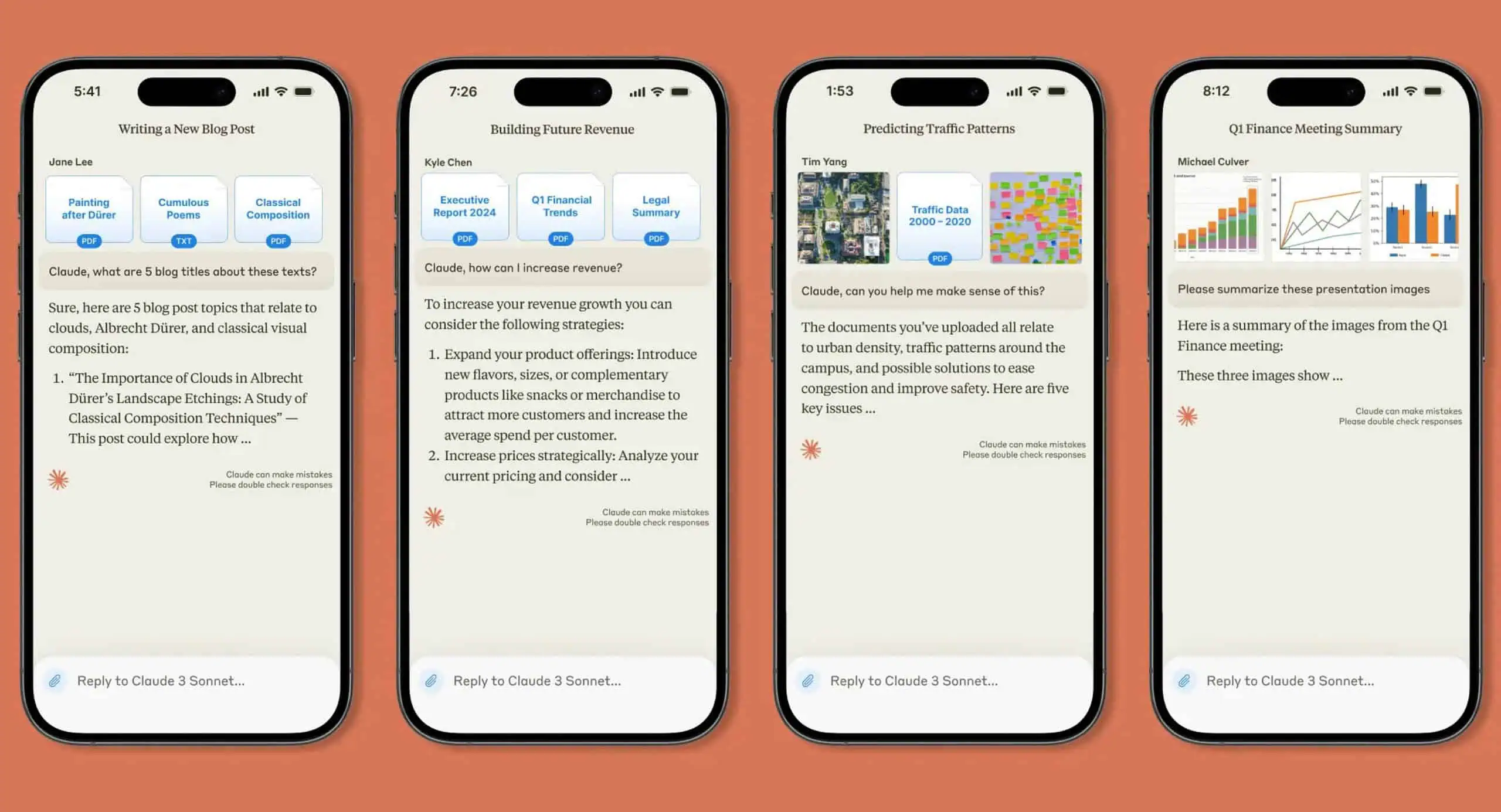

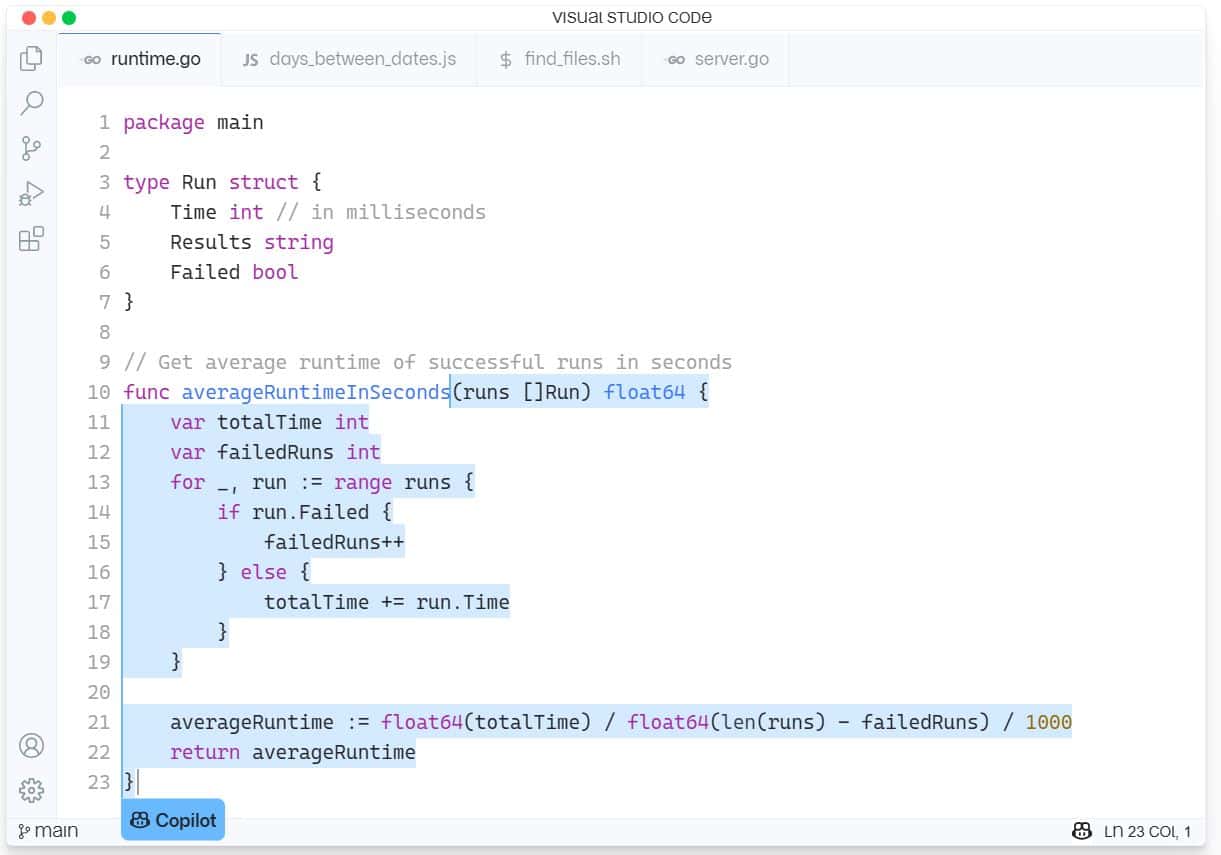

GitHub Copilot es un nuevo servicio de asistencia de IA para el desarrollo de software integrado en Visual Studio Code de Microsoft. GitHub Copilot admite una variedad de lenguajes y marcos y facilita la vida de los desarrolladores al ofrecer sugerencias para líneas completas o funciones completas dentro del IDE. GitHub Copilot funciona con OpenAI Codex y se capacitó en miles de millones de líneas de código de fuente abierta.

El último problema ha causado que la Free Software Foundation (FSF) tenga una enorme abeja en su capó, llamando a la herramienta "inaceptable e injusta, desde nuestra perspectiva".

El defensor del software de código abierto se queja de que Copilot requiere un software de código cerrado como Visual Studio IDE de Microsoft o el editor de Visual Studio Code para ejecutarse y que constituye un "servicio como sustituto del software", lo que significa que es una forma de ganar poder sobre la informática de otras personas.

La FSF sintió que había numerosos problemas con Copilot que aún debían ser probados en los tribunales.

“Los desarrolladores quieren saber si entrenar una red neuronal en su software puede considerarse un uso justo. Otros que podrían querer usar Copilot se preguntan si los fragmentos de código y otros elementos copiados de los repositorios alojados en GitHub podrían resultar en una infracción de derechos de autor. E incluso si todo pudiera ser legalmente aceptable, los activistas se preguntan si no hay algo fundamentalmente injusto en que una empresa de software propietario construya un servicio a partir de su trabajo”, escribió la FSF.

Para ayudar a responder estas preguntas, la FSF ha pedido libros blancos que examinen los siguientes temas:

- ¿La capacitación de Copilot sobre los repositorios públicos infringe los derechos de autor? ¿Uso justo?

- ¿Cuál es la probabilidad de que la salida de Copilot genere reclamos procesables de violaciones de obras con licencia GPL?

- ¿Pueden los desarrolladores que usan Copilot cumplir con las licencias de software libre como la GPL?

- ¿Cómo pueden los desarrolladores asegurarse de que el código del que tienen los derechos de autor esté protegido contra violaciones generadas por Copilot?

- Si Copilot genera un código que da lugar a una violación de un trabajo con licencia de software libre, ¿cómo puede el titular de los derechos de autor descubrir esta violación?

- ¿Tiene derechos de autor un modelo de IA/ML entrenado? ¿Quién tiene los derechos de autor?

- ¿Deberían las organizaciones como la FSF abogar por un cambio en la ley de derechos de autor relevante para estas preguntas?

La FSF pagará $ 500 por los libros blancos publicados y puede liberar más fondos si se justifica una mayor investigación.

Aquellos que quieran hacer una presentación pueden enviarla a [email protected] antes del 21 de agosto. Leer más sobre el proceso en FSF.org aquí.

Microsoft ha respondido al desafío que se avecina diciendo: "Este es un espacio nuevo, y estamos ansiosos por entablar una discusión con los desarrolladores sobre estos temas y liderar la industria en el establecimiento de estándares apropiados para entrenar modelos de IA".

Dado que Copilot a veces roba funciones completas de otras aplicaciones de código abierto, ¿nuestros lectores están de acuerdo con la FSF, o la FSF es hipócrita simplemente porque es una IA en lugar de un código de reutilización humano? Háganos saber su opinión en los comentarios a continuación.

vía infomundo