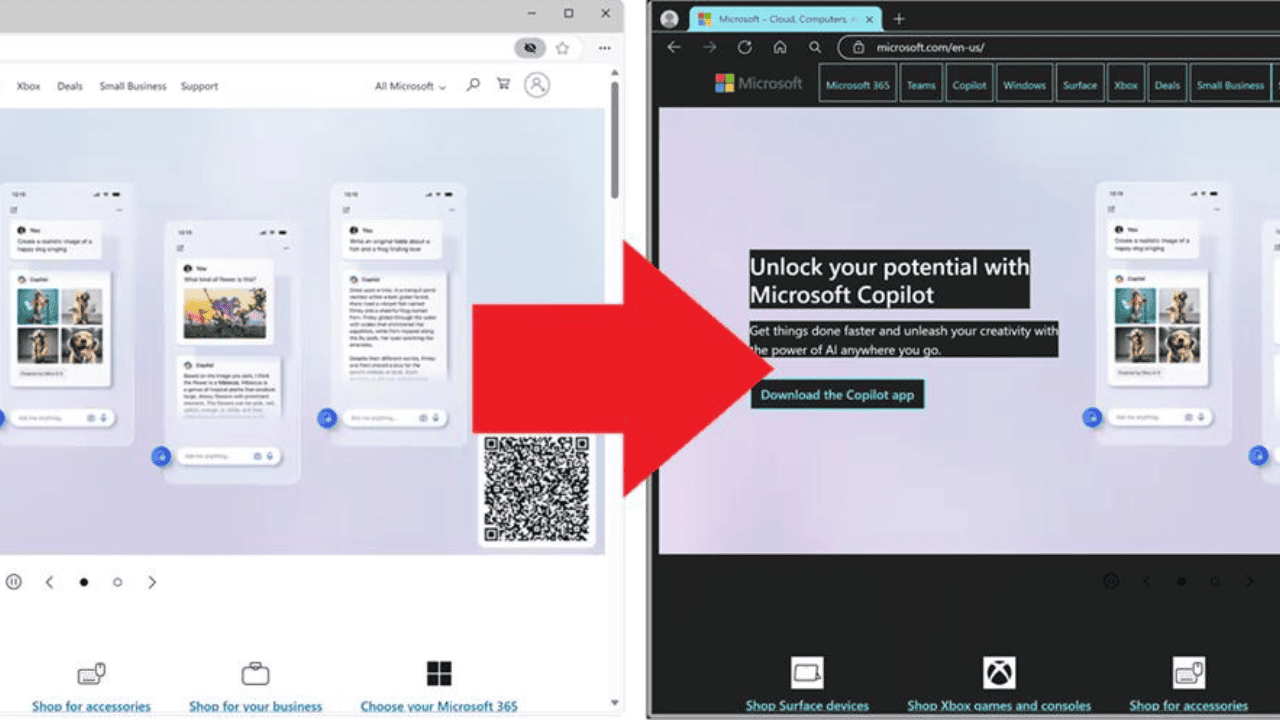

Bing pronto podría tener la capacidad de usar imágenes, videos y otros tipos de datos en las respuestas.

3 minuto. leer

Publicado el

Lea nuestra página de divulgación para descubrir cómo puede ayudar a MSPoweruser a sostener el equipo editorial. Leer más

El nuevo Bing basado en ChatGPT está mejorando continuamente, y Microsoft podría comenzar su mayor desarrollo la próxima semana. Andreas Braun, CTO de Microsoft Alemania, anunció recientemente que GPT-4 llegará la próxima semana. Junto a esto, el ejecutivo insinuó “modelos multimodales que ofrecerán posibilidades completamente diferentes”.

Microsoft ya ha invertido miles de millones de dólares en sus iniciativas de inteligencia artificial, especialmente en la mejora constante de Bing para competir mejor con Google. Ahora, el gigante del software confirmó la próxima semana la llegada de GPT-4, que se espera que se inyecte en su motor de búsqueda y chatbot.

Antes del lanzamiento de ChatGPT Bing, había rumores sobre Bing usando GPT-4. Sin embargo, Microsoft ha utilizado el modelo GPT-3.5 junto con su tecnología patentada. Prometeo, que permite a Bing generar datos actualizados. Sorprendentemente, aunque el nuevo Bing aún no está disponible para todos, la compañía ya tiene planes para darle un impulso significativo al motor de búsqueda a través del próximo GPT-4.

Se espera que el nuevo y próximo modelo de lenguaje grande de OpenAI permita que el chatbot de Bing genere resultados más rápidos, lo que puede ser de gran ayuda ya que la versión actual generalmente tarda unos segundos en comenzar a generar respuestas. No obstante, además de la velocidad, una capacidad multimodal podría ser lo más importante que podría traer la introducción del nuevo LLM.

En el evento AI in Focus – Digital Kickoff de Microsoft, Braun compartió algunos detalles sobre qué esperar de la entrada de un nuevo LLM. (a través de Heise)

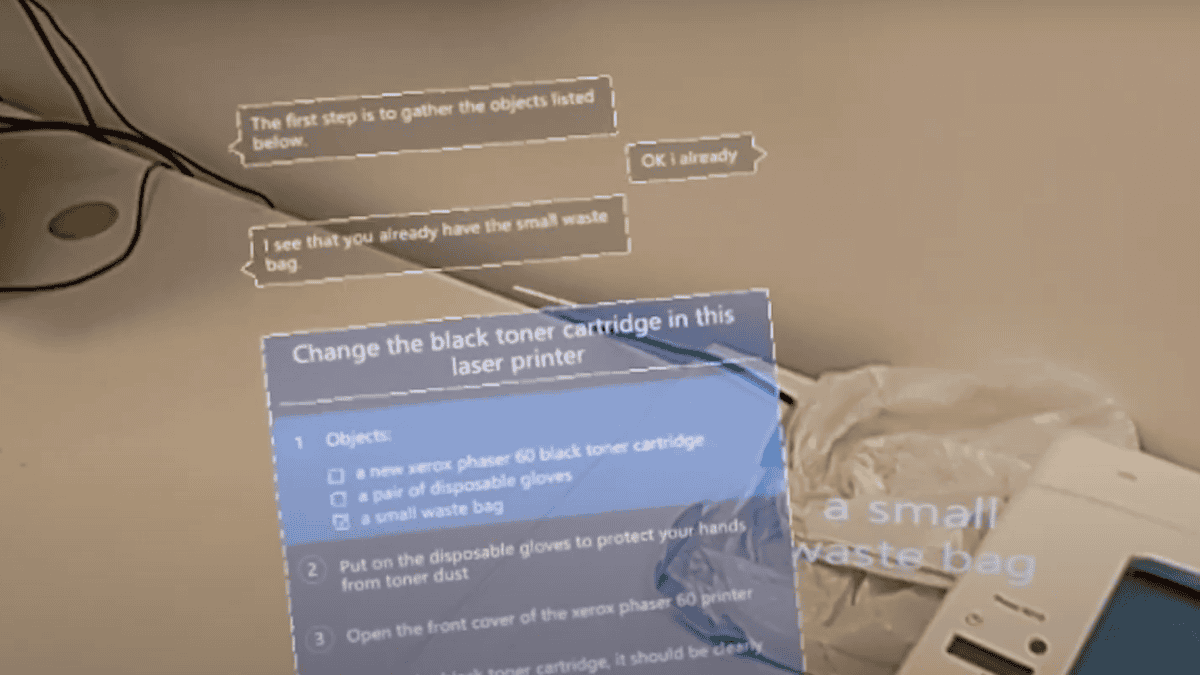

“Presentaremos GPT-4 la próxima semana, allí tendremos modelos multimodales que ofrecerán posibilidades completamente diferentes, por ejemplo, videos”, dijo Braun, quien describió a LLM como un “cambio de juego”.

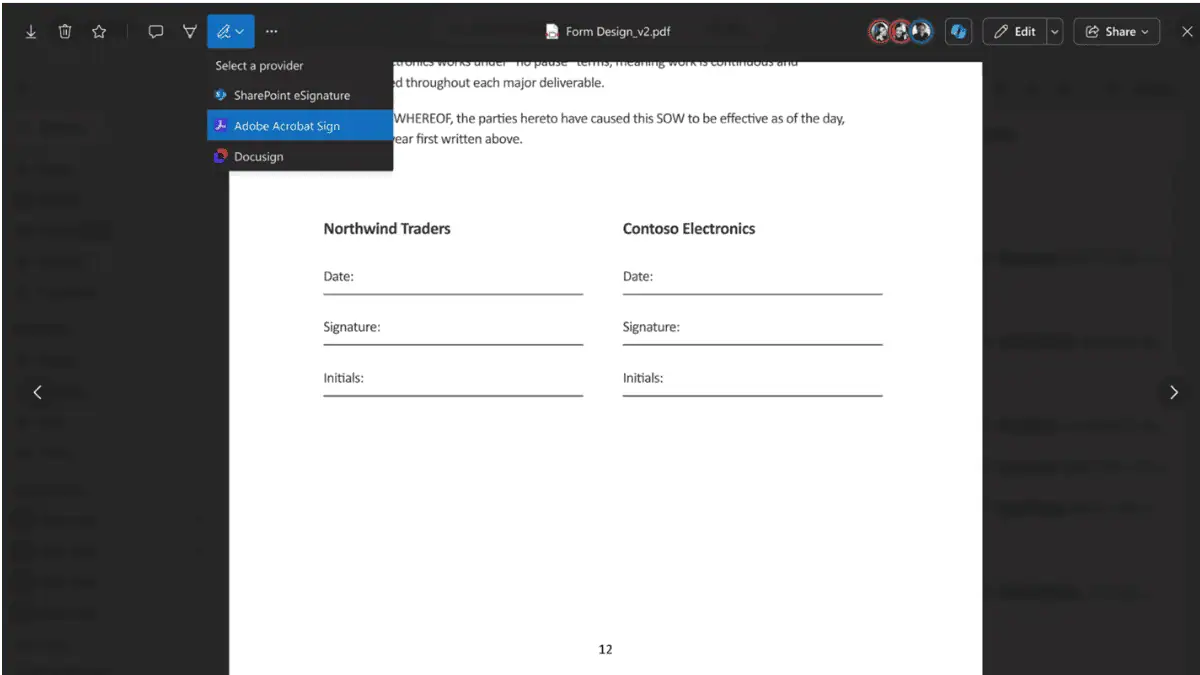

Además, Braun confirmó que Microsoft tiene planes para "hacer que los modelos sean integrales" utilizando la capacidad multimodal. Una vez inyectado, esto debería permitir que Bing proporcione una variedad de datos al responder preguntas, lo que significa que también podría procesar videos, imágenes y otros tipos de datos. Esto debería resultar en mejores respuestas, haciendo de Bing un asistente de búsqueda más efectivo para todos.

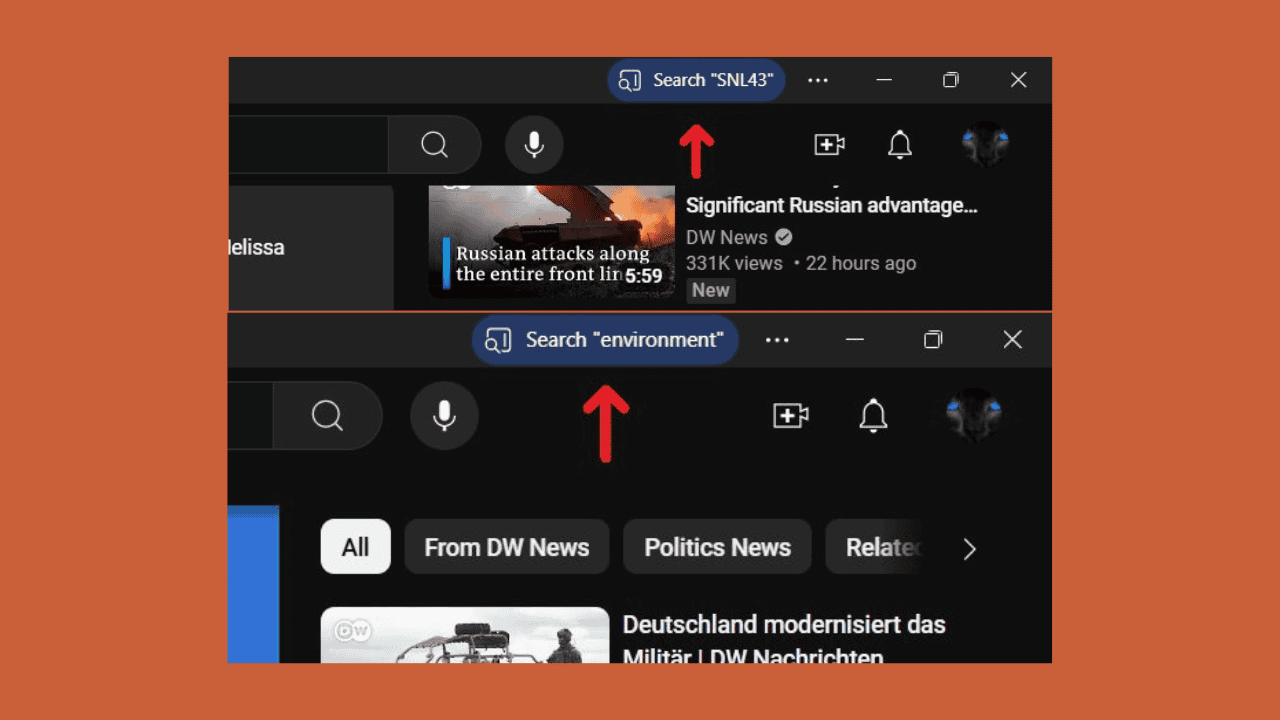

Por otro lado, es importante señalar que Bing no es el primero en multimodalidad. Recientemente, you.com implementó su función de búsqueda de chat multimodal, que permite a los usuarios proporcionar entradas de texto y voz y recibir respuestas más allá de los textos conversacionales. El motor de búsqueda, sin embargo, todavía está luchando por llamar la atención del público. Mientras tanto, a pesar de que aún no es completamente accesible para todos, Bing ya tiene una lista de espera en constante expansión. La inyección de una capacidad multimodal en él sin duda afectará a sus rivales, como You.com. Sin embargo, aún es pronto para decir cuán amplio será este efecto, ya que el anuncio de Braun solo confirma muy pocos detalles.