El modelo ReALM AI de Apple puede "ver" y comprender el contexto de la pantalla; GPT-4 'sustancialmente superado'

2 minuto. leer

Publicado el

Lea nuestra página de divulgación para descubrir cómo puede ayudar a MSPoweruser a sostener el equipo editorial. Leer más

Notas clave

- ReALM de Apple comprende lo que hay en su pantalla y responde a sus solicitudes en consecuencia.

- ReALM superó a GPT-4 en varias tareas a pesar de tener menos parámetros.

- ReALM se destaca por comprender la intención del usuario para consultas específicas de dominio.

Los investigadores de Apple dieron a conocer un nuevo sistema de inteligencia artificial llamado ReALM que puede comprender lo que hay en su pantalla y responder a sus solicitudes en consecuencia. Este avance llega después de Apple adquirió DarwinAI el mes pasado.

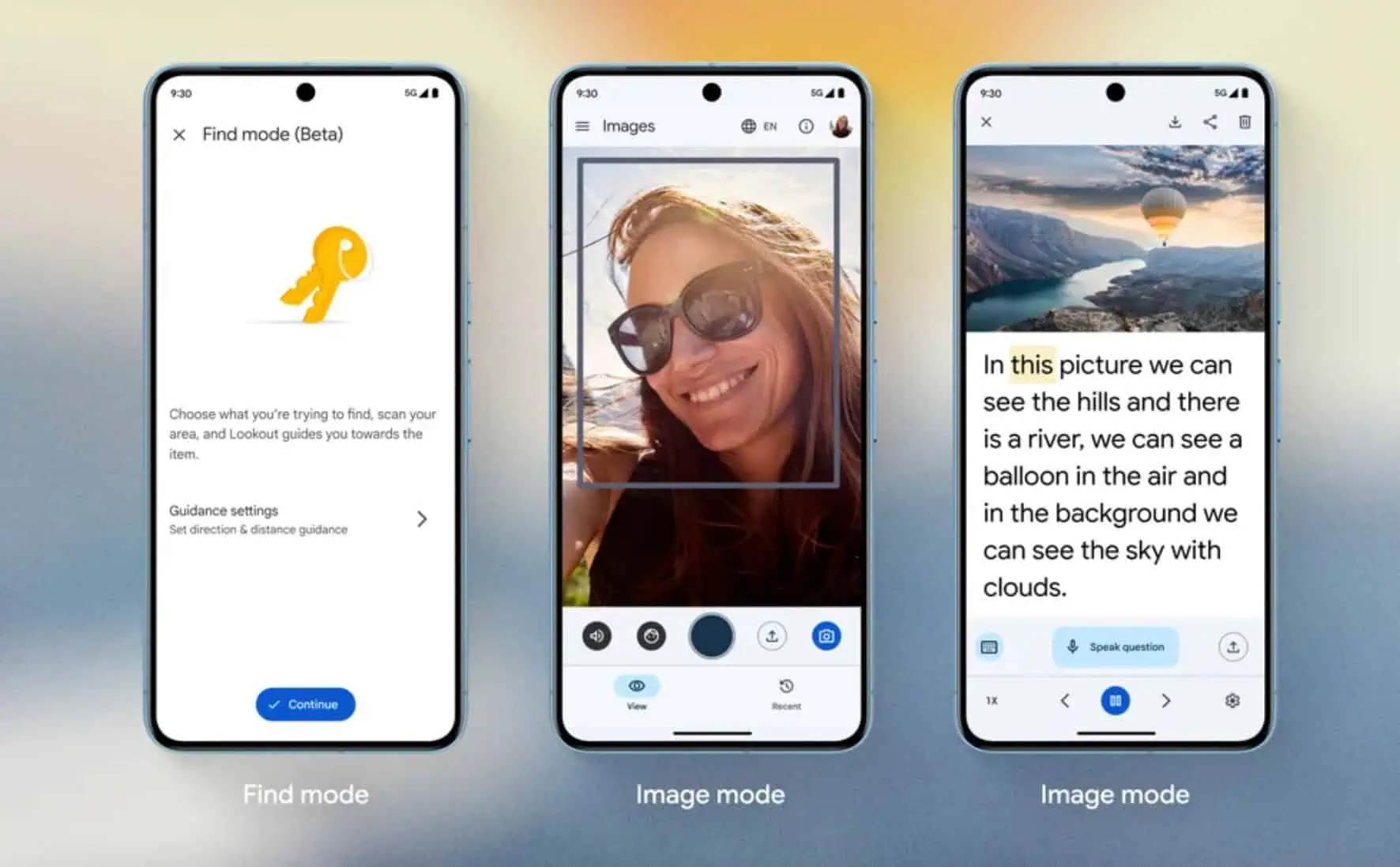

ReALM logra esto convirtiendo la información de su pantalla en texto, lo que le permite funcionar en dispositivos sin requerir un reconocimiento de imágenes voluminoso. Puede considerar lo que hay en la pantalla y las tareas que se ejecutan en segundo plano.

Según un artículo de investigación, los modelos ReALM más grandes de Apple superaron significativamente al GPT-4 a pesar de tener menos parámetros.

Imagínese navegar por una página web y encontrar una empresa a la que le gustaría llamar. Con ReALM, podría decirle a Siri que "llame a esta empresa" y Siri podría "ver" el número de teléfono e iniciar la llamada directamente.

Este es sólo un ejemplo de cómo la comprensión de ReALM de la información en pantalla puede mejorar la experiencia del usuario. Al integrar ReALM en futuras actualizaciones de Siri, Apple podría crear una experiencia de usuario más fluida y con manos libres. Apple también está trabajando en MM1, que puede reducir la necesidad de múltiples indicaciones para obtener el resultado deseado, Y un Manipulador de imágenes AI,

El artículo de investigación también detalla puntos de referencia en los que ReALM superó a los modelos anteriores en varios conjuntos de datos, incluidos conjuntos de datos conversacionales, sintéticos y no vistos. En particular, ReALM se desempeñó de manera competitiva con GPT-4 en tareas que involucran información en pantalla, a pesar de que GPT-4 tuvo acceso a capturas de pantalla, mientras que ReALM se basó únicamente en la codificación de texto. Visto en X.

También explora los beneficios de los diferentes tamaños de modelos de ReALM. Si bien todos los modelos funcionan mejor con más parámetros, la mejora es más significativa para el procesamiento de información en pantalla, lo que sugiere la complejidad de esta tarea.

Al evaluar el rendimiento en dominios completamente nuevos e invisibles, tanto ReALM como GPT-4 mostraron resultados similares. Sin embargo, ReALM superó a GPT-4 en lo que respecta a consultas específicas de dominio debido a que se ajustó a las solicitudes de los usuarios. Esto permite a ReALM captar los matices de la intención del usuario y responder en consecuencia.

En general, la investigación demuestra cómo ReALM utiliza LLM para la resolución de referencia. ReALM puede comprender la pantalla del usuario y sus solicitudes al convertir entidades en pantalla en texto en lenguaje natural, sin dejar de ser eficiente para las aplicaciones en el dispositivo.

Si bien ReALM codifica eficazmente la posición de las entidades en pantalla, los investigadores dicen que es posible que no capture todos los detalles para consultas complejas de los usuarios que requieren una comprensión compleja de las relaciones espaciales.