Η Microsoft παρουσιάζει την οικογένεια μοντέλων Phi-3 που ξεπερνούν σε απόδοση άλλα μοντέλα της κατηγορίας της

2 λεπτό. ανάγνωση

Δημοσιεύθηκε στις

Διαβάστε τη σελίδα αποκάλυψης για να μάθετε πώς μπορείτε να βοηθήσετε το MSPoweruser να διατηρήσει τη συντακτική ομάδα Διάβασε περισσότερα

Τον Δεκέμβριο του 2023, η Microsoft κυκλοφόρησε Phi-2 μοντέλο με 2.7 δισεκατομμύρια παραμέτρους που παρείχε κορυφαία απόδοση μεταξύ μοντέλων βασικής γλώσσας με λιγότερες από 13 δισεκατομμύρια παραμέτρους. Τους τελευταίους τέσσερις μήνες, αρκετά άλλα μοντέλα που κυκλοφόρησαν ξεπέρασαν τις επιδόσεις του Phi-2. Πρόσφατα, η Meta κυκλοφόρησε την οικογένεια μοντέλων Llama-3 που ξεπέρασε σε απόδοση όλα τα προηγούμενα μοντέλα ανοιχτού κώδικα.

Χθες το βράδυ, η Microsoft Research ανακοίνωσε την οικογένεια μοντέλων Phi-3 μέσω τεχνική έκθεση. Υπάρχουν τρία μοντέλα στην οικογένεια Phi-3:

- phi-3-mini (3.8B)

- phi-3-small (7B)

- phi-3-medium (14B)

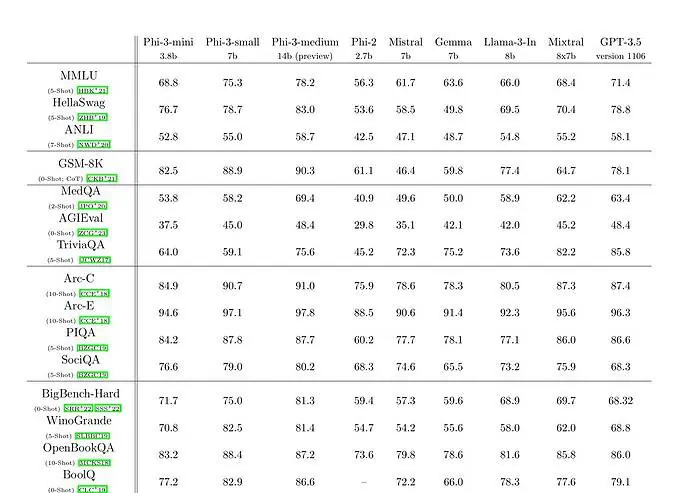

Το phi-3-mini με μοντέλο γλώσσας 3.8 δισεκατομμυρίων παραμέτρων εκπαιδεύεται σε 3.3 τρισεκατομμύρια μάρκες. Σύμφωνα με τα benchmarks, το phi-3-mini ξεπερνά το Mixtral 8x7B και το GPT-3.5. Η Microsoft ισχυρίζεται ότι αυτό το μοντέλο είναι αρκετά μικρό για να αναπτυχθεί σε τηλέφωνο. Η Microsoft χρησιμοποίησε μια κλιμακούμενη έκδοση του συνόλου δεδομένων που χρησιμοποιήθηκε για το phi-2, που αποτελείται από έντονα φιλτραρισμένα δεδομένα ιστού και συνθετικά δεδομένα. Σύμφωνα με τα αποτελέσματα αναφοράς της Microsoft στο Technical Paper, το phi-3-small και το phi-3-medium επιτυγχάνουν εντυπωσιακή βαθμολογία MMLU 75.3 και 78.2 αντίστοιχα.

Όσον αφορά τις δυνατότητες LLM, ενώ το μοντέλο Phi-3-mini επιτυγχάνει παρόμοιο επίπεδο γλωσσικής κατανόησης και ικανότητας συλλογισμού με αυτά των πολύ μεγαλύτερων μοντέλων, εξακολουθεί να περιορίζεται θεμελιωδώς από το μέγεθός του για ορισμένες εργασίες. Το μοντέλο απλώς δεν έχει την ικανότητα να αποθηκεύσει εκτεταμένες πραγματικές γνώσεις, κάτι που μπορεί να φανεί, για παράδειγμα, με χαμηλή απόδοση στο TriviaQA. Ωστόσο, πιστεύουμε ότι αυτή η αδυναμία μπορεί να επιλυθεί με την αύξηση με μια μηχανή αναζήτησης.