Die Snapdragon Neural Processing Engine von Qualcomm wird bessere AR-Erlebnisse ermöglichen

3 Minute. lesen

Veröffentlicht am

Lesen Sie unsere Offenlegungsseite, um herauszufinden, wie Sie MSPoweruser dabei helfen können, das Redaktionsteam zu unterstützen Lesen Sie weiter

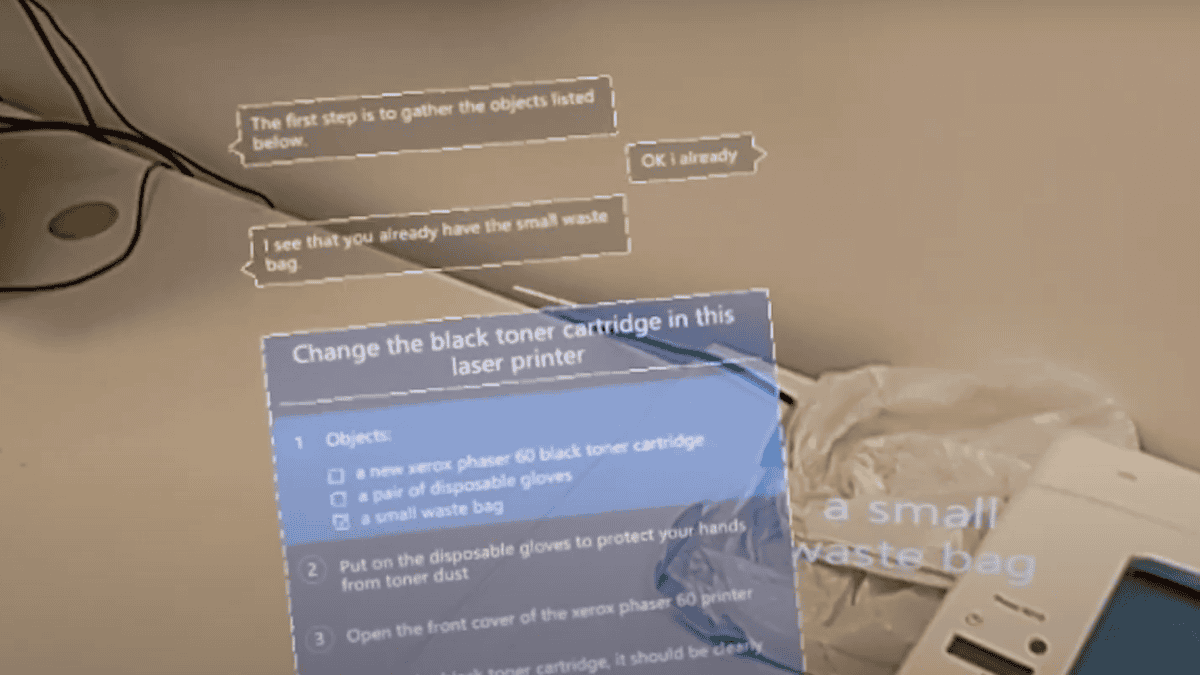

Apple ARKit wird die größte AR-Plattform der Welt sein, wenn es später in diesem Jahr auf den Markt kommt. Hunderte Millionen von iPhone- und iPad-Geräten werden dank der leistungsstarken CPU und GPU, die bereits auf diesen Geräten verfügbar sind, mit ARKit kompatibel sein. Um eine hochpräzise Szenenerkennung und Objektverfolgung zu ermöglichen, müssen Sie neuronale netzwerkgesteuerte Algorithmen auf dem Gerät ausführen. Diese Algorithmen können nicht wie jeder andere Algorithmus vollständig auf der CPU ausgeführt werden, da sie mehr Strom benötigen und mehr Batterie verbrauchen. Da Apple die Hardware in diesen Geräten genau kennt, haben sie das ARKit so optimiert, dass es auf energieeffizienten Weise gut auf den iOS-Geräten läuft.

Google hingegen kann nicht dasselbe tun, da sein Android-Ökosystem auf einer Vielzahl von CPU- und GPU-Modellen von verschiedenen Anbietern wie Qualcomm, Samsung, MediaTek usw. basiert und ihre Fähigkeiten dramatisch variieren. Qualcomm, der beliebteste Hersteller mobiler Prozessoren, versucht, dieses Problem mit dem Neural Processing Engine (NPE) SDK zu lösen. Das Snapdragon NPE ist ein Deep-Learning-Software-Framework, das für mobile Snapdragon-Plattformen entwickelt wurde. Es hilft Entwicklern, ein oder mehrere neuronale Netzwerkmodelle auszuführen, die in Caffe/Caffe2 oder TensorFlow auf Snapdragon-Mobilplattformen trainiert wurden, unabhängig davon, ob es sich um CPU, GPU oder DSP handelt. Es unterstützt sowohl Convolutional Neural Networks als auch Custom Layers.

- Das Snapdragon NPE wurde entwickelt, um Entwicklern dabei zu helfen, Zeit und Mühe bei der Optimierung der Leistung trainierter neuronaler Netze auf Geräten mit Snapdragon zu sparen.

- Dies geschieht durch die Bereitstellung von Tools für die Modellkonvertierung und -ausführung sowie APIs zur Ausrichtung des Kerns mit dem Leistungs- und Leistungsprofil, das der gewünschten Benutzererfahrung entspricht.

- Entwickler können Deep-Learning-Benutzererfahrungen wie Stilübertragungen und Filter (erweiterte Realität), Szenenerkennung, Gesichtserkennung, natürliches Sprachverständnis, Objektverfolgung und -vermeidung, Gesten und Texterkennung nutzen, um nur einige zu nennen.

Facebook plant beispielsweise, den Snapdragon NPE in die Kamera der Facebook-App zu integrieren, um Caffe2-basierte AR-Funktionen zu beschleunigen. Dadurch können sie auf der Adreno-GPU im Vergleich zu einer generischen CPU-Implementierung eine 5-mal bessere Leistung erzielen, was zu einer flüssigeren, nahtloseren und realistischeren Anwendung von AR-Funktionen bei der Aufnahme von Fotos und Live-Videos führt.

Snapdragon NPE SDK enthält Folgendes:

- Android- und Linux-Laufzeiten für die Ausführung neuronaler Netzwerkmodelle

- Beschleunigungsunterstützung für Qualcomm Hexagon DSPs, Qualcomm Adreno GPUs und Qualcomm Kryo, CPUs

- Unterstützung für Modelle in den Formaten Caffe, Caffe2 und TensorFlow3

- APIs zum Steuern des Ladens, der Ausführung und der Planung auf den Laufzeiten

- Desktop-Tools für die Modellkonvertierung

- Leistungsbenchmark zur Engpassidentifikation

- Beispielcode und Tutorials

- HTML-Dokumentation

Das Snapdragon NPE ist mit den mobilen Plattformen der Snapdragon 600- und 800-Serie kompatibel. Nach meiner Schätzung wird es mindestens 200 Millionen aktive mobile Geräte geben, auf denen Prozessoren der Snapdragon 600- und 800-Serie laufen. Hoffentlich werden Entwickler diese NPE-Plattform nutzen, um großartige AR-Erlebnisse auf mobilen Geräten zu schaffen. Sie können das SDK herunterladen hier.

In diesem Zusammenhang hat Microsoft Anfang dieser Woche angekündigt, dass die nächste Version von HoloLens die zweite Version der HPU enthalten wird, die einen KI-Coprozessor enthalten wird, um Deep Neural Networks nativ und flexibel zu implementieren. Lesen Sie mehr darüber hier.