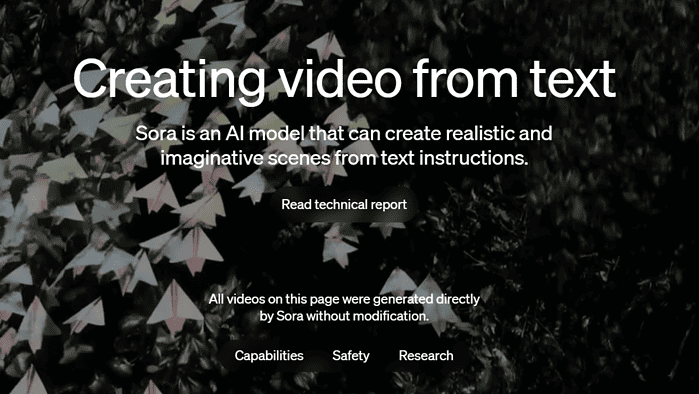

Lernen Sie Sora kennen, das neue Text-zu-Video-Modell von OpenAI, das atemberaubende HD-Videos basierend auf Textaufforderungen erstellt

Es geht nicht um die Frage: „Können wir es schaffen?“, sondern um die Frage: „Sollten wir es tun?“

2 Minute. lesen

Veröffentlicht am

Lesen Sie unsere Offenlegungsseite, um herauszufinden, wie Sie MSPoweruser dabei helfen können, das Redaktionsteam zu unterstützen Lesen Sie weiter

Wichtige Hinweise

- OpenAI hat gerade ein neues Text-zu-Video-KI-Modell namens Sora angekündigt, das beeindruckend und gleichzeitig beängstigend aussieht.

- Die Menschen sind nun besorgt, ob dieses Modell ihre Jobs übernehmen wird.

- Das Modell wird C2PA-Metadaten übertragen, sobald es in Zukunft in einem OpenAI-Produkt implementiert wird.

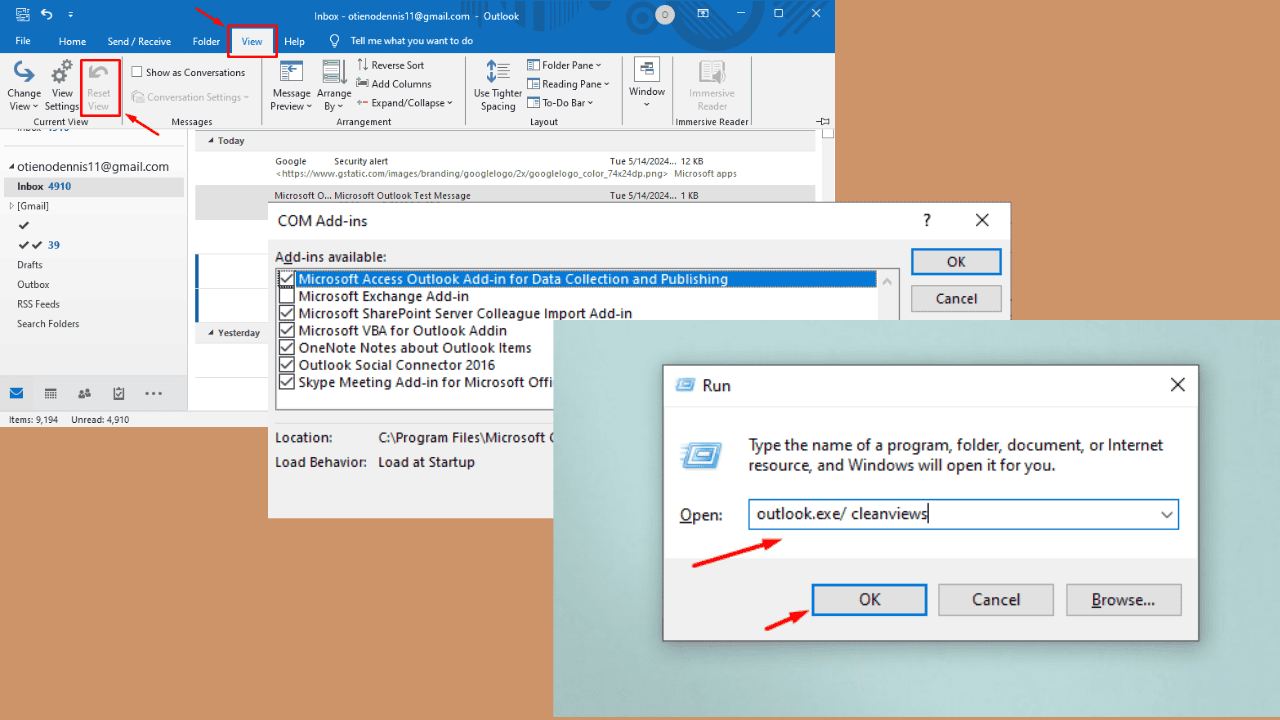

OpenAI hat gerade ein neues Text-zu-Video-KI-Modell angekündigt. Sora, und es sieht beeindruckend aus. Die Prämisse sieht ziemlich einfach und dennoch bemerkenswert aus: Sie können beliebige Wortaufforderungen eintippen, so detailliert Sie möchten, und dann kommt das KI-Modell mit einem 60 Sekunden langen, sehr detaillierten Video zurück.

Schauen Sie sich einige der Ergebnisse an, die Sora erzielen konnte:

Das ist ehrlich gesagt beängstigend und beeindruckend zugleich. Die öffentliche Reaktion darauf ist eine Mischung aus Ehrfurcht und Besorgnis, vor allem wenn man bedenkt Die Vergangenheit von OpenAI ist legal Streitigkeiten mit journalistischen Unternehmen wegen angeblicher Verwendung ihrer Artikel zum Trainieren des Models ohne deren Zustimmung.

Und wir müssen auch über potenzielle Arbeitsplätze reden, die ersetzt werden könnten. Sogar OpenAI-Chef Sam Altman selbst, der einst seines Amtes enthoben wurde, sagte, dass das Tempo unserer KI-Forschung gewesen sei geht viel zu schnell voran und das Ausmaß der Anpassung, die die Menschheit vornehmen muss, ist alarmierend.

Dieses Modell baut auf früheren DALL-E- und GPT-Forschungen auf und nutzt die einzigartige Recaptioning-Methode von DALL-E 3, um äußerst aussagekräftige Beschriftungen für die visuellen Trainingsdaten zu generieren. Jedoch, es steht immer noch vor Herausforderungen darin, komplexe Szenen realistisch zu simulieren, Ursache-Wirkungs-Beziehungen zu verstehen und räumliche Details einer Aufforderung nicht zu verwechseln.

Bei der Implementierung in einem OpenAI-Produkt in der Zukunft, sei es ChatGPT, ein neues Angebot oder Copilot, wird das Modell C2PA-Metadaten übertragen, ähnlich wie es Microsoft bisher getan hat Bildersteller von Designer. Text- und Bildprüfungen schützen OpenAI-Produkte vor schädlichen Inhalten wie Gewalt, Hassreden und Urheberrechtsverletzungen.

„Wir gewähren außerdem Zugang zu einer Reihe von bildenden Künstlern, Designern und Filmemachern, um Feedback zu erhalten, wie wir das Modell so weiterentwickeln können, dass es für Kreativprofis am hilfreichsten ist“, sagt OpenAI.