Das OpenAI o1-Modell unterstützt jetzt ChatGPT und ist auch für kostenlose Benutzer verfügbar

Das Unternehmen plant außerdem, den o1-mini für kostenlose Benutzer anzubieten

2 Minute. lesen

Veröffentlicht am

Lesen Sie unsere Offenlegungsseite, um herauszufinden, wie Sie MSPoweruser dabei helfen können, das Redaktionsteam zu unterstützen Mehr erfahren

Wichtige Hinweise

- OpenAI hat OpenAI o1 eingeführt, ein Argumentationsmodell, das ChatGPT antreibt.

- Das O1 ist genauer, aber langsamer und teurer als Vorgängermodelle.

- Es ist für Plus-, Team- und bald auch für Edu- und Enterprise-Benutzer verfügbar.

OpenAI hat ins Leben gerufen sein allererstes Modell für Denkfähigkeiten, das OpenAI o1, und es wird den beliebten Chatbot ChatGPT antreiben.

Das neueste Modell ist – neben dem kleineren, günstigeren OpenAI o1-mini – das erste einer neuen Reihe von „Argumentation“-Modellen, die für komplexe Aufgaben wie Codierung und mehrstufige Problemlösung entwickelt wurden. Obwohl o1 genauer und leistungsfähiger als frühere Modelle ist, ist es langsamer und teurer in der Anwendung und hat immer noch einige Probleme mit Halluzinationen.

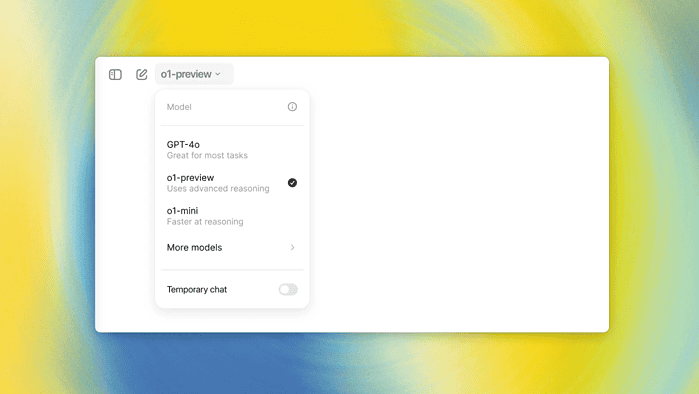

„Sowohl o1-preview als auch o1-mini können manuell im Modellwähler ausgewählt werden, und beim Start werden die wöchentlichen Ratenbegrenzungen 30 Nachrichten für o1-preview und 50 für o1-mini betragen. Wir arbeiten daran, diese Raten zu erhöhen und ChatGPT zu ermöglichen, automatisch das richtige Modell für eine bestimmte Eingabeaufforderung auszuwählen“, sagt das von Microsoft unterstützte Unternehmen.

OpenAI o1 wird ChatGPT antreiben. Bezahlte Plus- und Team-Benutzer können das Modell bereits ausprobieren, Enterprise- und Edu-Benutzer beginnen nächste Woche. Das Unternehmen plant auch, den o1-mini für kostenlose Benutzer bereitzustellen, obwohl das genaue Datum noch nicht bekannt gegeben wurde.

Im Vergleich zum Vorgänger GPT-4o-Modell, o1, das im MMLU-Benchmark 78.2 % erreicht, übertrifft letzteres in 54 von 57 Unterkategorien des Benchmarks, trotz einer Gesamtpunktzahl von 82.0 %.

Es übertrifft GPT-4o auch in Bereichen wie Mathematik bei weitem, wo es 74 % der Probleme bei AIME löste (verglichen mit GPT-4o mit 12 %) und schnitt sogar besser ab als Experten mit Doktortitel bei GPQA Diamond, einem Maßstab in Chemie, Physik und Biologie.

Benutzerforum

0 Nachrichten