NVIDIA und Google arbeiten zusammen, um das neue Google Gemma auf NVIDIA-GPUs zu optimieren

2 Minute. lesen

Veröffentlicht am

Lesen Sie unsere Offenlegungsseite, um herauszufinden, wie Sie MSPoweruser dabei helfen können, das Redaktionsteam zu unterstützen Mehr erfahren

Wichtige Hinweise

- Microsoft verlässt NVIDIA und Google begrüßt sie für die Optimierung seines neuen KI-Modells.

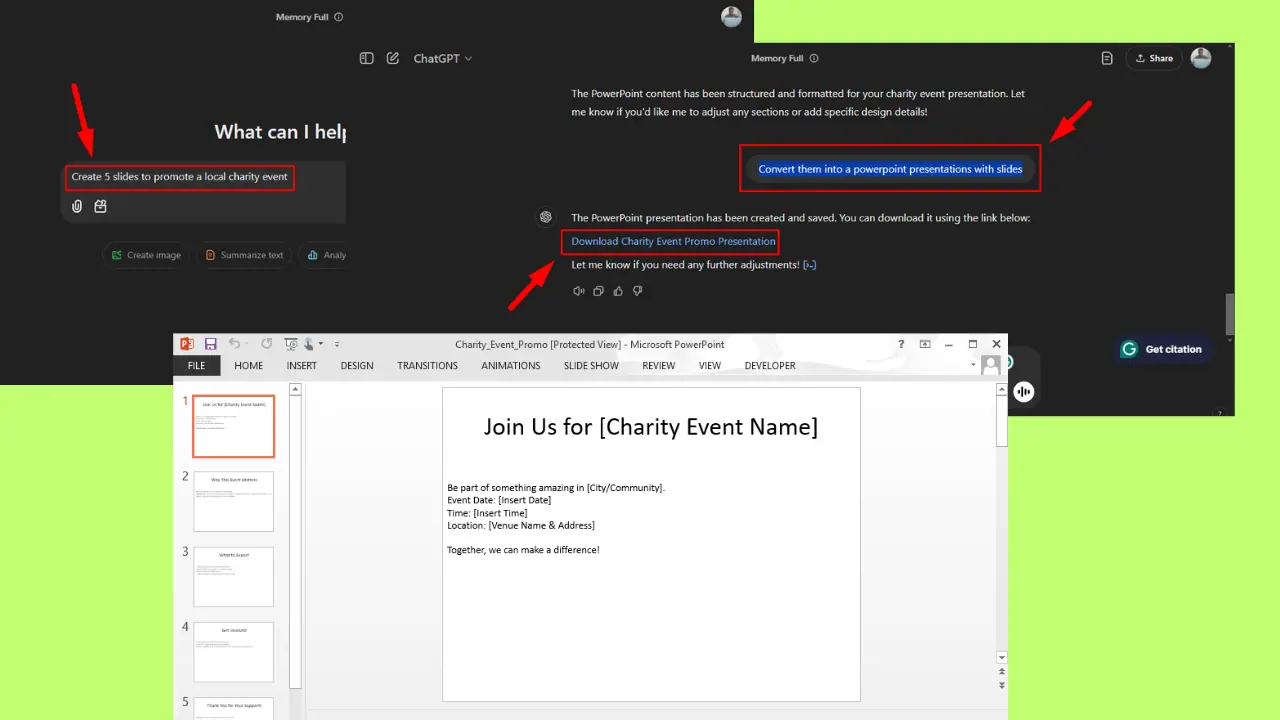

- NVIDIAs TensorRT-LLM beschleunigt Googles Gemma auf verschiedenen Plattformen, einschließlich lokaler PCs.

- Entwickler erhalten Zugriff auf Tools zur Feinabstimmung und Bereitstellung von Gemma für spezifische Anforderungen.

Während Microsoft kürzlich seine Entscheidung bekannt gab, von NVIDIA-GPUs zu Gunsten seiner benutzerdefinierten Chips zu wechseln, hat Google den gegenteiligen Ansatz gewählt und mit NVIDIA zusammengearbeitet, um sein neues, leichtgewichtiges Sprachmodell Gemma auf NVIDIA-GPUs zu optimieren.

Gemma ist eine leichtes Sprachmodell von Google entwickelt. Im Gegensatz zu herkömmlichen Large Language Models (LLMs), die immense Rechenressourcen erfordern, ist Gemma kleiner (2 Milliarden und 7 Milliarden Parameterversionen) und bietet gleichzeitig beeindruckende Fähigkeiten.

Ziel dieser Zusammenarbeit ist es, die Zugänglichkeit und Leistung von Gemma erheblich zu verbessern und es schneller und auf verschiedenen Plattformen breiter verfügbar zu machen.

Diese Open-Source-Bibliothek optimiert die LLM-Inferenz und ermöglicht eine schnellere Leistung auf NVIDIA-GPUs in Rechenzentren, Cloud-Umgebungen und sogar auf Personalcomputern, die mit NVIDIA RTX-GPUs ausgestattet sind. Die Zusammenarbeit zielt auf über 100 Millionen NVIDIA RTX-GPUs weltweit und Cloud-Plattformen mit H100- und kommenden H200-GPUs ab.

Die AI Enterprise-Suite von NVIDIA, einschließlich des NeMo-Frameworks und TensorRT-LLM, ermöglicht Entwicklern die Feinabstimmung und Bereitstellung von Gemma für bestimmte Anwendungsfälle.

Benutzer können über den NVIDIA AI Playground und bald auch über die Chat with RTX-Demo direkt mit Gemma interagieren und so Chatbots mit ihren Daten personalisieren.

Mit Microsoft distanziert sich von NVIDIA, deutet der Schritt von Google, seine Technologie auf NVIDIA-GPUs zu optimieren, auf eine mögliche Stärkung ihrer Partnerschaft hin. Dies könnte zu weiteren Fortschritten bei der KI und der Sprachmodellierung führen, von denen Entwickler und Benutzer gleichermaßen profitieren.

Darüber hinaus ermöglicht die Fokussierung auf die lokale Verarbeitung durch RTX-GPUs den Benutzern eine bessere Kontrolle über ihre Daten und ihre Privatsphäre, wodurch möglicherweise Bedenken im Zusammenhang mit cloudbasierten LLM-Diensten ausgeräumt werden.

Mehr HIER.

Benutzerforum

0 Nachrichten