Das Open-Source-Modell Mixtral 8x22B ist endlich da und kann über Torrent heruntergeladen werden

Bisher waren es ein paar arbeitsreiche Tage in der KI-Branche

2 Minute. lesen

Veröffentlicht am

Lesen Sie unsere Offenlegungsseite, um herauszufinden, wie Sie MSPoweruser dabei helfen können, das Redaktionsteam zu unterstützen Mehr Infos

Wichtige Hinweise

- Mistral brachte sein Spitzenmodell Mixtral 8x22B auf den Markt, während sich der Wettlauf um KI immer weiter verschärft.

- Das Open-Source-Modell verfügt über 176B Parameter und eine Kontextlänge von 65 Token

- Es kann über Torrent heruntergeladen werden.

Mistral ist mit einer großen Ankündigung zurück. Am Mittwoch zuvor brachte das von Microsoft unterstützte französische Unternehmen sein Spitzenmodell Mixtral 8x22B auf den Markt, während sich der Wettlauf um KI verschärft.

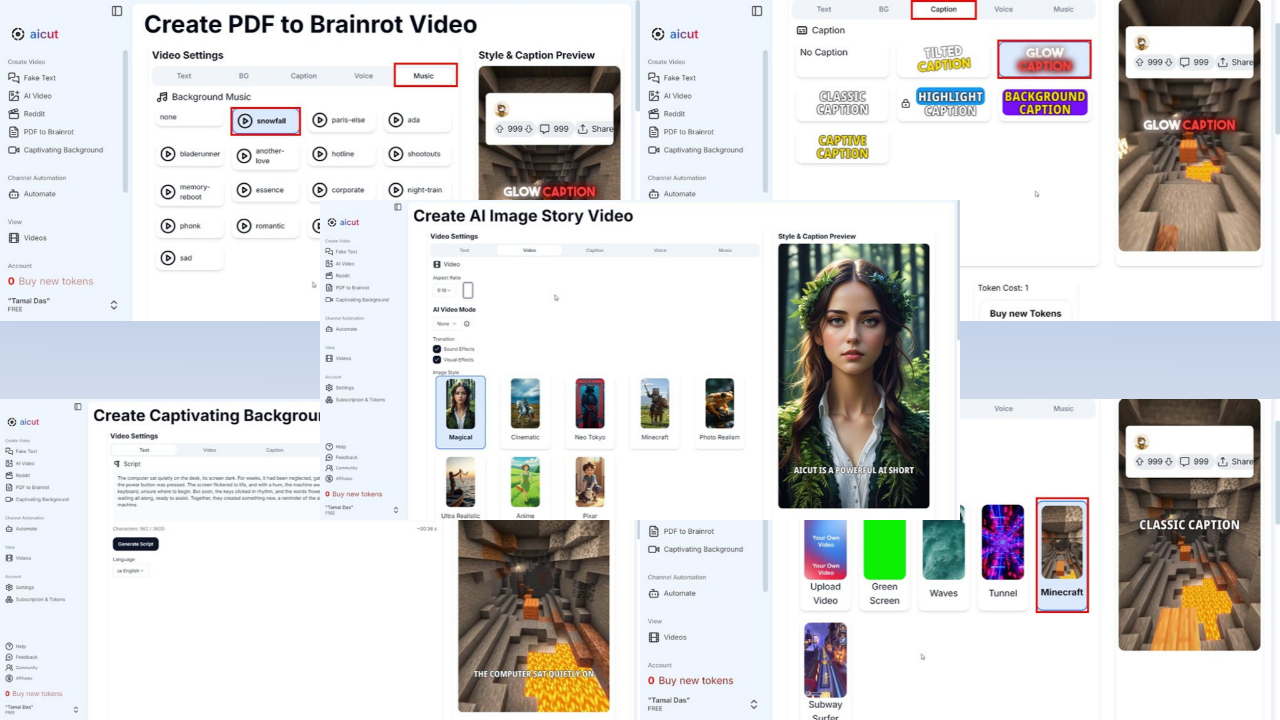

Das Beste daran? Es ist ein Open-Source-System und Sie können es über Torrent mit einer Dateigröße von 281 GB als KI-Startup herunterladen hat seinen Magnet-Link gepostet auf X (früher bekannt als Twitter). Es ist jetzt auch verfügbar auf Umarmendes Gesicht und Perplexity AI Labs.

Mistral besteht größtenteils aus ehemaligen Mitarbeitern von Google und Meta. Das Vorgängermodell des Unternehmens, Mixtral 8x7B, war ins Leben gerufen bereits im Dezember letzten Jahres, aber es soll Konkurrenten wie Llama-2 70B und OpenAIs GPT-3.5 in bestimmten Benchmarks wie MMLU, ARC Challenge, MBPP und anderen übertroffen haben.

Jetzt verfügt Mixtral 8x22B über 176B Parameter und eine Kontextlänge von 65 Token. Obwohl es riesig ist, benötigt es für jede Aufgabe nur einen kleineren Teil (44B), was die Nutzung kostengünstiger macht.

Es war zweifellos eine der geschäftigsten 24 Stunden in der KI-Branche. Google hat es endlich geschafft Gemini 1.5 Pro verfügbar in den meisten Ländern und benannte sein Duet AI for Developers in um Gemini-Code-Assistentund verlagert seine Infrastruktur von Codey auf Gemini.

Noch eine Neuigkeit von Meta, Die Informationen hat exklusiv berichtet, dass der Facebook-Besitzer bereit ist, nächste Woche eine kleinere Llama 3-Version herauszubringen.

Benutzerforum

0 Nachrichten