Microsoft DeBERTa übertrifft mickrige Menschen im SuperGlue-Leseverständnistest

2 Minute. lesen

Veröffentlicht am

Lesen Sie unsere Offenlegungsseite, um herauszufinden, wie Sie MSPoweruser dabei helfen können, das Redaktionsteam zu unterstützen Lesen Sie weiter

In letzter Zeit wurden massive Fortschritte bei Trainingsnetzwerken mit Millionen von Parametern erzielt. Microsoft hat vor Kurzem das DeBERTa-Modell (Decoding-enhanced BERT with disentangled Attention) aktualisiert, indem eine größere Version trainiert wurde, die aus 48 Transformer-Layern mit 1.5 Milliarden Parametern besteht. Die signifikante Leistungssteigerung lässt das einzelne DeBERTa-Modell die menschliche Leistung bei der Sprachverarbeitung und dem Sprachverständnis von SuperGLUE zum ersten Mal in Bezug auf die makrodurchschnittliche Punktzahl (89.9 gegenüber 89.8) übertreffen und die menschliche Grundlinie um eine anständige Marge übertreffen (90.3 gegenüber 89.8). . Der SuperGLUE-Benchmark besteht aus einer breiten Palette von Aufgaben zum Verständnis natürlicher Sprache, einschließlich der Beantwortung von Fragen und der Inferenz natürlicher Sprache. Das Modell steht auch an der Spitze der GLUE-Benchmark-Rangliste mit einem Makro-Durchschnittswert von 90.8.

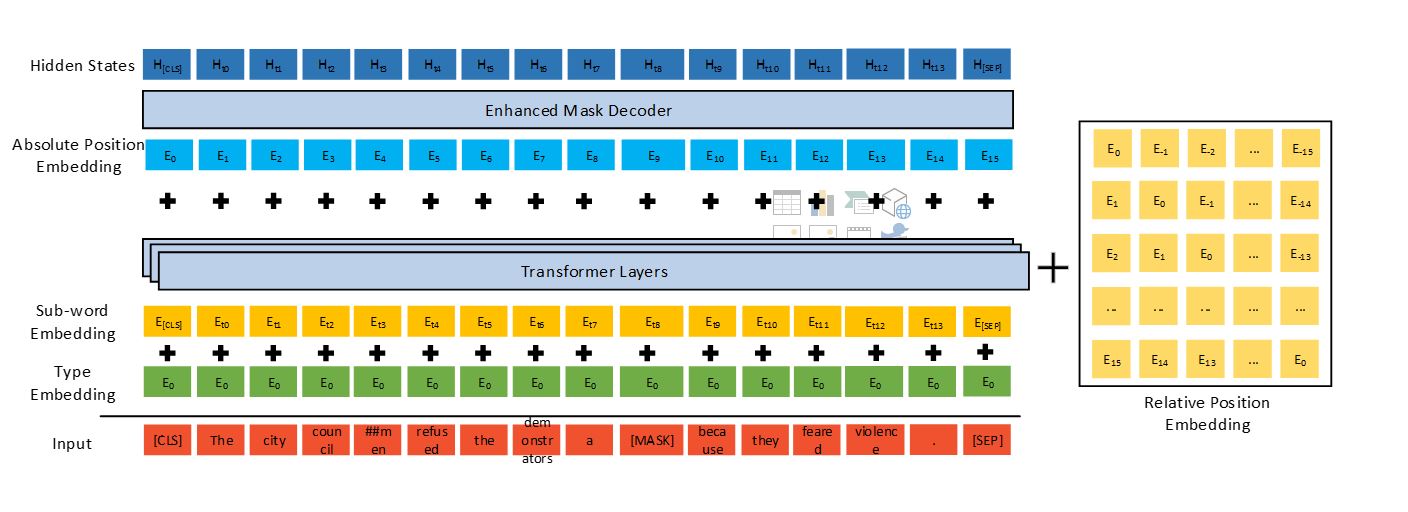

DeBERTa verbessert frühere hochmoderne PLMs (z. B. BERT, RoBERTa, UniLM) mithilfe von drei neuartigen Techniken: einem entwirrten Aufmerksamkeitsmechanismus, einem verbesserten Maskendecoder und einer virtuellen gegnerischen Trainingsmethode zur Feinabstimmung.

Im Vergleich zum T5-Modell von Google, das aus 11 Milliarden Parametern besteht, ist das DeBERTa mit 1.5 Milliarden Parametern viel energieeffizienter zu trainieren und zu warten, und es ist einfacher zu komprimieren und für Apps mit verschiedenen Einstellungen bereitzustellen.

DeBERTa, das die menschliche Leistung auf SuperGLUE übertrifft, markiert einen wichtigen Meilenstein in Richtung allgemeiner KI. Trotz seiner vielversprechenden Ergebnisse bei SuperGLUE erreicht das Modell keineswegs die menschliche Intelligenz von NLU. Menschen sind extrem gut darin, das aus verschiedenen Aufgaben erlernte Wissen zu nutzen, um eine neue Aufgabe ohne oder mit wenig aufgabenspezifischer Demonstration zu lösen.

Microsoft wird die Technologie in die nächste Version des Microsoft-Turing-Repräsentationsmodells für natürliche Sprache integrieren, das in Bereichen wie Bing, Office, Dynamics und Azure Cognitive Services verwendet wird und eine breite Palette von Szenarien mit Mensch-Maschine- und Mensch-Mensch-Interaktionen ermöglicht natürliche Sprache (wie Chatbot, Empfehlung, Beantwortung von Fragen, Suche, persönliche Unterstützung, Automatisierung des Kundensupports, Generierung von Inhalten und andere). Darüber hinaus wird Microsoft das DeBERTa-Modell mit 1.5 Milliarden Parametern und den Quellcode für die Öffentlichkeit freigeben.

Lesen Sie alle Details bei Microsoft hier.