Bing könnte bald die Möglichkeit haben, Bilder, Videos und andere Datentypen in Antworten zu verwenden

3 Minute. lesen

Veröffentlicht am

Lesen Sie unsere Offenlegungsseite, um herauszufinden, wie Sie MSPoweruser dabei helfen können, das Redaktionsteam zu unterstützen Lesen Sie weiter

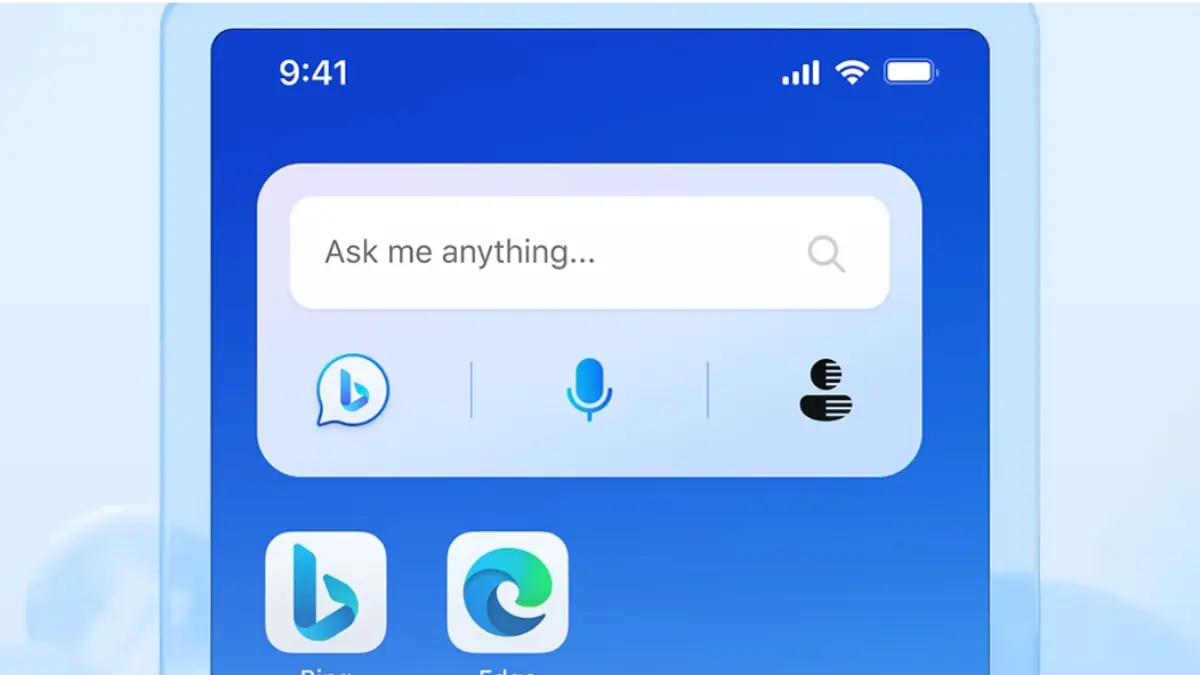

Das neues ChatGPT-betriebenes Bing verbessert sich kontinuierlich, und Microsoft könnte nächste Woche mit seiner größten Entwicklung beginnen. Andreas Braun, CTO von Microsoft Deutschland, gab kürzlich bekannt, dass GPT-4 nächste Woche kommt. Daneben deutete die Exekutive „multimodale Modelle an, die ganz andere Möglichkeiten bieten werden“.

Microsoft hat bereits Milliarden von Dollar in seine KI-Initiativen investiert, insbesondere in die unermüdliche Verbesserung von Bing, um besser mit Google konkurrieren zu können. Jetzt bestätigte der Softwareriese die Ankunft von GPT-4 nächste Woche, das voraussichtlich in seine Suchmaschine und seinen Chatbot eingefügt wird.

Vor der Veröffentlichung von ChatGPT Bing gab es Gerüchte über Bing mit GPT-4. Microsoft hat jedoch stattdessen das GPT-3.5-Modell neben seiner proprietären Technologie verwendet Prometheus, wodurch Bing aktuelle Daten generieren kann. Obwohl das neue Bing noch nicht für alle verfügbar ist, hat das Unternehmen überraschenderweise bereits Pläne, der Suchmaschine über das kommende GPT-4 einen deutlichen Schub zu verleihen.

Das neue und kommende Large Language Model von OpenAI soll es dem Bing-Chatbot ermöglichen, schneller Ergebnisse zu generieren, was eine große Hilfe sein kann, da die aktuelle Version normalerweise einige Sekunden braucht, um mit der Generierung von Antworten zu beginnen. Abgesehen von der Geschwindigkeit könnte jedoch eine multimodale Fähigkeit das Größte sein, was die neue LLM-Einführung bringen könnte.

Bei Microsofts AI in Focus – Digital Kickoff-Event teilte Braun einige Details darüber mit, was vom Eintritt eines neuen LLM zu erwarten ist. (über Heise)

„Wir werden GPT-4 nächste Woche vorstellen, dort werden wir multimodale Modelle haben, die ganz andere Möglichkeiten bieten werden – zum Beispiel Videos“, sagte Braun, der LLM als „Game Changer“ bezeichnete.

Darüber hinaus bestätigte Braun, dass Microsoft plant, die Modelle mithilfe der Multimodalitätsfunktion „umfassend zu machen“. Einmal injiziert, sollte dies Bing ermöglichen, eine Vielzahl von Daten bei der Beantwortung von Fragen bereitzustellen, was bedeutet, dass es auch Videos, Bilder und andere Datentypen verarbeiten könnte. Dies sollte zu besseren Antworten führen und Bing zu einem effektiveren Suchassistenten für alle machen.

Andererseits ist es wichtig zu beachten, dass Bing nicht der erste in der Multimodalität ist. In letzter Zeit, Du kommst führte seine multimodale Chat-Suchfunktion ein, die es Benutzern ermöglicht, Text- und Spracheingaben bereitzustellen und Antworten über Konversationstexte hinaus zu erhalten. Die Suchmaschine kämpft jedoch noch um die Aufmerksamkeit der Öffentlichkeit. Obwohl Bing noch nicht vollständig für alle zugänglich ist, hat es bereits eine kontinuierlich wachsende Warteliste. Die Injektion einer multimodalen Fähigkeit wird sicherlich seine Konkurrenten wie You.com betreffen. Es ist jedoch noch früh zu sagen, wie groß dieser Effekt sein wird, da Brauns Ankündigung nur sehr wenige Details bestätigt.