Mixtral 8x22B open source-model er endelig ankommet, kan downloades via Torrent

Det har været nogle travle dage i AI-branchen indtil videre

2 min. Læs

Udgivet den

Læs vores oplysningsside for at finde ud af, hvordan du kan hjælpe MSPoweruser med at opretholde redaktionen Læs mere

Nøgle noter

- Mistral lancerede sin frontier-model, Mixtral 8x22B, mens kapløbet om AI varmer op.

- Open source-modellen har 176B parametre og en kontekstlængde på 65K tokens

- Det kan downloades via Torrent.

Mistral er tilbage med en stor meddelelse. Tidligere onsdag lancerede det franske, Microsoft-støttede firma sin frontiermodel, Mixtral 8x22B, mens kapløbet om kunstig intelligens varmer op.

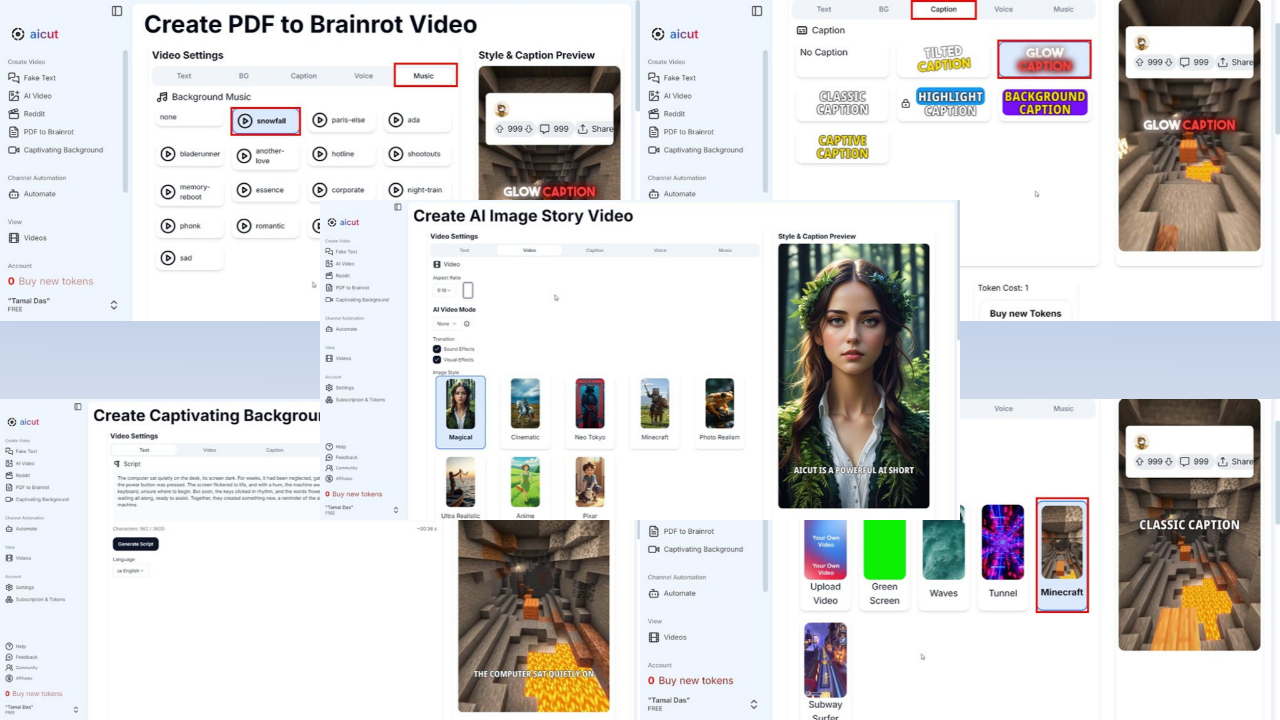

Den bedste del af det? Det er et open source-system, og du kan downloade det via Torrent ved 281 GB i filstørrelse som AI-start postede sit magnetlink på X (tidligere kendt som Twitter). Den er nu også tilgængelig på KrammerFace og Perplexity AI Labs.

Mistral består for det meste af tidligere ansatte hos Google og Meta. Virksomhedens forgængermodel, Mixtral 8x7B, var lanceret tilbage i december sidste år, men det siges at have overgået rivaler som Llama-2 70B og OpenAI's GPT-3.5 i visse benchmarks som MMLU, ARC Challenge, MBPP og andre.

Nu har Mixtral 8x22B 176B parametre og en kontekstlængde på 65K tokens. Selvom den er enorm, bruger den kun en mindre del (44B) til hver opgave, hvilket gør den mere overkommelig at bruge.

Det har uden tvivl været et af de travleste 24 timer i AI-industrien. Google har endelig lavet Gemini 1.5 Pro tilgængelig i de fleste lande og omdøbte sin Duet AI til udviklere som Gemini Code Assist, flytte sin infrastruktur fra Codey til Gemini.

Endnu en nyhed fra Meta, Oplysningerne har udelukkende rapporteret, at Facebook-ejeren er klar til at lancere en mindre Llama 3-version i næste uge.

Brugerforum

0 meddelelser