Meta AI siger, at Trumps mordforsøg ikke fandt sted. Så giver det hallucination skylden

Llama 3.1, som driver chatbotten, har vidensgrænse i december 2023.

2 min. Læs

Udgivet den

Læs vores oplysningsside for at finde ud af, hvordan du kan hjælpe MSPoweruser med at opretholde redaktionen Læs mere

Nøgle noter

- Metas AI mishandlede en politisk begivenhed og nægtede fejlagtigt et mordforsøg på Trump.

- VP Joel Kaplan undskyldte og tilskrev fejlen til AI-"hallucinationer" og forældede data.

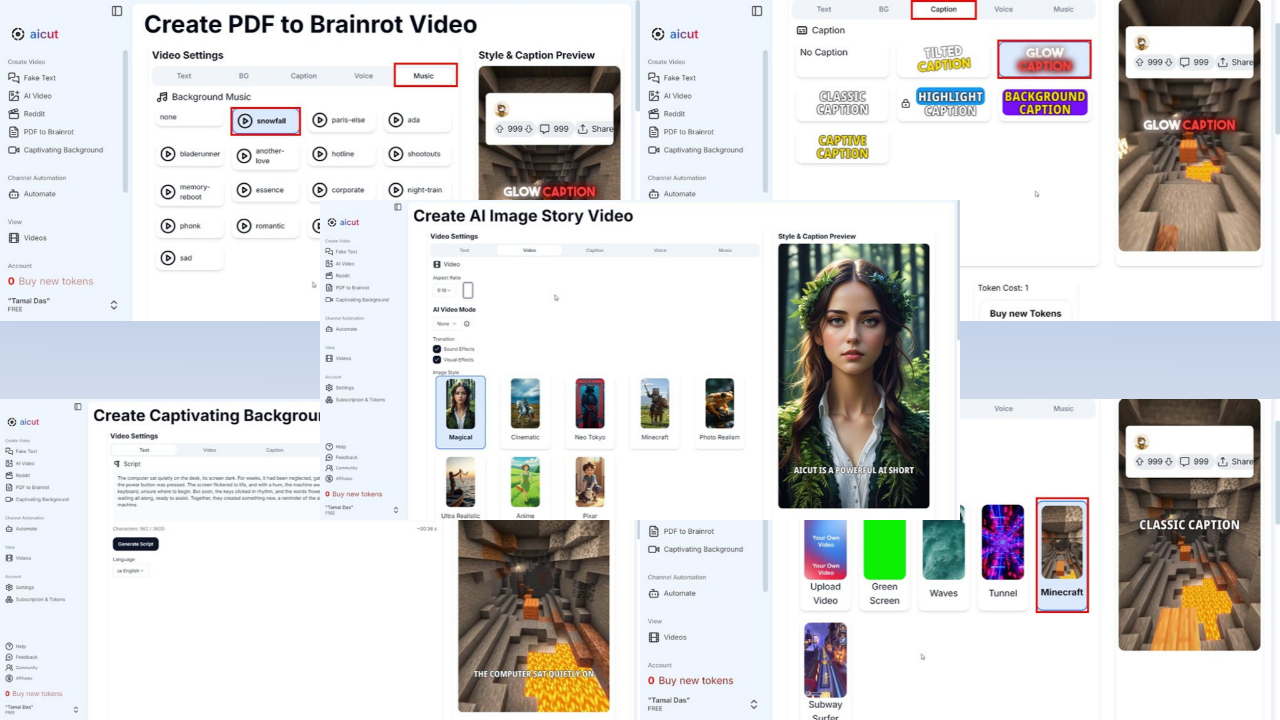

- Metas Llama 3.1-model kæmper ligesom andre AI med nøjagtighed i realtid og nyheder.

Meta blev for nylig smidt under bussen for forkert håndtering af politisk indhold. Teknikgiganten Menlo Park har tidligere slået et faktatjek på et ægte foto af tidligere præsident Trump efter hans attentatforsøg, og dets Meta AI har forkert hævdet at forsøget ikke fandt sted.

Joel Kaplan, Metas VP for Global Policy, har udsendt en undskyldning i et nyt blogindlæg, og tilskrev virksomhedens seneste AI-fejl – hvor assistenten fejlagtigt hævdede, at mordforsøget på tidligere præsident Donald Trump ikke skete – til "hallucinationer" i AI's svar.

Han siger også, at Meta AI - ligesom enhver anden AI-chatbot med videnudskæringer som ChatGPT - ikke altid har været den mest præcise, når det kommer til nyheder på grund af afhængighed af forældede data. For at undgå fejl om sådanne nyheder blokerede Meta oprindeligt svar om emnet, men stødte stadig på problemer med unøjagtigheder.

Sådan et fænomen kaldes "hallucinationer" i AI-verdenen. Det er et tilfælde, hvor en sprogmodel genererer forkerte eller vildledende oplysninger, som ikke var til stede i dens træningsdata. Det sker, fordi AI forudsiger svar baseret på mønstre i de data, den blev trænet på, snarere end faktuel nøjagtighed i realtid, så den måtte jappe og formulere svar.

Meta AI chatbot, som er tilgængelig på tværs af Facebook, Instagram og WhatsApp, er drevet af den seneste Lama 3.1 model med viden cutoff i december 2023. OpenAIs ChatGPT er derimod i oktober 2023.

Brugerforum

0 meddelelser