Du skal muligvis vente lidt længere for at få muligheden for billedoverførsel til Bings multimodale funktion

2 min. Læs

Udgivet den

Læs vores oplysningsside for at finde ud af, hvordan du kan hjælpe MSPoweruser med at opretholde redaktionen Læs mere

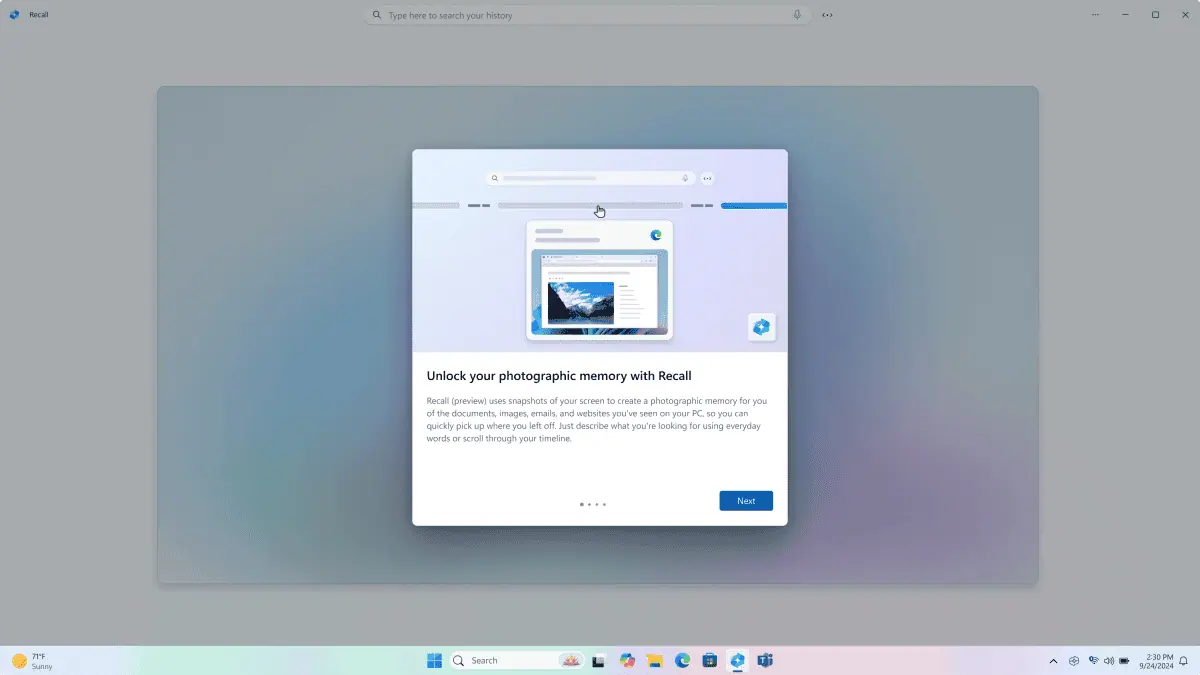

OpenAI frigav officielt GPT-4, og Microsoft afslørede, at modellen var "tilpasset til søgning." En del af denne spændende åbenbaring er modellens multimodale kapacitet, der gør det muligt for den at behandle billeder. Denne funktion er dog stadig begrænset selv på Bing. Endnu mere kan det stadig være langt at uploade billeder for at udnytte denne funktion, som en af Microsofts medarbejdere antydede.

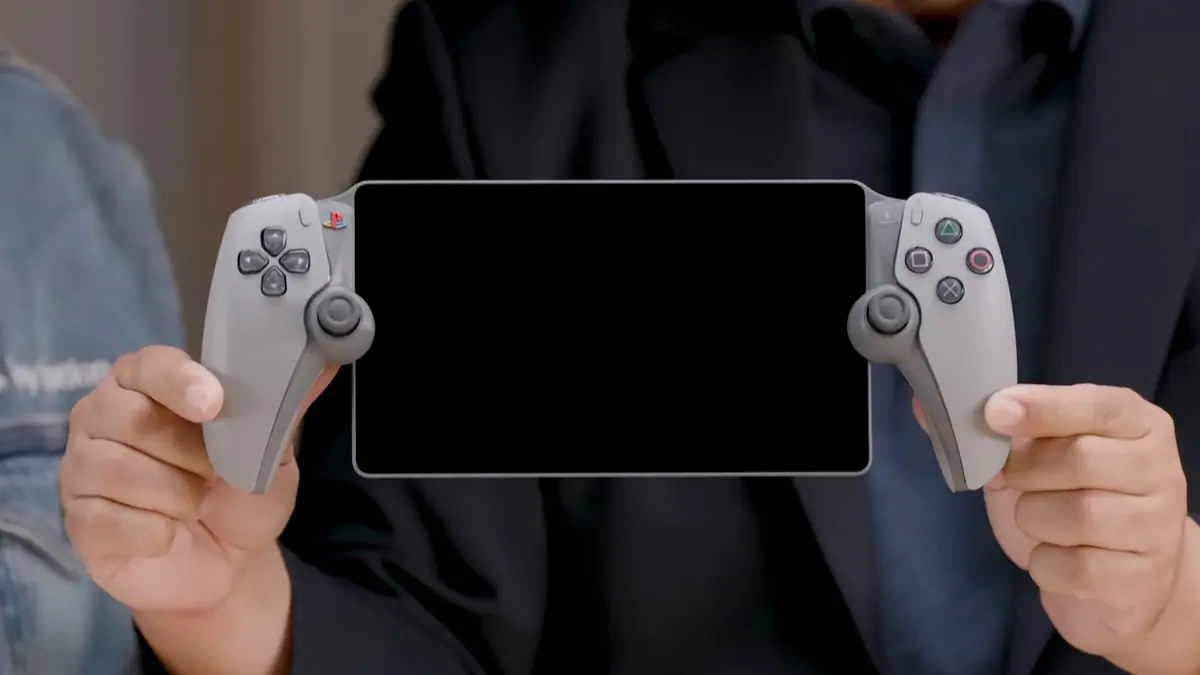

Multimodalitet er det største højdepunkt i OpenAIs seneste model. Og mens GPT-4 allerede er tilgængelig for abonnenter på ChatGPT Plus, funktionen er stadig under test, hvilket gør den utilgængelig for alle. Ikke desto mindre viste OpenAI i sit seneste blogindlæg, hvordan multimodaliteten ville fungere i GPT-4, som grundlæggende kan beskrive og fortolke uploadede billeder.

Wow Bing kan nu faktisk beskrive billeder, nu hvor den ved, at den bruger GPT-4!

byu/BroskiPlaysYT inbing

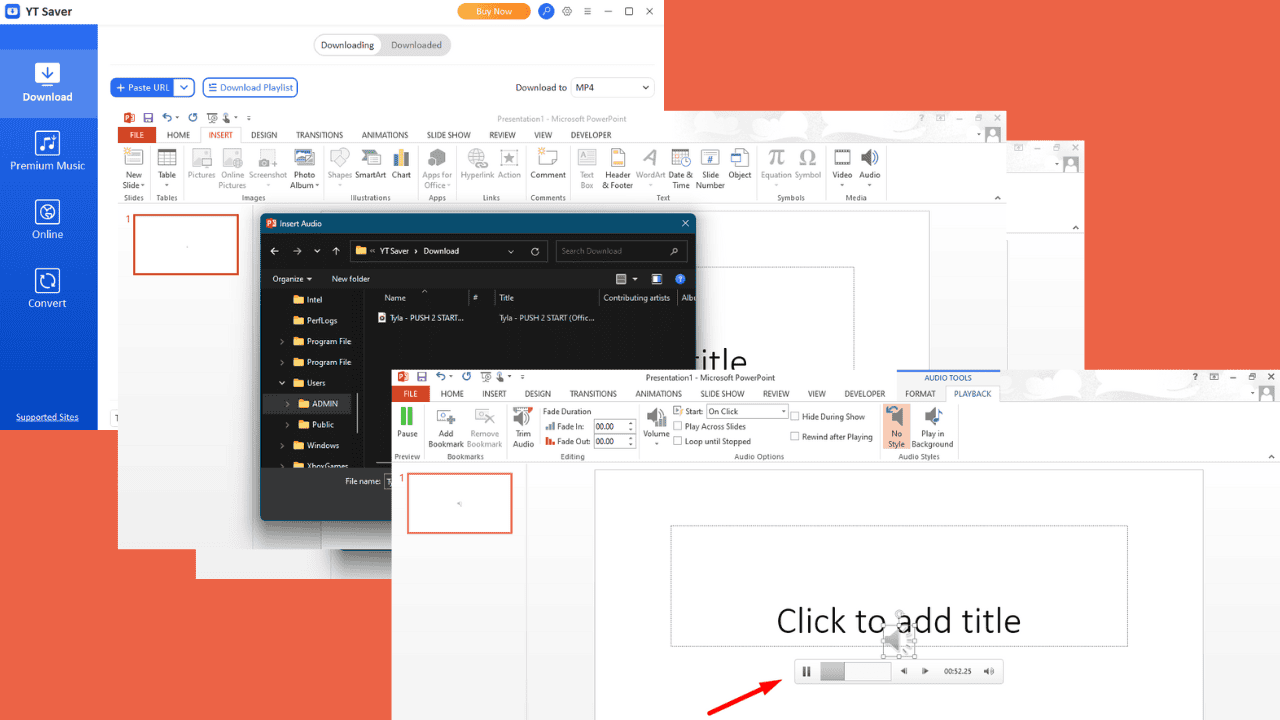

Denne multimodale kapacitet er tilsyneladende tilgængelig nu på ny Bing, dog ikke fuldt ud. Til at starte med kan brugere bede Bing Chat om at beskrive billeder ved hjælp af billedlinks taget fra nettet, og det vil generere et svar. Derudover vil chatbotten nu inkludere billeder i sin proces, især hvis du spørger den.

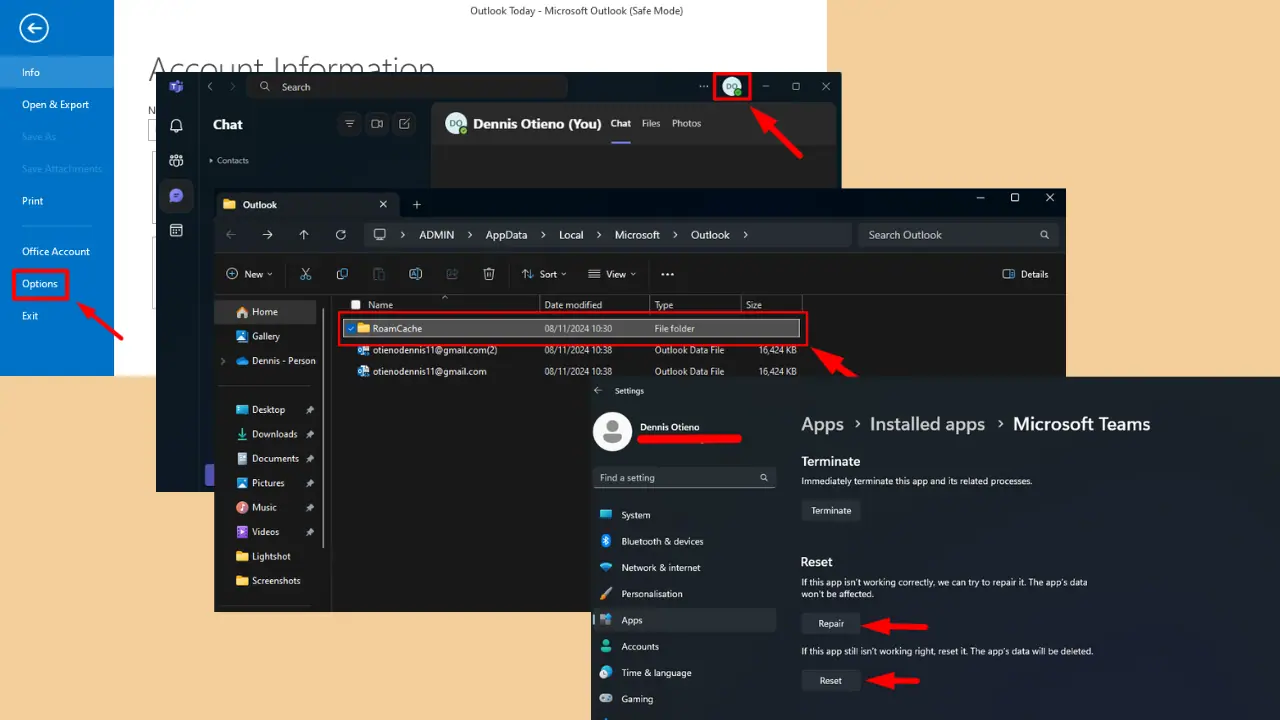

På den anden side er muligheden for direkte at uploade et billede, som Bing kan beskrive eller analysere, stadig ikke tilgængelig. Ankomsten af denne mulighed blev for nylig rejst af en bruger på Twitter til Mikhail Parakhin, Microsofts chef for annoncering og webtjenester, som foreslog, at det ikke er virksomhedens prioritet for nu.

Det er meget dyrere, vi skal først udrulle den nuværende funktionalitet bredt. Det handler om at bringe flere GPU'er ind.

— Mikhail Parakhin (@MParakhin) Marts 14, 2023

For at gøre dette muligt bemærkede Parakhin behovet for "flere GPU'er" og sagde, at det var "meget dyrere." I en nylig indberette, afslørede Microsoft, at det allerede havde brugt hundredvis af millioner af dollars på at bygge en ChatGPT supercomputer ved at forbinde tusindvis af Nvidia GPU'er på sin Azure cloud computing platform. Med dette, hvis Parakhins ord tages seriøst, søger Microsoft måske at bruge mere for fuldstændigt at bringe den multimodale funktion til Bing. Og baseret på hvad Parakhin sagde, er dette muligt, bare ikke i dag.

Brugerforum

0 meddelelser