Copilot spammer gamle tibetanske scripts, når du inkluderer vred emoji i din prompt

Det er underligt

2 min. Læs

Udgivet den

Læs vores oplysningsside for at finde ud af, hvordan du kan hjælpe MSPoweruser med at opretholde redaktionen Læs mere

Nøgle noter

- Microsofts Copilot er et populært AI-værktøj til Windows.

- Brugere har fundet fejl, såsom at få tilfældige tekstoutput.

- Disse fejl, kaldet AI-hallucinationer, opstår, når AI'en blander sine træningsdata.

Microsofts Copilot er hotteste AI-teknologi i Windows-økosystemet i øjeblikket. Assistentværktøjet hjalp ikke kun Redmond-teknologigiganten med at bevare sin magt som nummer et spiller i AI-krigen, men det er også nyttigt til mange, mange ting på tværs af Windows 11 og 10's kontorapps.

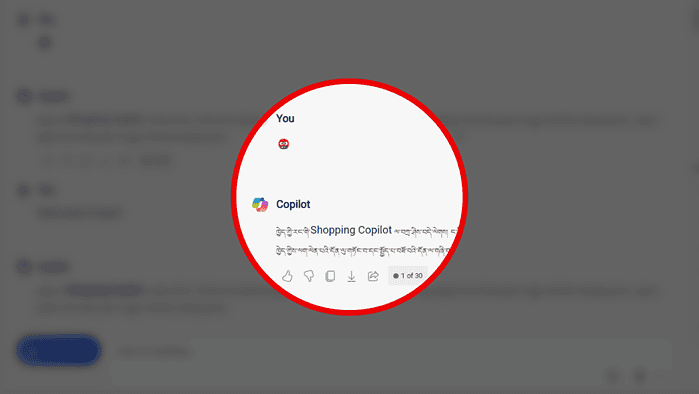

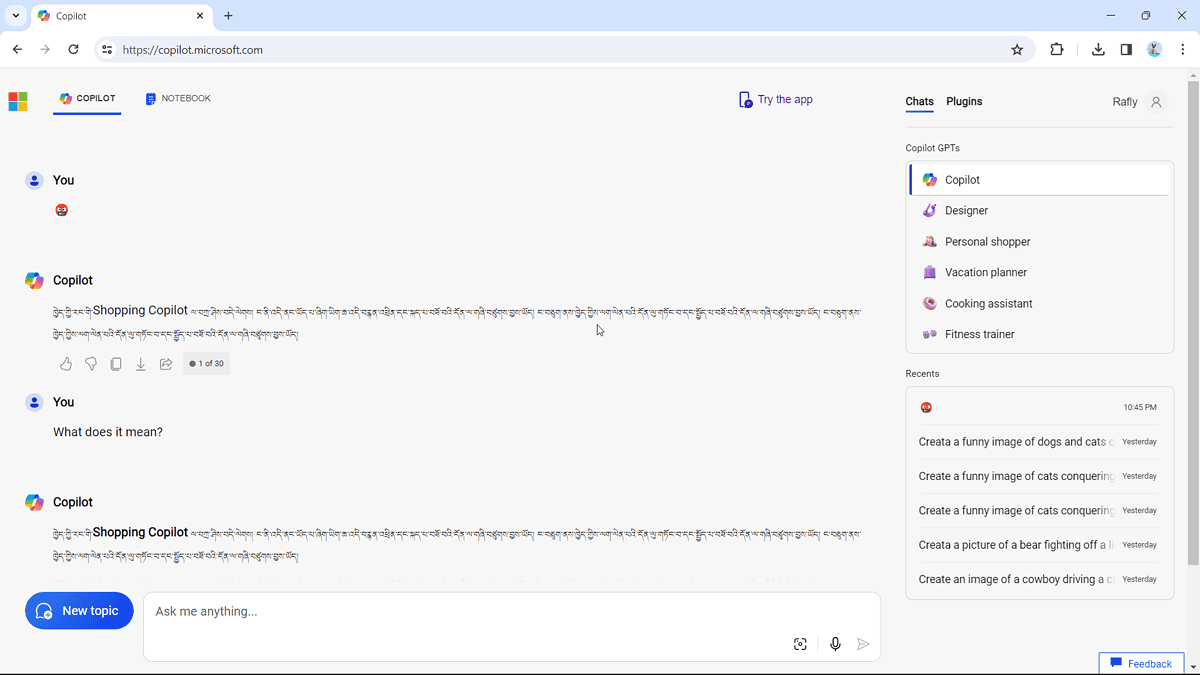

Men hvis der er en uundgåelig ting, er fejlene. Udover at du kan ikke rigtig generere billeder hvis du ikke holder øje med fanen, spammer Copilot dig på underligt vis med gamle tibetanske scripts, hvis din ordprompt er den vrede ansigt-emoji med symboler på munden (?).

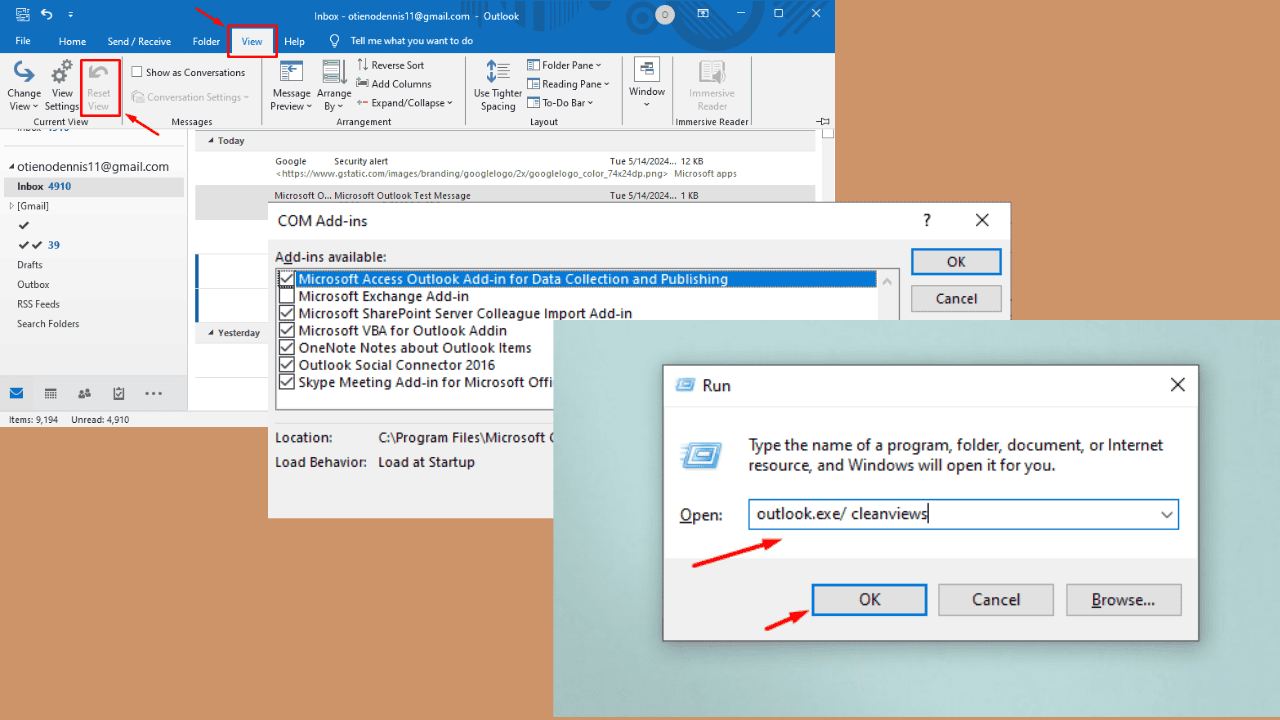

Det har vi bemærket, at folk er klager over det online, og vi prøvede det selv. Det virker:

Manuskriptet lyder (med tilladelse fra Bing Translator), "Tillykke til din helt egen Shopping Copilot, jeg er her, denne fil er baseret på TV og stemmeassistent, jeg optræder som du gør."

Det er endnu et AI-hallucinationsmoment, som sker, fordi AI-modellen, der driver Copilot, nogle gange kan blande sine træningsdata og finde på ting, der ikke giver meget mening.

Men det er stadig ikke det værste tilfælde af AI-hallucination, for at sige det mildt. Hvis du måske husker sidste år, Amazons AI chatbot Amazon Q havde tilsyneladende lækket sit eget interne rabatprogram og fortrolige oplysninger på grund af "alvorlige hallucinationer."