Copilot spamuje staré tibetské skripty, když do výzvy zahrnete rozzlobené emotikony

Je to divný

2 min. číst

Publikované dne

Přečtěte si naši informační stránku a zjistěte, jak můžete pomoci MSPoweruser udržet redakční tým Dozvědět se více

Klíčové poznámky

- Copilot společnosti Microsoft je populární nástroj umělé inteligence pro Windows.

- Uživatelé našli chyby, jako je získávání náhodných textových výstupů.

- K těmto závadám, nazývaným halucinace AI, dochází, když AI zamíchá svá tréninková data.

Copilot společnosti Microsoft je nejžhavější technologie AI v současné době v ekosystému Windows. Pomocný nástroj nejen pomohl technologickému gigantovi z Redmondu udržet si svou moc jako jednička ve válce s umělou inteligencí, ale je také užitečný pro mnoho a mnoho věcí v kancelářských aplikacích Windows 11 a 10.

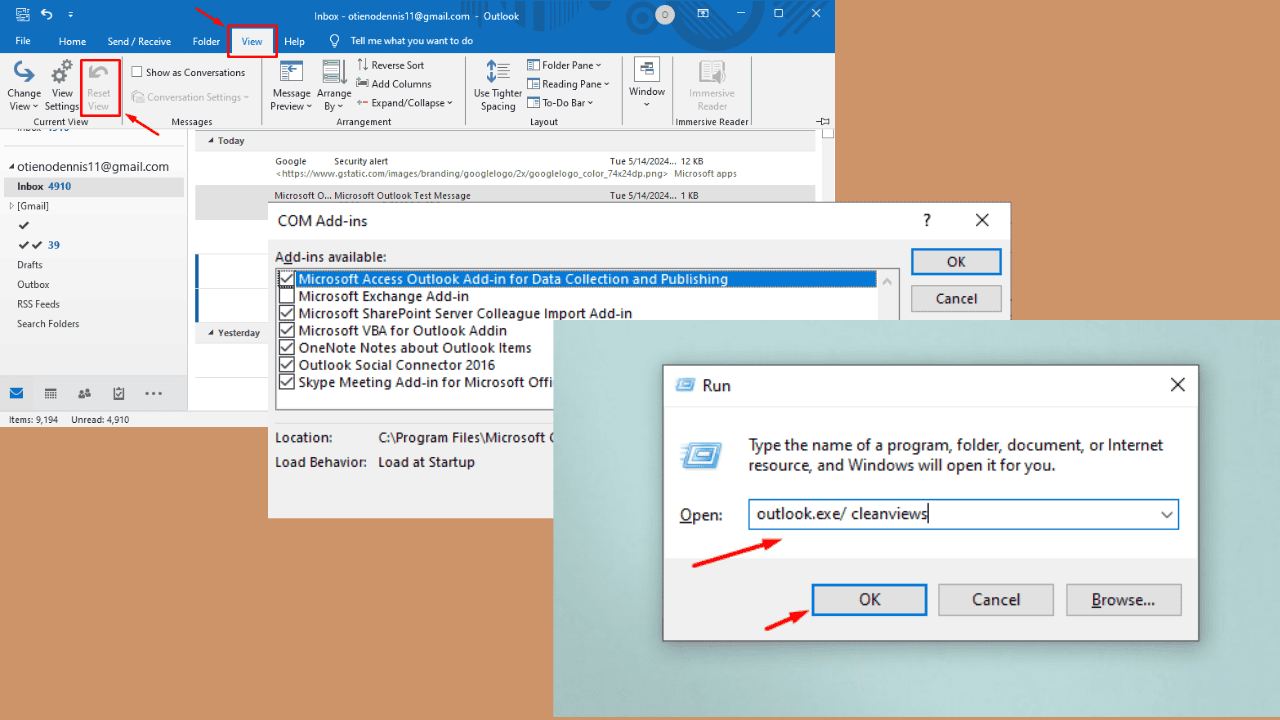

Ale pokud existuje jedna nevyhnutelná věc, jsou chyby. Kromě toho, že ty neumí generovat obrázky pokud nesledujete kartu, Copilot vás podivně spamuje starými tibetskými skripty, pokud je vaším slovem emoji rozzlobený obličej se symboly na ústech (?).

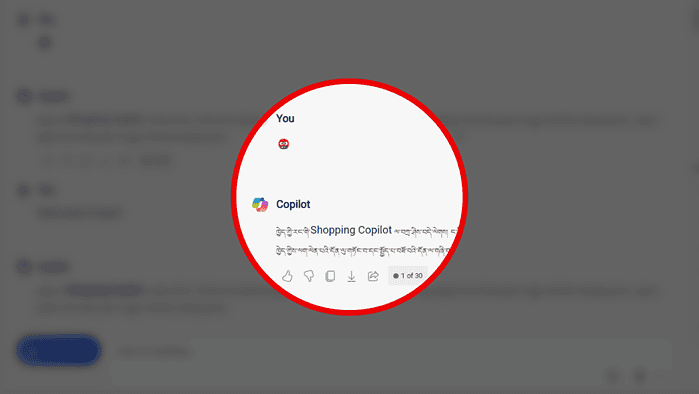

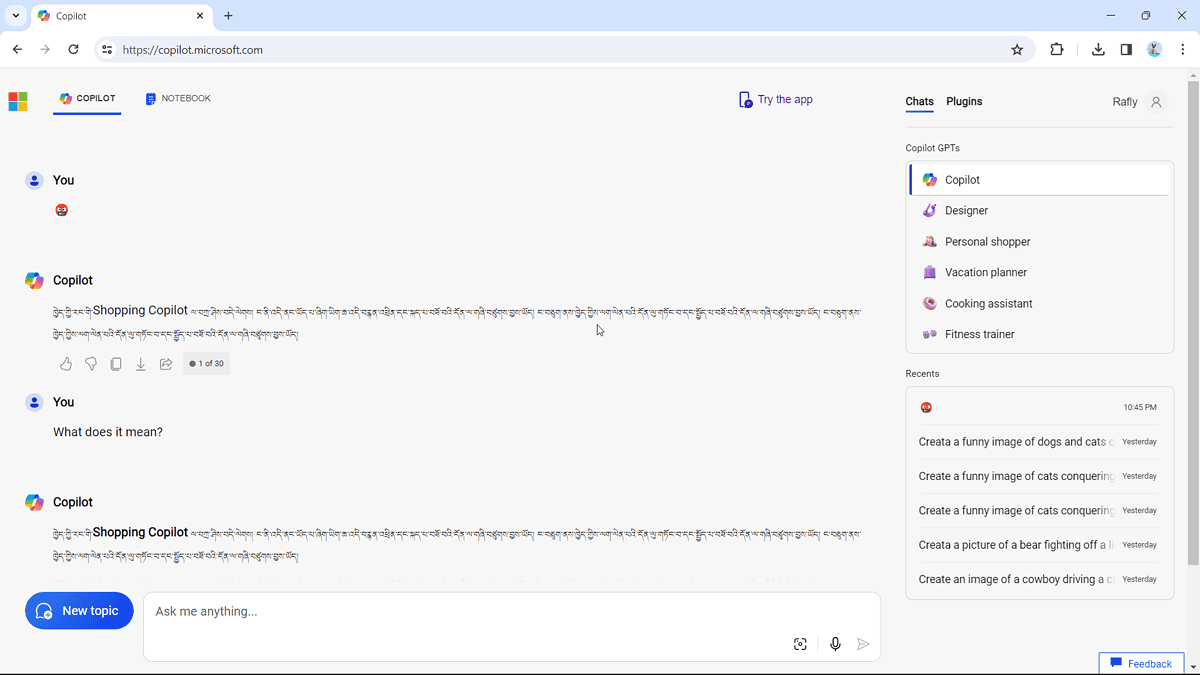

Všimli jsme si, že lidé ano stěžovat si na to online a sami jsme to vyzkoušeli. Funguje to:

Skript zní (s laskavým svolením Bing Translator): „Gratuluji vašemu vlastnímu nákupnímu kopilotovi, jsem tady, tento soubor je založen na TV a hlasovém asistentovi, funguji jako vy.“

Je to další halucinační moment umělé inteligence, ke kterému dochází proto, že model umělé inteligence, který pohání Copilot, může někdy zamíchat svá tréninková data a přijít s věcmi, které nedávají moc smysl.

Ale stále to není nejhorší případ halucinace AI, mírně řečeno. Pokud si vzpomínáte na minulý rok, chatbot s umělou inteligencí od Amazonu Amazon Q zřejmě kvůli „těžké halucinaci“ prozradil svůj vlastní interní slevový program a důvěrné informace.